阿里开源QwQ-32B推理模型!32.5B vs 671B|仅需1/10成本

团队探讨了大规模强化学习(RL)对大语言模型的智能的提升作用,同时很高兴推出我们最新的推理模型 QwQ-32B。阿里巴巴最新开源的QwQ-32B推理模型,以其仅32.5B参数的紧凑架构挑战千亿参数模型的智能边界。开源先锋,引领全球AI新格局。技术团队透露,下一代QwQ-64B模型将采用创新的"液态神经网络"架构,目标在保持32B级别参数量的同时,实现DeepSeek R1 90%的推理能力。),甚

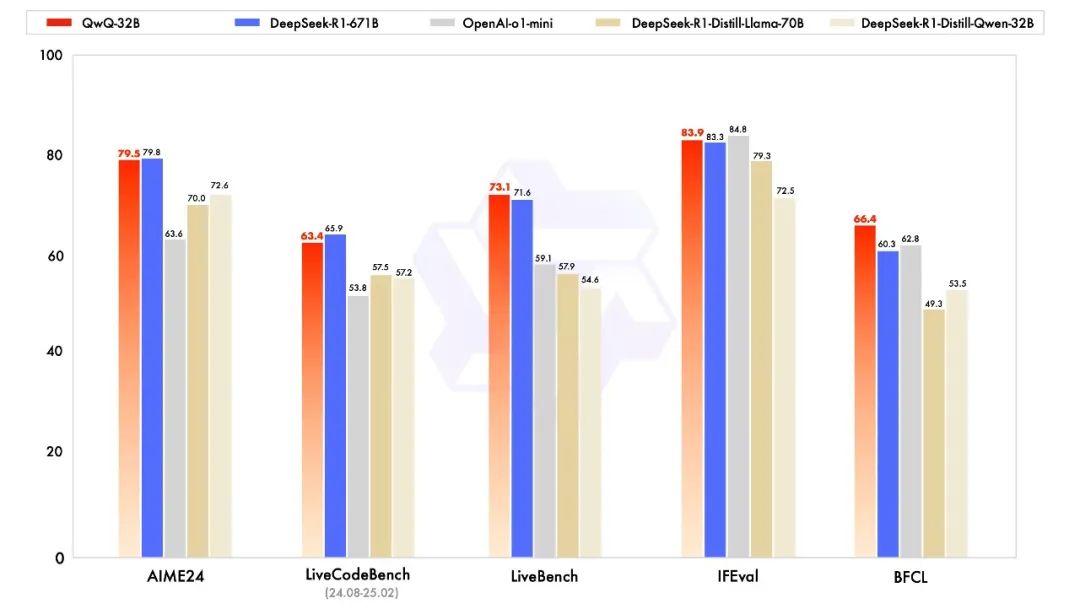

阿里巴巴最新开源的QwQ-32B推理模型,以其仅32.5B参数的紧凑架构挑战千亿参数模型的智能边界。该模型基于Qwen2.5架构深度优化,采用"预训练-监督微调-强化学习"三阶段训练范式,在参数效率维度实现重大突破。尽管参数量仅为DeepSeek R1总参数量的1/20(32.5B vs 671B),甚至低于其37B的激活参数量,但在特定领域展现出与顶级闭源模型抗衡的潜力,或接近DeepSeek R1智能水平。

根据官方披露的测试结果,QwQ-32B在数学、编程、通用能力方面取得了领先优势,多项关键评测中表现非常:

核心架构创新

基础架构设计

参数效率革命:通过动态稀疏激活技术,实际推理时激活参数仅占理论值的52%,较传统密集模型提升3倍计算效率

混合精度训练:采用BF16精度训练框架,在保持数值稳定性的同时,相较于FP32训练内存占用降低40%

存储优化设计:原生模型体积仅65GB,较DeepSeek R1的671GB缩减90%,更适合边缘计算部署

硬件适配特性

FP8兼容架构:虽然原生版本采用BF16,但通过动态量化技术可实现FP8推理,在NVIDIA H100等支持FP8的硬件上,每前向传播计算量较DeepSeek R1减少28%

动态内存管理:开发自适应缓存压缩算法,在处理131k tokens长上下文时,显存占用较基线模型降低37%

评测速报:优势与挑战

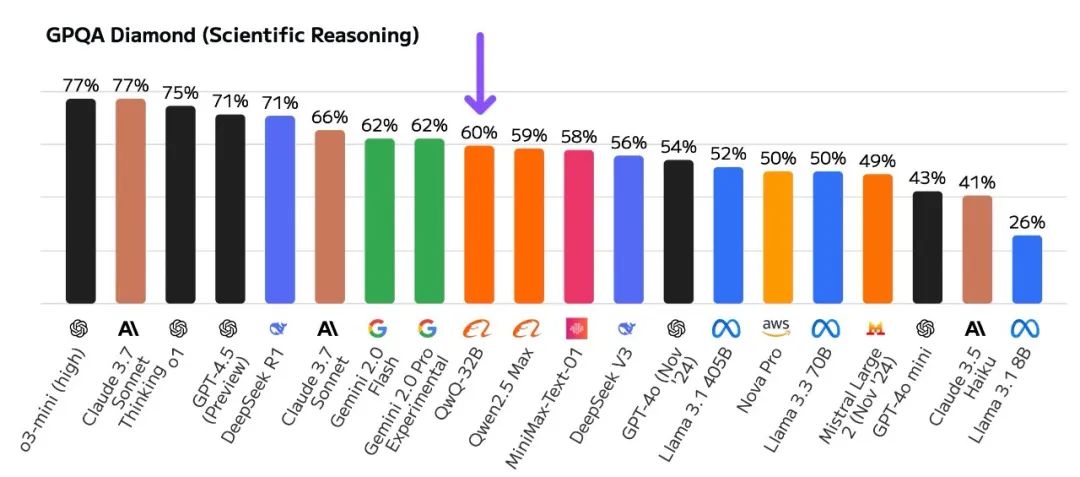

GPQA Diamond 评测

QwQ-32B得分 59.5%,显著落后于DeepSeek R1(71%),略逊于Gemini 2.0 Flash(62%)。

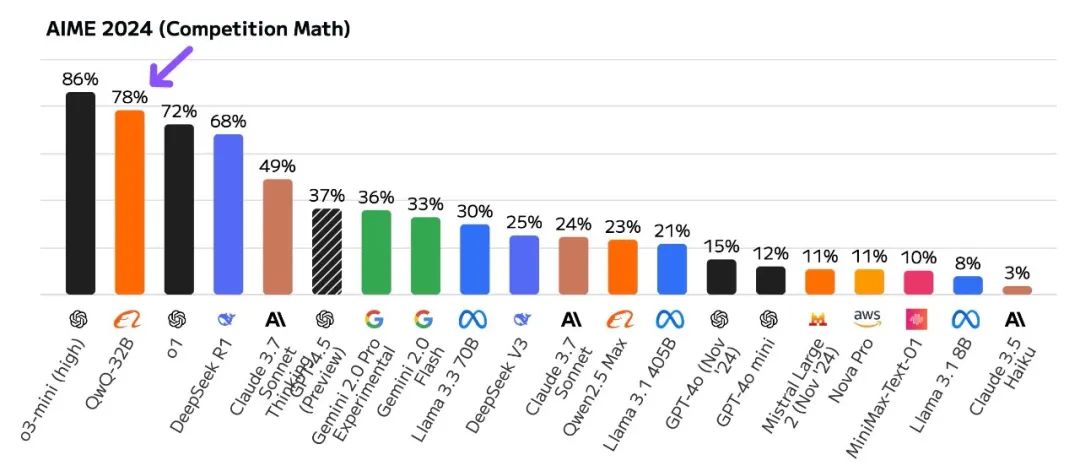

AIME 2024评测

QwQ-32B以 78% 的得分反超DeepSeek R1,仅次于一骑绝尘的o3-mini-high模型。

解读:在复杂学术推理(GPQA)上仍有差距,但在医学诊断推理(AIME)中表现亮眼,验证了阿里“轻量高效”的技术路线潜力。

QwQ-32B: 强化学习

大规模强化学习(RL)有潜力超越传统的预训练和后训练方法来提升模型性能。近期的研究表明,强化学习可以显著提高模型的推理能力。例如,DeepSeek R1 通过整合冷启动数据和多阶段训练,实现了最先进的性能,使其能够进行深度思考和复杂推理。

团队探讨了大规模强化学习(RL)对大语言模型的智能的提升作用,同时很高兴推出我们最新的推理模型 QwQ-32B。这是一款拥有 320 亿参数的模型,其性能可与具备 6710 亿参数(其中 370 亿被激活)的 DeepSeek-R1 媲美。这一成果突显了将强化学习应用于经过大规模预训练的强大基础模型的有效性。团队还在推理模型中集成了与 Agent 相关的能力,使其能够在使用工具的同时进行批判性思考,并根据环境反馈调整推理过程。团队希望证明强大的基础模型叠加大规模强化学习也许是一条通往通用人工智能的可行之路。

结语

QwQ-32B的诞生标志着语言模型"深度思考"的质变。开源先锋,引领全球AI新格局。目前QwQ-32B开源后已经在HuggingFace全球模型趋势位列第一。

QwQ-32B的开源标志着中国AI社区在高效推理模型领域取得重要突破。尽管在GPQA等专业基准上尚存差距,但其在AIME等临床推理任务的表现已展现巨大应用潜力。随着阿里巴巴持续迭代优化(GitHub仓库星标数已突破15k),该模型正在重新定义中等规模语言模型的性能边界。

技术团队透露,下一代QwQ-64B模型将采用创新的"液态神经网络"架构,目标在保持32B级别参数量的同时,实现DeepSeek R1 90%的推理能力。

模型下载

OpenCSG社区:

https://opencsg.com/models/Qwen/QwQ-32B

Qwen Chat:

https://chat.qwen.ai

官方博客:

https://qwenlm.github.io/zh/blog/qwq-32b/

更多推荐

已为社区贡献22条内容

已为社区贡献22条内容

所有评论(0)