win本地部署Dify,并接入deepseek-r1

参考需要安装的软件有本机环境:win10企业版21H2,i5-12400,16GB,集显无独立显卡。

文章目录

参考Dify官方部署文档

需要安装的软件有Docker(提供Dify运行的虚拟机环境)、ollama(通过该平台可接入deepseek)

本机环境:win10企业版21H2,i5-12400,16GB,集显无独立显卡

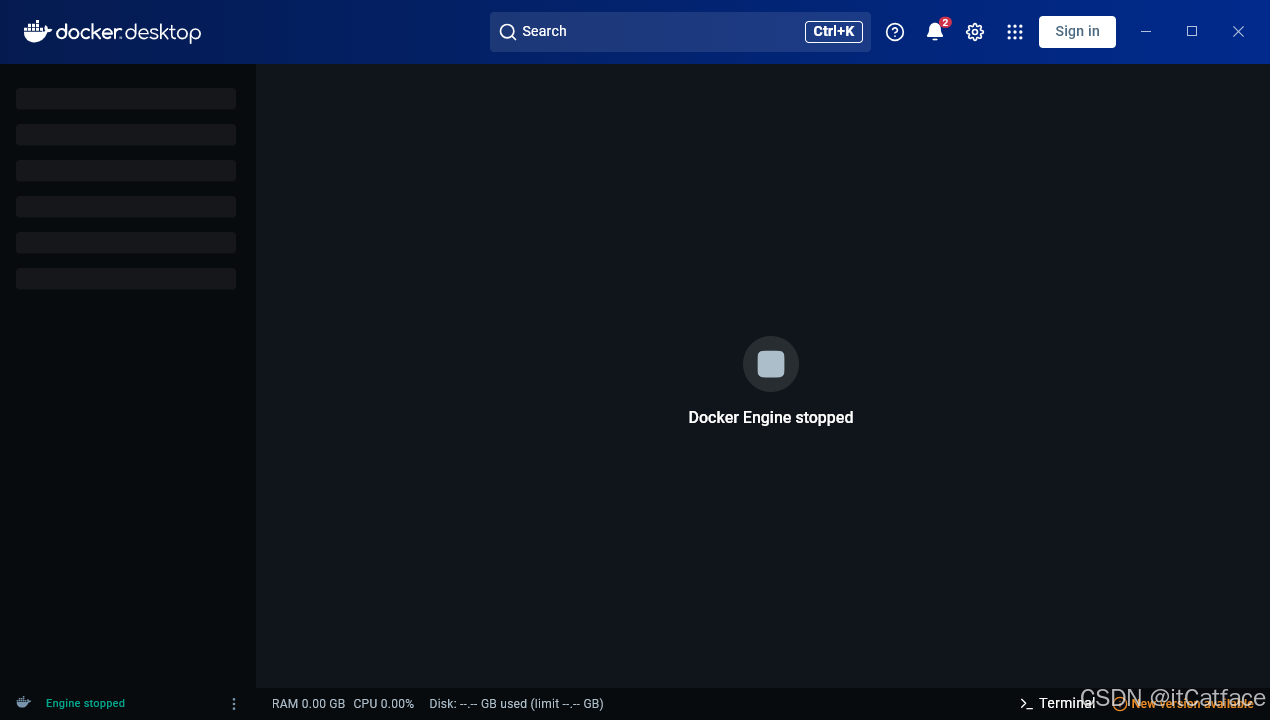

一、Docker安装

-

开启本机虚拟化相关功能

-

官网下载Docker安装程序

-

安装Docker

-

安装完成

-

Docker安装完成后会自动安装WSL

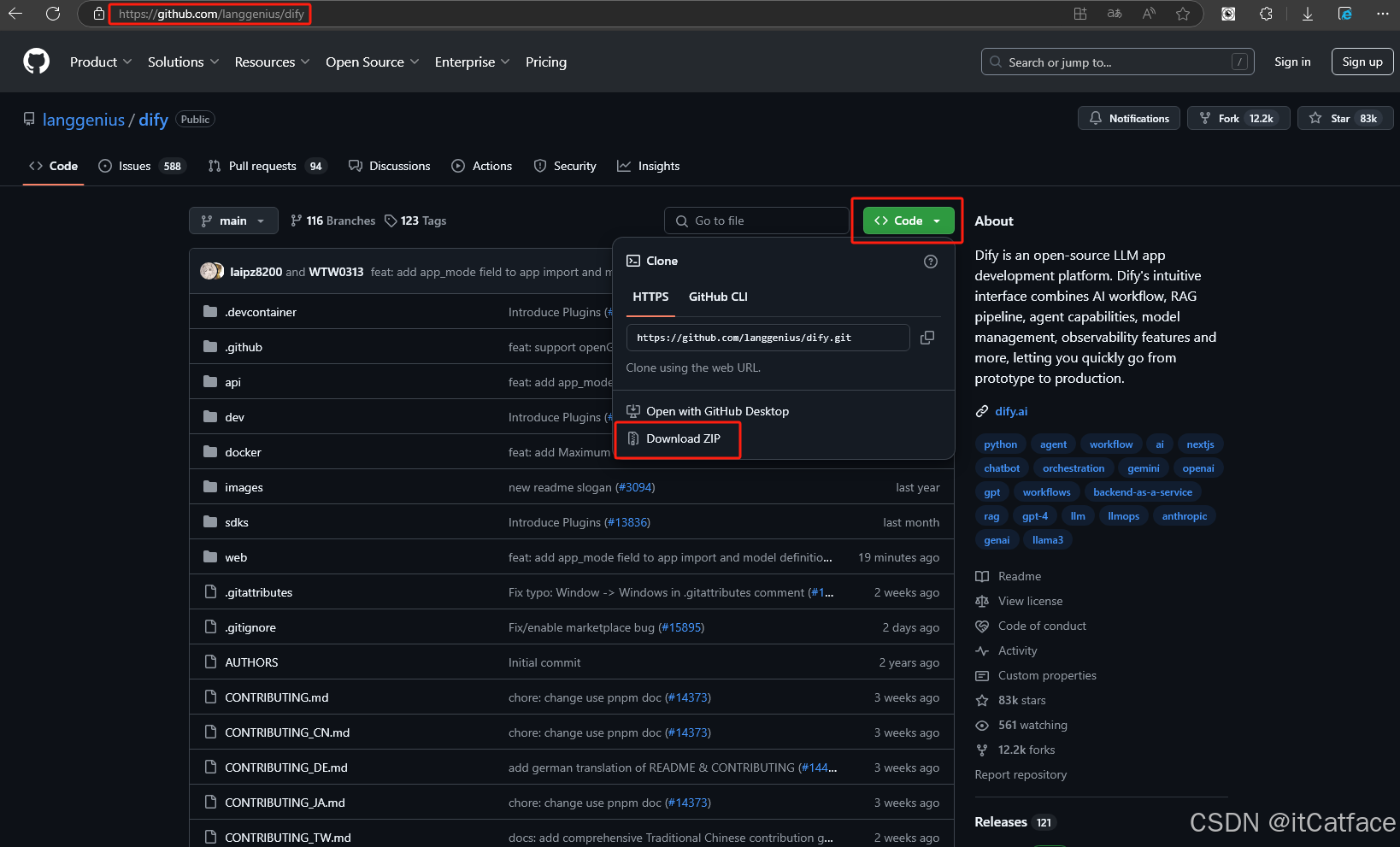

二、Dify源码下载并启动部署

-

Dify源码下载

-

Dify源码解压后,复制文件

.env.example并命名.env

-

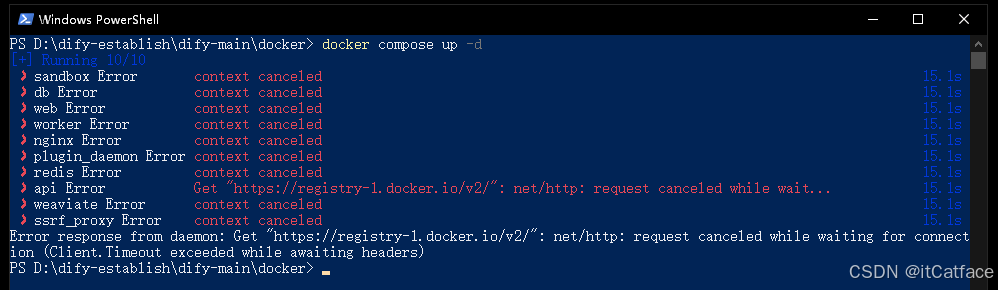

运行

docker compose up -d运行Dify服务

-

上面报错

Error response from daemon: Get "https://registry-1.docker.io/v2/": net/http: request canceled while waiting for connection (Client.Timeout exceeded while awaiting headers)是因为docker镜像无法下载,需要换镜像源地址#更新一版2025.12.20可用 { "builder": { "gc": { "defaultKeepStorage": "20GB", "enabled": true } }, "experimental": false, "registry-mirrors": [ "https://2a6bf1988cb6428c877f723ec7530dbc.mirror.swr.myhuaweicloud.com", "https://docker.m.daocloud.io", "https://hub-mirror.c.163.com", "https://mirror.baidubce.com", "https://your_preferred_mirror", "https://dockerhub.icu", "https://docker.registry.cyou", "https://docker-cf.registry.cyou", "https://dockercf.jsdelivr.fyi", "https://docker.jsdelivr.fyi", "https://dockertest.jsdelivr.fyi", "https://mirror.aliyuncs.com", "https://dockerproxy.com", "https://mirror.baidubce.com", "https://docker.m.daocloud.io", "https://docker.nju.edu.cn", "https://docker.mirrors.sjtug.sjtu.edu.cn", "https://docker.mirrors.ustc.edu.cn", "https://mirror.iscas.ac.cn", "https://docker.rainbond.cc" ] } #以下失效 { "builder": { "gc": { "defaultKeepStorage": "20GB", "enabled": true } }, "experimental": false, "features": { "buildkit": true }, "registry-mirrors": [ "https://docker.linkedbus.com", "https://docker.xuanyuan.me", "https://docker.m.daocloud.io/", "https://huecker.io/", "https://dockerhub.timeweb.cloud", "https://noohub.ru/", "https://dockerproxy.com", "https://docker.mirrors.ustc.edu.cn", "https://docker.nju.edu.cn", "https://xx4bwyg2.mirror.aliyuncs.com", "http://f1361db2.m.daocloud.io", "https://registry.docker-cn.com", "http://hub-mirror.c.163.com" ] }

-

再次运行

docker compose up -d启动Dify,可以看到相关镜像成功拉取,创建的容器均已正常启动

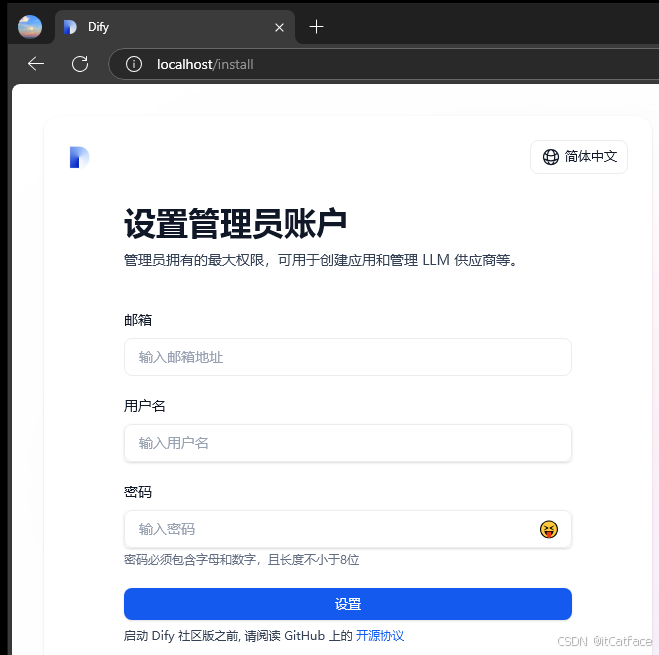

三、设置Dify管理员账号,修改端口

- Dify部署成功后,访问

localhost/install设置管理员账户,默认端口是80

- 修改端口

- 如果初次访问卡在loading页,服务报502,参考官方文档改配置

打开git bash输入命令docker ps -q | xargs -n 1 docker inspect --format '{{ .Name }}: {{range .NetworkSettings.Networks}}{{.IPAddress}}{{end}}'

修改配置

改完配置如下

- 改完配置后重新部署

docker compose up -d,成功进入首页

四、安装ollama,deepseek r1和bge-m3模型

1、安装ollama

- 下载并安装

- 输入命令

ollama list检查是否安装完成

2、安装deepseek r1模型(大语言模型)

- 官网搜索模型,这里选最小的1.5b版本

- 输入命令

ollama run deepseek-r1:1.5b安装

- 安装完成并进行对话测试

3、安装bge-m3模型(知识库搜索增强)

- 官网搜索模型

- 输入命令

ollama pull bge-m3安装

- 输入命令

ollama list检查模型是否安装完成

五、Dify配置ollama、deepseek r1

-

进入Dify设置

-

安装ollama插件

-

修改

.env文件在末尾追加两行CUSTOM_MODEL_ENABLED=true OLLAMA_API_BASE_URl=host.docker.internal:11434

-

ollama添加模型deepseek r1:1.5b

-

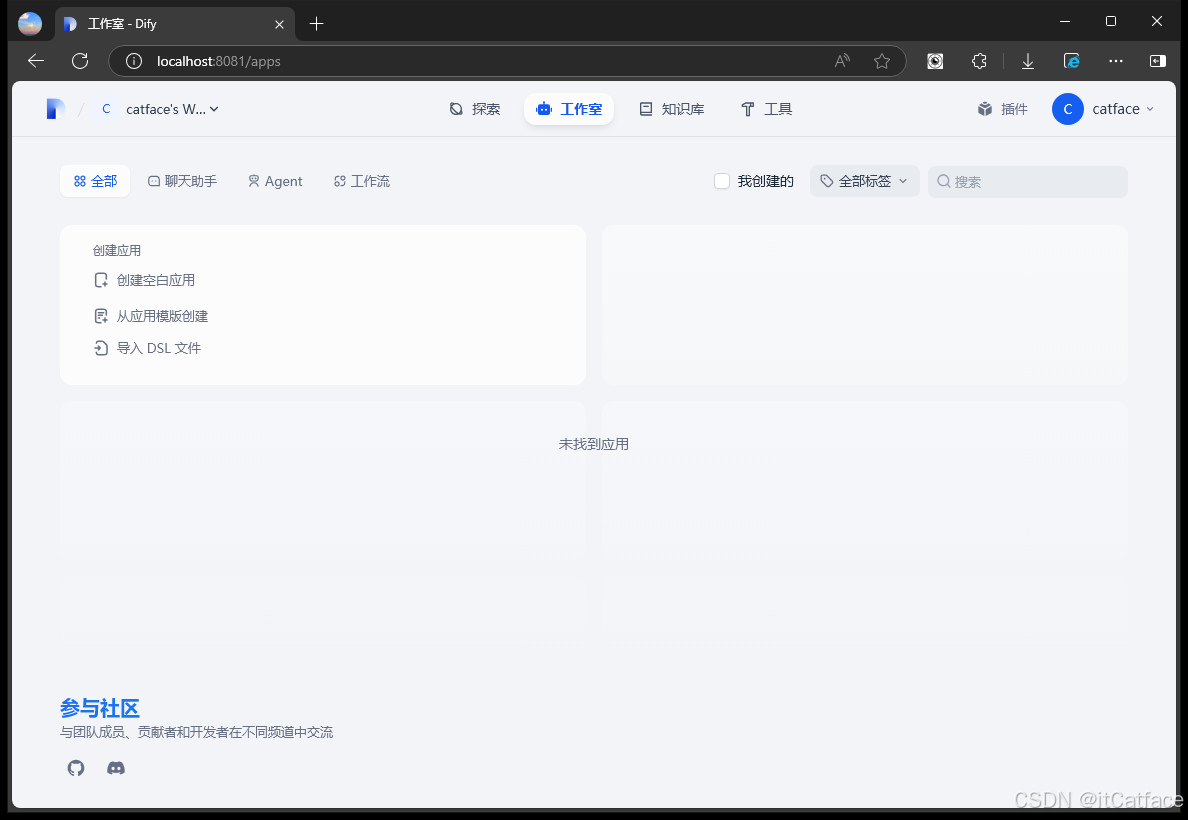

Dify中创建应用

-

创建后进行聊天测试

至此,本地部署Dify并接入deepseek模型已完成,最后补充知识库创建过程

六、Dify知识库创建

-

准备知识库文件,如下示例

-

Dify中创建知识库

-

引用知识库,并进行聊天测试

可以看到效果很差,可以引入Embedding模型bge-m3,支持向量检索,提升知识库内容检索的精确性 -

Dify设置中添加模型bge-m3

-

创建知识库时选择高质量模式

-

最后看聊天效果,对知识库内容的检索精确了很多

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)