基于Dify与DeepSeek构建Agent智能体(Windows+Linux环境)

1. Windows系统

1.1 Ollama 安装

首先,需要安装 Ollama 软件,这是一款专注于在本地环境中部署与运行大型语言模型(LLM, Large Language Model)的工具。在之前的文章中已详细介绍了其安装步骤,此处不再赘述,读者可参考相关文档以获取具体操作流程。

1.1.1 修改模型文件的保存路径

在使用 Ollama 部署开源大语言模型(LLM)之前,建议对模型文件的默认存储路径进行自定义配置。由于单个模型文件通常占用 3~4 GB 的磁盘空间,随着模型数量的增加,系统盘(如 C 盘)可能会面临存储压力。为优化磁盘空间利用率,可通过配置环境变量来更改模型文件的默认存储位置。具体操作为:在操作系统环境变量中新增一个名为 OLLAMA_MODELS 的变量,并将其值设置为自定义的目标存储路径,从而完成路径迁移。

1.1.2 模型的选择和运行

ollama 安装之后,可以通过在命令窗⼝使⽤ollama命令来进⾏交互。

ollama list:显示模型列表ollama show:显示模型的信息ollama pull:拉取模型ollama push:推送模型ollama cp:拷贝⼀个模型ollama rm:删除⼀个模型ollama run::运行⼀个模型

如果需要运行⼀个开源模型,只需要执⾏**ollama run**命令,然后后⾯跟开源模型的名称即可。

官⽅提供了⼀个模型仓库,https://ollama.com/library ,在这⾥你可以找到你想要运行的模型。

llama -> meta公司的开源模型、gemma-> google公司的开源模型、qwen-> 阿⾥巴巴的开源

模型、phi->微软开源、nemotron-mini-> 英伟达开源。

这里直接用qwen,阿⾥巴巴的开源模型下载即可。

ollama run deepseek-r1

这里的 B 表示 Billion(十亿),即模型参数规模为 140 亿(14B)。模型的参数规模越大,对计算机硬件配置的要求也越高。比如8b,至少需要8GB的内存,如果是70b,就需要24G显存+64GB内存。当然,参数规模越⼤,那么⼤模型的推理能⼒就会越强,也就是我们会感受到他更加智能。

1.2 安装Docker-Desktop

打开下面的网址,选择当前操作系统平台,下载对应的版本。⼀般我们下载的是 Windos-AMD64

https://www.docker.com/products/docker-desktop/

下载好以后, 双击执行exe⽂件,弹出如下界⾯, 默认两个都是勾选,不需要管!

点击“ok”以后,进入到安装的环节,耐心等待⼀下

安装完成以后,会提示需要重启,直接重启即可!

1.2.1 Wsl 更新

重启以后,会自动弹出 Wsl 更新,我们直接回车更新就好,如果没有也没关系,这个看你系统本⾝。

WSL 的目标是在 Windows 环境中提供原生的 Linux 兼容性,让开发者能够在 Windows 系统

上进⾏ Linux 开发,无需创建虚拟机或者双重引导系统。

进入到下面页面点击Finish

会弹出如下窗⼝,我们可以不需要注册直接跳过(多次)!

直到出现如何界面docker安装完毕

1.2.2 可能存在的问题

图形化界面上启动docker,报错(当前计算机配置不支持 WSL2),如下:

问题 1:

说明前面 wsl 的更新有问题,我们需要重新安装。

Linux 是⼀种开源的操作系统,它拥有强⼤的功能和稳定的性能,⼴受开发者和用户的喜爱。但是,如果我们的电脑是 Windows 系统,要使⽤ Linux 系统,我们通常需要安装虚拟机,这样会占⽤很多的资源和空间,而且也不够⽅便。其实,对于大多数用户来说,只需要开启 Windows 系统自带的 Linux 子系统,就可以在 Windows 系统上运行 Linux 命令和程序,享受 Linux 的优势,而不影响Windows 的功能 。

要开启 Linux 子系统,首先需要开启 Windows Subsystem for Linux(简称 WSL),顾名思义,WSL 是⼀个在 Windows 10\11 上能够运行原生 Linux 二进制可执行文件(ELF 格式)的兼容层。

开启和安装 Linux 的流程如下,进⼊ cmd 命令下,输⼊

wsl.exe --list --online

看⼀下适合当前系统的 linux 环境有哪些,如果得到如下反馈,说明有问题。

1、适⽤于 Linux 的 Windows ⼦系统没有已安装的分发。

2、可通过安装包含以下说明的分发来解决此问题:

使⽤“wsl.exe --list --online' ”列出可⽤的分发和 “wsl.exe --install <Distro>” 进⾏安装。

如果你也遇到了这个问题,可以按照下⾯的⽹络设置,修改备选 DNS 和首选 DNS 服务器。

在执行wsl.exe --list --online就可以看到如下结果:

于是,我们再执行下面命令,选择 ubuntu 进行安装。比较慢,等一会

wsl.exe --install ubuntu-24.04

问题 2

在安装前,有可能会出现如下错误。

我们按照问题提示,执行

wsl.exe --install --no-distribution

发现还是不行,于是按照下面的步骤安装 Hyper-V

-

服务器管理器 --> 添加角⾊和功能

-

点击“下一步”

-

选择“基于角色或基于功能的安装”,点击“下一步”

-

选择“从服务器池中选择服务器”,点击“下⼀步”

-

勾选“Hyper-V”,弹出功能对话框

-

功能对话框默认即可,点击“添加功能”

-

看到选中 的Hyper-V,点击“下⼀步”

-

功能默认即可,点击“下⼀步”

-

点击“下⼀步”

-

虚拟交换机,勾选网卡(看你有几张),点击“下—步”

-

Hyper-V 实时迁移功能,单台 Hyper-V 的时候默认即可,点击“下—步”

-

虚拟机配置和虚拟机磁盘文件存储位置,选择到自己存储的位置,点击“下—步”

-

确认安装,勾选“如果需要,⾃动重新启动⽬标服务器”,点击“安装”(Hyper-V 安装完需要重启)

-

重启完,通过“Windows 管理⼯具”,打开“Hyper-V 管理器”。

问题 3

请启用“虚拟机平台”可选组件,并确保在 BIOS 中启用虚拟化。

要打开 Hyper-V,你需要按照以下步骤操作:

-

确保你的处理器⽀持虚拟化技术(如 intel 的 VT-x 或 AMD 的 AMD-V),并且虚拟化功能在BIOS 中已经被启⽤。

-

确保当前没有其他虚拟机监控程序在运⾏,例如 VMware 或 VirtualBox。如果有,你需要先关闭这些程序,然后再尝试启⽤ Hyper-V。

-

以管理员权限运⾏命令提示符或 **powerShell。**你可以在开始菜单搜索“命令提示符”,右键点击选择“以管理员身份运⾏”或“PowerShell”,选择相同选项。

-

在命令提示符或 PowerShell 中,输⼊以下命令来启用Hyper-V 功能:

DISM /Online /Enable-Feature /All /FeatureName:[microsoft](https://wenk u.csdn.net/doc/64534a7bea0840391e779379?spm=1055.2569.3001.10083&kw d=microsoft)-Hyper-V或者:

Enable-WindowsOptionalFeature -Online -FeatureName Microsoft-Hyper-V -All然后按照提示重启计算机。

-

重启后,你可以在控制面板的“程序和功能”中查看“Windows 功能”列表,确认 Hyper-V 是否已经成功启⽤。

1.3 安装及配置 Dify

下载Dify源码:https://github.com/langgenius/dify/releases

下载最新的版本, 有⼀个 Assets 的菜单,有两个文件,⼀个是用 zip 压缩的⽂件,另⼀个是 tag.gz 压缩的文件。在 Window 环境下,我们下载 zip 结尾的⽂件就行。

1.3.1 Docker Compose 部署

前提条件:

安装 Dify 之前 , 请确保你的机器已满足最低安装要求:

CPU >= 2 Core

RAM >= 4 GiB

启动 Dify

- 进⼊ Dify 源代码的 Docker ⽬录

cd dify/docker - 复制环境配置文件

cp .env.example .env - 启动 Docker 容器

根据你系统上的 Docker Compose 版本,选择合适的命令来启动容器。你可以通过$ docker compose version命令检查版本,详细说明请参考Docker 官⽅⽂档

如果版本是 Docker Compose V2,使⽤以下命令:

如果版本是 Docker Compose V1,使⽤以下命令:docker compose up -ddocker-compose up -d

运行命令后,你应该会看到类似以下的输出,显示所有容器的状态和端⼝映射:

最后检查是否所有容器都正常运行:

docker compose ps

在这个输出中,你应该可以看到包括 3 个业务服务api / worker / web,以及 6 个基础组

件weaviate / db / redis / nginx / ssrf_proxy / sandbox

通过这些步骤,你应该可以成功在本地安装 Dify。

访问 Dify

你可以先前往管理员初始化页面设置管理员账户:

# 本地环境

http://localhost/install

# 服务器环境

http://your_server_ip/install

Dify 主页⾯:

# 本地环境

http://localhost

# 服务器环境

http://your_server_ip

更新 Dify

进⼊dify源代码的docker目录,按顺序执⾏以下命令:

1 cd dify/docker

2 docker compose down

3 git pull origin main

4 docker compose pull

5 docker compose up -d

- 如果

.env.example⽂件有更新,请务必同步修改你本地的.env⽂件。 - 检查

.env⽂件中的所有配置项,确保它们与你的实际运⾏环境相匹配。你可能需要将.env.example中的新变量添加到.env⽂件中,并更新已更改的任何值。

1.4 Dify关联DeepSeek

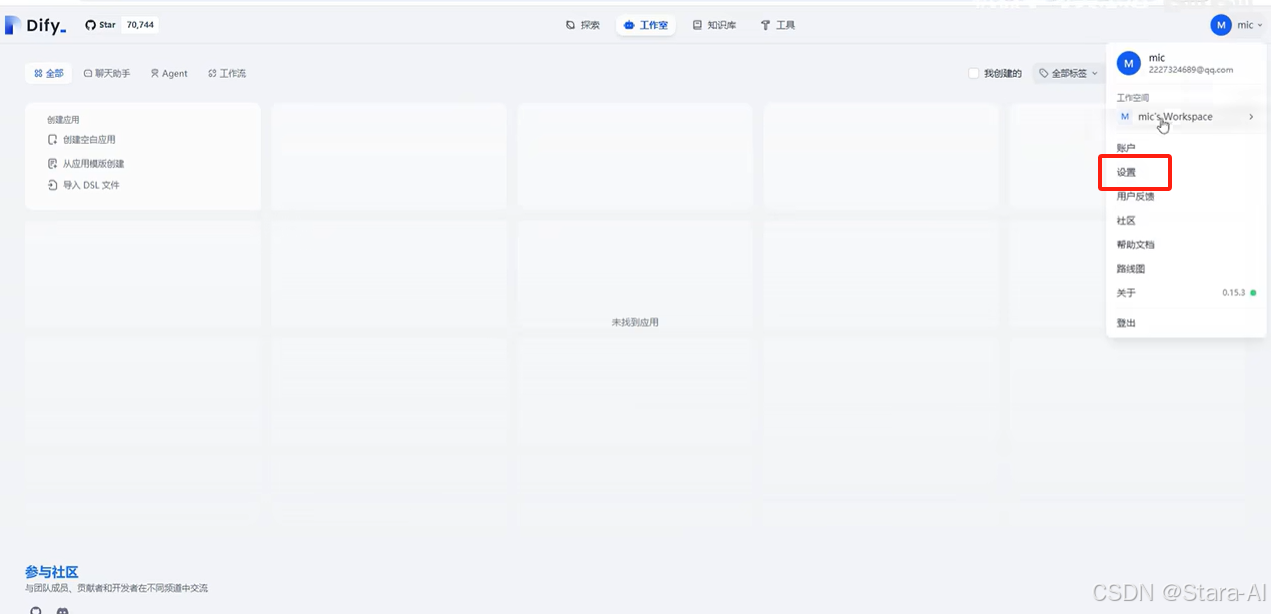

点击设置,找到模型供应商,里面提供了很多模型的对接,选择Ollama进行配置

点击"保存"

1.5 创建 Agent

对智能体功能进行编排

2. Linux系统(Ubuntu)

2.1 安装Ollama

curl -fsSL https://ollama.com/install.sh | sh

如果 curl 命令⽆法识别,可以⽤下⾯命令安装

apt install curl -y

注意: 如果之前已经安装了旧版本的 ollama,那么需要先完成手动卸载,sudo rm -rf/usr/lib/ollama

# 创建目录

mkdir -p /data/program

如果上面的命令执⾏下载较慢,可以直接在**ollama github**仓库上下载对应的版本:https://github.com/ollama/ollama/releases

其中, rocm 结尾的包表示支持 AMD GPU 环境。

下载以后,保存到 /data/program/ 目录下。执行下面命令解压缩即可

tar -C /usr -xzf ollama-linux-amd64.tgz

chmod +x /usr/bin/ollama # 添加可执行权限

添加 Ollama 作为启动服务(推荐) 为 Ollama 创建用户:

sudo useradd -r -s /bin/false -m -d /usr/share/ollama ollama

在以下位置创建服务文件/etc/systemd/system/ollama.service :

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

[Install]

WantedBy=default.target

systemctl daemon-reload # 重新加载 systemd 的配置文件。

systemctl enable ollama # ollama 服务设置为开机自启

systemctl start ollama # 启动服务

systemctl status ollama # 查看服务状态

2.2 获取DeepSeek模型

2.3 安装 docker 环境

Ubuntu24.04 系统安装 docker,先更新系统的 apt 源。

apt update

apt upgrade

检查以及卸载老版本 docker,如果没有安装过的话可以不需要执行

apt-get remove docker docker-engine docker.io containerd runc

安装 docker 依赖包

apt-get install ca-certificates curl gnupg lsb-release

添加 Docker 官方 GPG 密钥

curl -fsSL http://mirrors.aliyun.com/docker-ce/linux/ubuntu/gpg | sudo apt-key add -

添加 Docker 软件源

add-apt-repository "deb [arch=amd64] http://mirrors.aliyun.com/docker-ce/linux/ubuntu $(lsb_release -cs) stable"

安装 Docker

apt-get install docker-ce docker-ce-cli containerd.io

2.3.1 配置镜像加速器

https://cr.console.aliyun.com/cn-hangzhou/instances/mirrors打开阿⾥云,注册账号或者用淘宝账号登陆。

针对 Docker 客户端版本大于 1.10.0 的用户,您可以通过修改 daemon 配置⽂件 /etc/docker/daemon.json 来使用加速器

sudo mkdir -p /etc/docker

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": [

"https://089rhvhq.mirror.aliyuncs.com",

"https://ustc-edu-cn.mirror.aliyuncs.com/",

"https://docker.mirrors.ustc.edu.cn",

"https://docker.nju.edu.cn",

"https://ccr.ccs.tencentyun.com/",

"https://docker.m.daocloud.io/",

"https://dockerproxy.com"

]

}

EOF

按顺序执行下面的指令:

sudo systemctl daemon-reload # 重新加载 systemd 配置

sudo systemctl stop docker # 停止 Docker 服务

sudo systemctl stop docker.socket # 停止 Docker Socket

sudo systemctl restart docker # 重启 Docker 服务

2.4 安装 AnythinLLM

AnythingLLM,可以支持多种环境, 如果是小白的话,⽤ Docker 是最简单的。

AnythingLLM 安装,直接用下面的脚本来即可

# 拉取anythingLLM镜像

docker pull mintplexlabs/anythingllm

# 查看镜像列表

docker images

# 运⾏镜像

docker run -d -p 3001:3001 --name AnythingLLM mintplexlabs/anythingllm

# 停⽌并启动镜像

docker stop AnythingLLM

docker start AnythingLLM

2.5 安装Dify

启动 Dify

进入 Dify 源代码的 Docker 目录(根据自己项目情况)

cd dify-0.15.3/docker

复制环境配置⽂件

cp .env.example .env

启动 Docker 容器

根据你系统上的 Docker Compose 版本,选择合适的命令来启动容器。你可以通过$ docker compose version命令检查版本,详细说明请参考Docker 官方文档:如果版本是 Docker Compose V2,使⽤以下命令:

docker compose up -d

如果版本是 Docker Compose V1,使⽤以下命令:

docker-compose up -d

访问 Dify

你可以先前往管理员初始化页面设置设置管理员账户,然后登录

2.6 Dify关联DeepSeek

注意:这个Ollama Sever基础URL这里,默认访问协议地址是本地地址,这里直接访问是不行的,需要配置一下。

ollama serve -h

2.6.1 Ollama 配置跨网络访问

首先打开 Ollama 的配置文件sudo gedit /etc/systemd/system/ollama.service,在[Service]下面加上:

Environment="OLLAMA_HOST=0.0.0.0:11434"

其次配置防火墙,打开端⼝。Ollama 的默认端⼝是 11434,所以直接输⼊:

sudo ufw allow 11434/tcp

再重启之后,就可以通过 http 在局域网中访问了。

其他模型:比如千问

2.7 创建 Agent

对智能体功能进行编排

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)