在IntelliJ IDEA中使用本地deepseek模型实现AI辅助编程

·

引言

大部分情况下,往往无法在公司内网使用AI编程插件,在本地部署一个简单大模型,并通过idea插件使用本地大模型进行AI辅助编程是一个不错的选择。如果公司部署了其他大模型,直接使用公司的API是更好的选择

前置条件

- 已安装IntelliJ IDEA(2020.3或更高版本)

- 已安装Ollama并下载运行

deepseek-r1模型,不知道如何安装可以查看通过ollama在本地部署deepseek-r1模型并开始使用

一、安装Continue插件

- 打开IntelliJ IDEA,进入插件市场:

- Windows/Linux:

Ctrl+Alt+S→ 选择 Plugins - macOS:

Command+,→ 选择 Plugins

- Windows/Linux:

- 在搜索栏输入 Continue,找到紫色火箭图标插件

- 点击 Install 安装,完成后重启IDEA

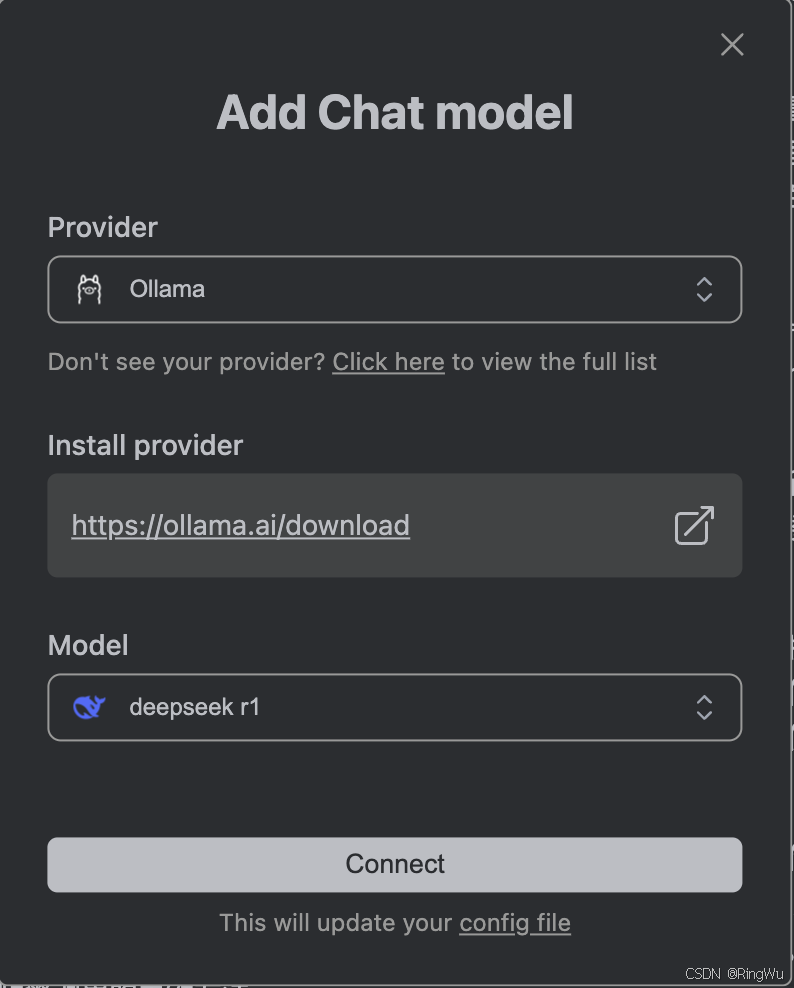

二、配置Continue插件连接模型

-

在IDEA右边栏打开continue插件,并点击add chat model:

-

在下拉列表中选择ollama,在model中选择deepseek r1:

-

点击配置好的chat model旁边的设置按钮打开config.json:

-

修改配置文件

config.json,把“model”改成和本地大模型一样的名称(一字不差,否则无法调用):

-

保存配置文件,返回编辑器界面

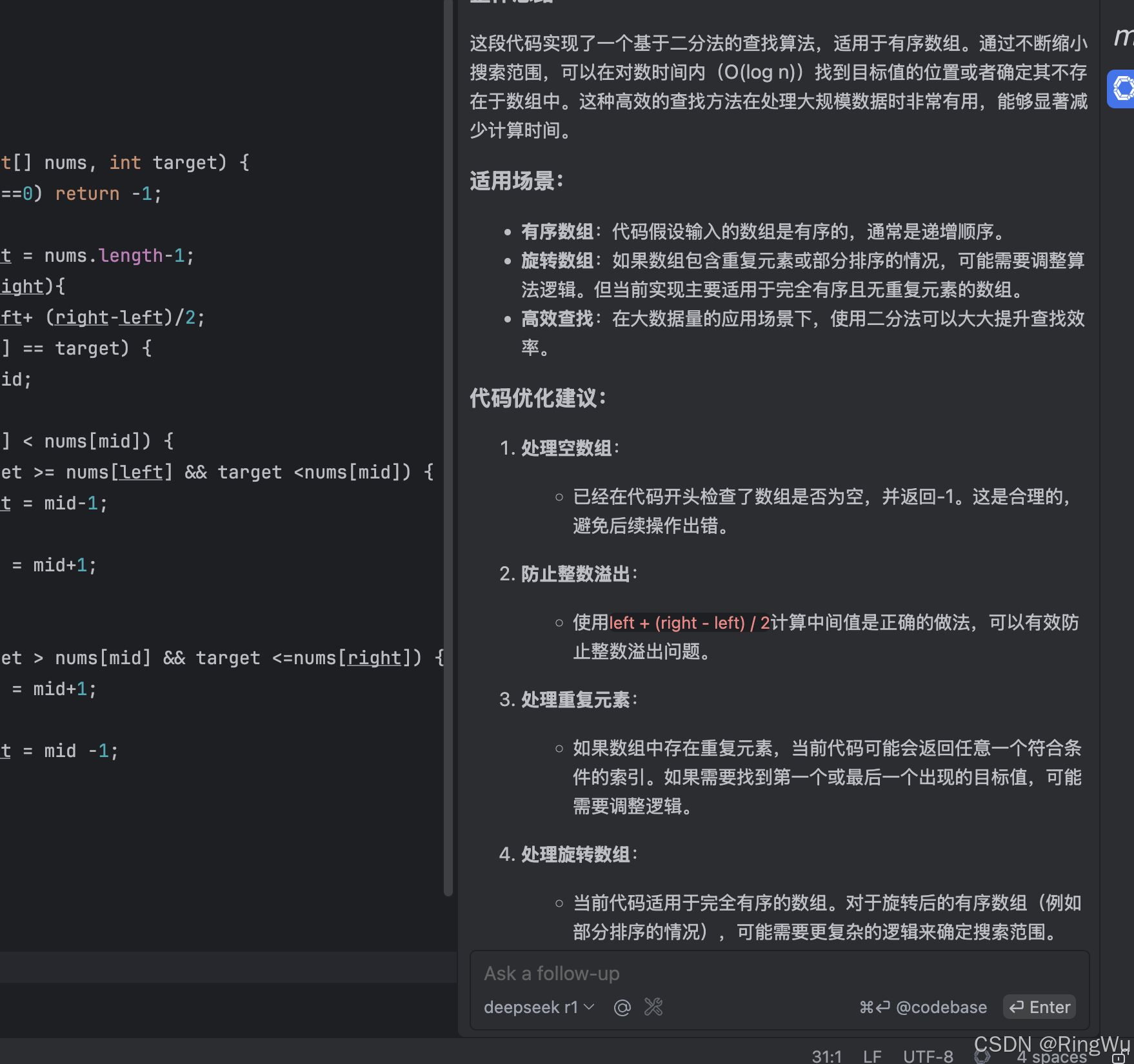

四、验证连接

- 新建/打开任意代码文件(建议Java/Python等常见语言)

- 选中代码片段 → 右键选择 Ask Continue,或根据提示使用快捷键

五、基本使用方法

- 代码问答:选中代码后右键调用插件

- 快捷对话:

Ctrl+Shift+L打开对话窗口 - 功能示例:

- 代码解释

- 错误修复建议

- 代码片段生成

常见问题排查

| 问题现象 | 解决方案 |

|---|---|

| 插件无响应 | 1. 检查Ollama终端是否运行 2. 执行 curl http://localhost:11434 验证服务 |

| 模型加载失败 | 执行 ollama pull deepseek-r1:14b 重新拉取模型 |

| 内存不足报错 | 关闭其他占用内存的程序,或升级硬件配置 |

| 端口冲突 | 修改Ollama启动参数:OLLAMA_HOST=0.0.0.0:11435 |

注意事项

- 首次使用建议准备10GB以上磁盘空间

- 建议在代码文件较小的场景下使用(大文件处理可能较慢)

- 复杂问题建议拆分成多个小问题提问

通过以上步骤即可在IDEA中实现本地大模型辅助开发。如果遇到技术问题,建议查看Ollama官方文档或Continue插件GitHub仓库获取最新支持。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)