混合专家模型:DeepSeek的中流砥柱,具身智能的他山之石

MoE是DeepSeek劈开算力壁垒的盘古巨斧,会成为具身领域的他山之石吗?

MoE:具身智能大模型的新引擎

DeepSeek的快速崛起,让混合专家模型(Mixture of Experts, MoE) 架构再次进入大家的视野。特别是在具身智能大模型领域,MoE的应用为智能体与环境的交互带来了更高的效率和灵活性。最新由智元机器人推出的 ViLLA,即视觉-语言-潜动作模型,正是MoE技术在这一领域的杰出代表。本文将深入探讨混合专家模型的基本原理,并结合ViLLA模型,揭示其在具身智能大模型中的应用优势。

什么是混合专家模型?

混合专家模型是一种将多个专家模型组合在一起的机器学习架构。它的核心思想是通过分工合作来处理复杂的输入数据:每个专家模型专注于特定的任务或数据类型,而一个 门控网络(gating network 则负责根据输入的特性,动态决定由哪个专家来处理。这种设计有点像一个高效的团队:每个成员有自己的专长,而管理者根据任务需求分配工作。

MoE的基本原理

MoE的核心在于 “分而治之”。在传统神经网络中,整个模型需要一次性处理所有输入数据,这在面对大规模或多样化的数据时往往效率不高。而MoE通过任务分解,让每个专家只处理自己擅长的部分,从而提升整体性能。

具体来说,MoE的工作流程可以分为以下步骤:

- 输入数据:模型接收外部输入,例如图像、文本或传感器数据。

- 门控网络:分析输入特性,为每个专家分配一个权重,决定其参与程度。

- 专家模型:根据门控网络的分配,各专家处理输入并生成各自的输出。

- 输出聚合:将所有专家的输出按权重加和,得到最终结果。

这种架构的优势显而易见:

- 高效性:只有部分专家参与计算,避免了资源浪费。

- 模块化:专家可以独立训练和优化,便于模型扩展。

- 适应性:能应对多样化任务,提升模型的灵活性。

用一个简单的类比来说,MoE就像一个医院的专科门诊:病人进来后,分诊台(门控网络)根据病情把他们送到内科、外科或儿科(专家模型),而不是让一位全科医生疲于应对所有问题。

技术细节:MoE的数学原理与代码示例

MoE的数学原理

混合专家模型(Mixture of Experts, MoE)的核心思想是通过一个门控网络(gating network)动态分配输入到多个专家模型。假设输入为 x\mathbf{x}x,模型包含 nnn 个专家 f1,f2,…,fnf_1, f_2, \dots, f_nf1,f2,…,fn,门控网络会生成一个 nnn 维权重向量 g(x)=[g1(x),g2(x),…,gn(x)]\mathbf{g}(\mathbf{x}) = [g_1(\mathbf{x}), g_2(\mathbf{x}), \dots, g_n(\mathbf{x})]g(x)=[g1(x),g2(x),…,gn(x)],其中 gi(x)g_i(\mathbf{x})gi(x) 表示第 iii 个专家的权重。

门控网络通常采用 softmax 函数来计算权重,确保所有权重的和为 1:

gi(x)=exp(wi⊤x)∑j=1nexp(wj⊤x) g_i(\mathbf{x}) = \frac{\exp(\mathbf{w}_i^\top \mathbf{x})}{\sum_{j=1}^n \exp(\mathbf{w}_j^\top \mathbf{x})} gi(x)=∑j=1nexp(wj⊤x)exp(wi⊤x)

这里,wi\mathbf{w}_iwi 是门控网络为第 iii 个专家学习的权重向量。最终的输出 yyy 是所有专家输出的加权和:

y=∑i=1ngi(x)⋅fi(x) y = \sum_{i=1}^n g_i(\mathbf{x}) \cdot f_i(\mathbf{x}) y=i=1∑ngi(x)⋅fi(x)

这种机制允许模型根据输入 x\mathbf{x}x 的特性,动态选择最适合的专家进行处理,从而提高效率和性能。

代码示例

以下是一个简化的 MoE 层的实现(使用 PyTorch),展示了门控网络和专家网络如何协同工作:

import torch

import torch.nn as nn

import torch.nn.functional as F

# 定义单个专家网络

class Expert(nn.Module):

def __init__(self, input_dim, hidden_dim):

super(Expert, self).__init__()

self.fc1 = nn.Linear(input_dim, hidden_dim)

self.fc2 = nn.Linear(hidden_dim, input_dim)

def forward(self, x):

return self.fc2(F.relu(self.fc1(x)))

# 定义门控网络

class GatingNetwork(nn.Module):

def __init__(self, input_dim, num_experts):

super(GatingNetwork, self).__init__()

self.fc = nn.Linear(input_dim, num_experts)

def forward(self, x):

return F.softmax(self.fc(x), dim=-1)

# 定义MoE层

class MoELayer(nn.Module):

def __init__(self, input_dim, hidden_dim, num_experts):

super(MoELayer, self).__init__()

self.experts = nn.ModuleList([Expert(input_dim, hidden_dim) for _ in range(num_experts)])

self.gating = GatingNetwork(input_dim, num_experts)

def forward(self, x):

# 计算门控权重 [batch_size, num_experts]

gating_weights = self.gating(x)

# 计算所有专家的输出 [num_experts, batch_size, input_dim]

expert_outputs = torch.stack([expert(x) for expert in self.experts], dim=0)

# 加权求和 [batch_size, input_dim]

output = torch.einsum('bn,nbd->bd', gating_weights, expert_outputs)

return output

# 示例用法

input_dim, hidden_dim, num_experts = 64, 128, 4

moe_layer = MoELayer(input_dim, hidden_dim, num_experts)

x = torch.randn(32, input_dim) # 假设batch_size=32

output = moe_layer(x)

print(output.shape) # 输出: torch.Size([32, 64])

在这个代码中:

Expert是一个简单的两层前馈神经网络(FFN),代表单个专家。GatingNetwork使用线性层和 softmax 函数为每个专家分配权重。MoELayer将专家输出与门控权重结合,生成最终结果。

MoE的优势

通过数学表示和代码示例,我们可以看到 MoE 的几个关键优势:

- 稀疏性:门控网络只激活部分专家,减少了计算开销。

- 并行性:多个专家可以并行处理,提升训练和推理效率。

- 灵活性:通过增加专家数量,可以轻松扩展模型容量。

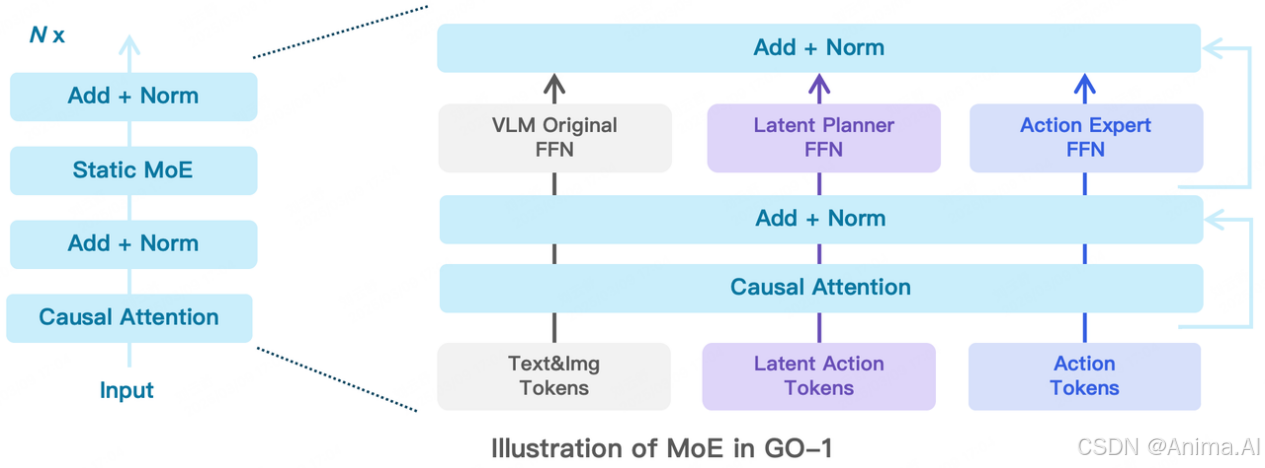

ViLLA模型:MoE在具身智能中的实践

ViLLA(Visual-Language Large Model with Mixture of Experts)是由智元机器人推出的一款具身智能大模型,专为处理视觉和语言任务设计。它在训练和推理阶段都采用了MoE技术,展现了高效性和灵活性的完美结合。

ViLLA模型的特点

- 多模态能力:ViLLA能够同时处理视觉和语言数据,适用于需要理解图像并生成文本的任务。

- MoE架构:在编码器和解码器中引入MoE层,每个MoE层包含多个专家和一个门控网络。

- 高效训练:MoE的并行处理能力显著加快了ViLLA的训练速度。

- 灵活推理:推理时,ViLLA可根据任务动态选择专家,优化资源使用。

ViLLA的应用场景

ViLLA在具身智能领域展现了广泛的潜力,例如:

- 机器人导航:通过视觉输入和语言指令,引导机器人在复杂环境中移动。

- 智能交互:实现人与机器之间的自然对话和视觉信息交流。

- 任务规划:根据环境感知,规划并执行复杂的动作序列。

例如,想象一个家用机器人:你对它说“把客厅的蓝色杯子拿到厨房”,ViLLA就能通过视觉识别杯子位置,理解语言指令,并规划移动路径——这一切都得益于MoE的高效分工。

MoE在具身智能大模型中的优势

具身智能是指智能体通过与环境交互来学习和执行任务的能力,比如机器人操作物体或无人车导航。这种场景要求模型处理多模态数据(视觉、声音、触觉等)并做出实时决策,而MoE恰好为这些需求提供了理想解决方案。

-

高效处理多模态数据

- 具身智能任务涉及多种数据类型,MoE可以将不同模态或任务分配给专门的专家。例如,一个专家处理图像,另一个处理语言,从而提高效率。

-

动态资源分配

- 环境和任务的复杂性可能随时变化。MoE的门控网络能根据输入动态调整专家的参与度,确保资源集中在最需要的部分。

-

提升泛化能力

- 通过专家分工,MoE能捕捉更细致的特征,即使面对未见过的新环境,也能保持较强的适应性。

-

加速训练与推理

- MoE的并行性让训练更快收敛,推理更迅速,这对实时性要求高的具身智能任务至关重要。

举个例子,在自动驾驶中,MoE可以将路标识别交给一个专家,障碍物检测交给另一个专家,而门控网络则根据天气、光线等条件动态调整分工。这种灵活性让模型既高效又鲁棒。

虽然MoE具有提升模型性能的潜力,但也可能会面临一系列挑战。

MoE在具身智能领域的发展瓶颈和潜在问题

1. 实时性与计算延迟

具身智能任务,例如机器人导航或自动驾驶,通常要求系统能够在毫秒级别内做出决策。然而,MoE架构依赖门控网络动态选择专家并执行多个模型的计算,这一过程可能显著增加推理时间。特别是在资源受限的边缘设备上,计算延迟可能导致智能体无法及时响应环境变化,从而影响任务执行的效率和安全性。

2. 资源分配与硬件限制

MoE架构需要在多个专家模型之间分配计算资源,而具身智能应用中的硬件平台(如嵌入式芯片或移动设备)往往计算能力有限。如何在资源受限的情况下优化专家模型的并行计算,确保实时性和性能,成为一大难题。此外,不均衡的资源分配可能导致部分专家性能不足,进一步影响整体系统表现。

3. 专家选择的不确定性

MoE中的门控网络负责根据输入选择最合适的专家,但在具身智能的复杂动态环境中(如未知地形或突发事件),门控网络可能无法准确判断,导致选择次优甚至错误的专家。这种不确定性可能降低模型的鲁棒性,例如在机器人抓取任务中错误识别物体材质,进而影响操作成功率。

4. 训练稳定性与数据需求

MoE架构的训练需要协调多个专家和门控网络,过程复杂且容易出现不稳定性。具身智能任务通常涉及高维数据和多样化的场景,而数据采集成本高、标注难度大,训练数据可能不足以支撑所有专家的有效学习。这可能导致模型过拟合或训练收敛困难,限制其实际应用效果。

5. 泛化能力与环境适应性

具身智能要求模型能够适应多变的环境,如光照变化、天气条件或物体位置的随机性。MoE架构中的专家模型往往针对特定子任务或数据分布进行优化,若训练数据无法覆盖所有场景,模型在新环境中的泛化能力可能受限。例如,一个在室内训练的MoE模型可能无法适应室外的光照条件。

6. 多模态数据的融合

具身智能通常需要处理多模态输入(如图像、声音、触觉信号),而MoE架构需要为不同模态设计专门的专家并通过门控网络融合结果。然而,各模态数据在特征空间和时间尺度上的差异可能导致专家之间的协调困难。例如,视觉专家可能快速识别物体,而触觉专家反应较慢,这种异步性可能影响最终决策的准确性。

7. 可解释性与安全性

MoE架构的决策过程较为复杂,门控网络的选择逻辑和专家的输出难以直观解释。在具身智能的安全关键应用中(如医疗机器人或无人驾驶),缺乏可解释性可能引发信任问题。若模型因专家选择失误而导致事故,难以追溯具体原因,这对其在高风险场景中的部署构成障碍。

综上所述,尽管MoE架构在具身智能领域展现出强大的潜力,但其在实时性、资源分配、训练稳定性等方面的挑战仍需进一步研究和优化。通过改进门控机制、设计高效的专家模型以及提升多模态融合能力,MoE有望在未来更好地服务于具身智能任务。

结语

混合专家模型以其独特的分工合作机制,正在为具身智能大模型注入新的活力。它不仅提升了模型处理复杂任务的效率和灵活性,还为多模态数据的融合提供了新思路。ViLLA模型的成功实践证明,MoE技术在具身智能领域的潜力远未被完全挖掘。随着人工智能的不断进步,MoE有望成为推动智能体与现实世界交互的关键引擎,为我们带来更智能、更高效的未来。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)