DIY deepseek教程

使用 TensorFlow Lite 或 PyTorch Mobile 将模型集成到移动应用中。:可以使用 Hugging Face 的 Transformer 模型(如 GPT、BERT)。:将模型部署到云平台(如 AWS、Google Cloud、Azure)。:可以使用 OpenCV 或预训练的 ResNet、YOLO 模型。:使用 Flask 或 FastAPI 搭建一个本地API服务。:

1. 明确目标和需求

在开始之前,先明确你想要实现的AI功能。例如:

-

智能对话助手

-

数据分析与预测工具

-

图像识别系统

-

个性化推荐引擎

明确目标后,你可以更好地选择合适的技术栈和工具。

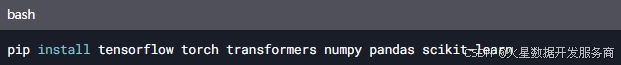

2. 准备开发环境

为了DIY DeepSeek,你需要搭建一个适合AI开发的编程环境:

-

编程语言:Python 是AI开发的主流语言。

-

开发工具:安装 Anaconda 或直接使用 Python 的包管理工具

pip。 -

深度学习框架:选择 TensorFlow、PyTorch 或 Hugging Face 等框架。

-

硬件支持:如果有GPU(如NVIDIA),可以加速模型训练。

安装必要的库:

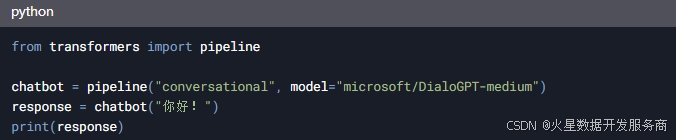

3. 选择合适的AI模型

根据你的需求,选择合适的预训练模型或从头开始训练模型:

-

自然语言处理(NLP):可以使用 Hugging Face 的 Transformer 模型(如 GPT、BERT)。

-

计算机视觉:可以使用 OpenCV 或预训练的 ResNet、YOLO 模型。

-

数据分析:可以使用 Scikit-learn 或 XGBoost 等机器学习库。

例如,使用 Hugging Face 加载一个预训练的对话模型:

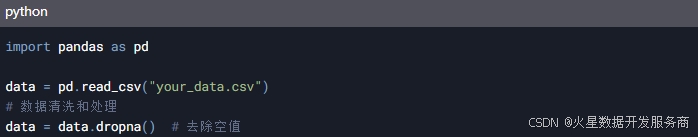

4. 数据收集与处理

AI模型的核心是数据。根据你的需求,收集并处理相关数据:

-

对话助手:收集对话数据(如聊天记录)。

-

图像识别:收集标注好的图像数据集。

-

推荐系统:收集用户行为数据(如点击、购买记录)。

使用工具如 Pandas 进行数据清洗和预处理:

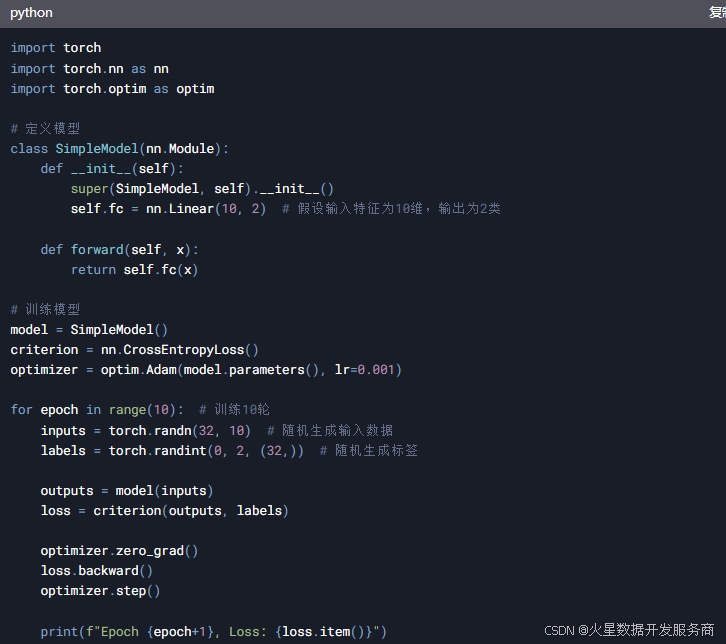

5. 训练模型

如果你需要从头训练模型,可以使用以下步骤:

-

定义模型架构:选择合适的神经网络结构。

-

训练模型:使用你的数据集进行训练。

-

调优参数:调整超参数(如学习率、批次大小)以优化性能。

例如,使用 PyTorch 训练一个简单的分类模型:

6. 部署与应用

训练好模型后,将其部署到实际应用中:

-

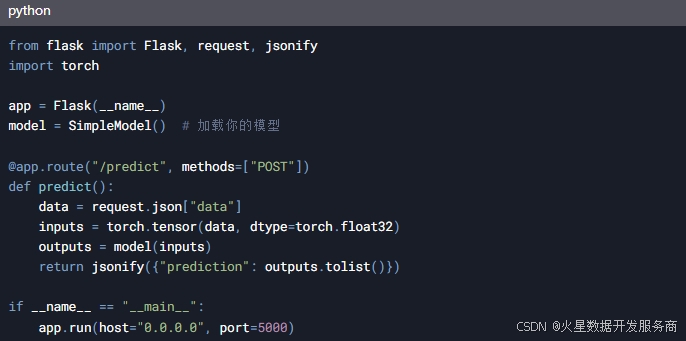

本地部署:使用 Flask 或 FastAPI 搭建一个本地API服务。

-

云部署:将模型部署到云平台(如 AWS、Google Cloud、Azure)。

-

移动端部署:使用 TensorFlow Lite 或 PyTorch Mobile 将模型集成到移动应用中。

例如,使用 Flask 部署一个简单的API:

7. 持续优化与迭代

-

监控性能:定期评估模型的准确性和效率。

-

更新数据:随着业务发展,不断更新训练数据。

-

优化模型:尝试更先进的算法或模型架构。

8. 参考资源

-

Hugging Face:https://huggingface.co/

-

PyTorch 官方教程:https://pytorch.org/tutorials/

-

TensorFlow 官方教程:https://www.tensorflow.org/tutorials

-

Kaggle 数据集:Find Open Datasets and Machine Learning Projects | Kaggle

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)