通过ollama在本地部署deepseek-r1模型并开始使用

·

下载和设置ollama

首先,访问ollama官网根据你的操作系统下载ollama:

- Windows: 下载可执行文件并运行。

- macOS: 下载.zip文件并按照指示安装。

- Linux: 在终端运行

curl -fsSL https://ollama.com/install.sh | sh。

安装完成后,打开终端输入 ollama 验证安装。

下载deepseek-r1:14b模型

接下来,使用以下命令通过ollama下载并运行deepseek-r1:14b模型,ollama官网还有很多其他模型,可以根据本地硬件水平或个人喜好下载对应的模型:

ollama pull deepseek-r1:14b

确保你的硬件能支持这个模型,推荐使用具有至少12-24 GB VRAM的GPU以获得最佳性能。

下载完成后,通过如下命令运行下载好的模型:

ollama run deepseek-r1:14b

然后输入问题,deepseek-r1:14b就可以回答你的问题了,如下所示:

下载和配置deepchat

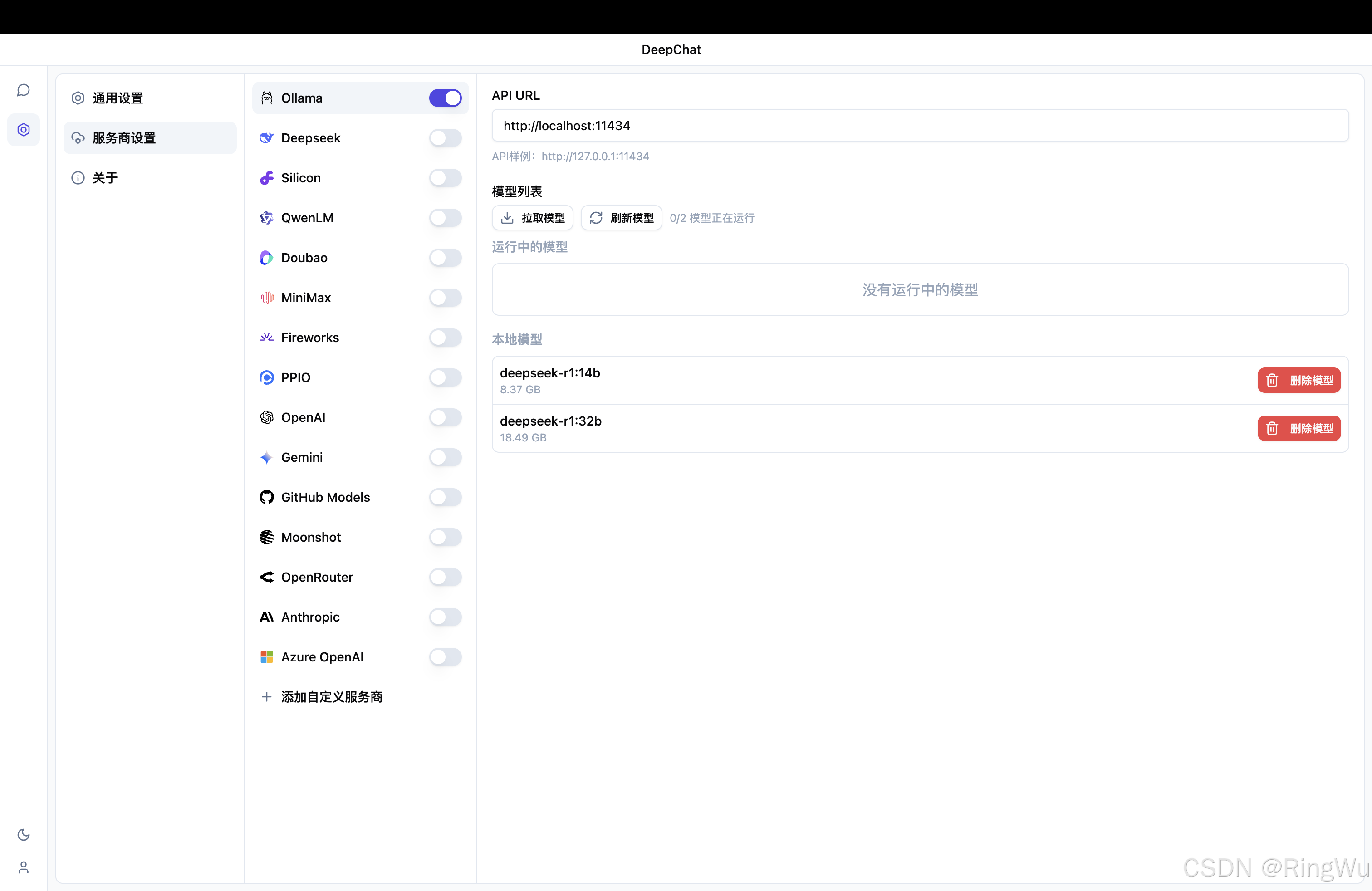

目前已经下载并运行了大模型,但是terminal的交互体验属实不太好。deepchat是一个AI agent,可以调用本地ollama的api和我们进行交互。以下是设置步骤:

- 打开deepchat github仓库:

https://github.com/ThinkInAIXYZ/deepchat - 打开releases:

- 下载对应版本的安装包并安装

- 配置本地ollama的api

- 通过deepchat向大模型提问

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)