阿里推理模型QwQ-32B开源,性能比肩满血R1,它真的这么强吗?

深夜突发,阿里开源了最新的推理模型 QwQ-32B,有3大亮点:能够与当前最先进的推理模型DeepSeek-R1(满血哦,不是蒸馏) 和 o1-mini相媲美推理模型中集成了与 Agent 相关的能力,使其能够在使用工具的同时进行批判性思考,并根据环境反馈调整推理过程。小尺寸,不要671B,只要32B,推理门槛低

深夜突发,阿里开源了最新的推理模型 QwQ-32B,有3大亮点:

-

能够与当前最先进的推理模型DeepSeek-R1(满血哦,不是蒸馏) 和 o1-mini相媲美

-

推理模型中集成了与 Agent 相关的能力,使其能够在使用工具的同时进行批判性思考,并根据环境反馈调整推理过程。

-

小尺寸,不要671B,只要32B,推理门槛低

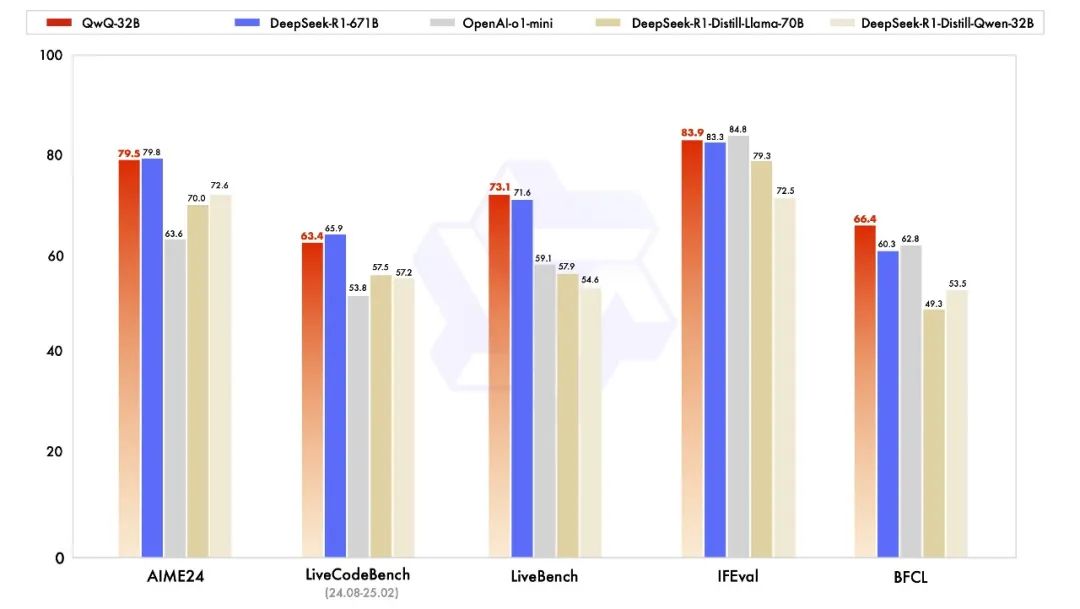

QwQ-32B 与其他领先模型的性能对比,包括 DeepSeek-R1-Distilled-Qwen-32B、DeepSeek-R1-Distilled-Llama-70B、o1-mini 以及原始的 DeepSeek-R1。

QwQ-32B如何炼成的?

在冷启动的基础上开展了大规模强化学习:

-

在初始阶段,特别针对数学和编程任务进行了 RL 训练。与依赖传统的奖励模型(reward model)不同,通过校验生成答案的正确性来为数学问题提供反馈,并通过代码执行服务器评估生成的代码是否成功通过测试用例来提供代码的反馈。

-

在第一阶段的 RL 过后,增加了另一个针对通用能力的 RL。此阶段使用通用奖励模型和一些基于规则的验证器进行训练。通过少量步骤的通用 RL,可以提升其他通用能力,同时在数学和编程任务上的性能没有显著下降。

QwQ-32B技术要点

模型类型: Causal Language Models``训练阶段:预训练与后训练(包括监督微调和强化学习)``架构:采用 RoPE、SwiGLU、RMSNorm 和注意力 QKV 偏置的 Transformer 架构``参数数量:32.5B``非嵌入层参数数量:31.0B``层数:64 层``注意力头数量(GQA):Q 为 40 个,KV 为 8 个``上下文长度:完整支持 131,072 个tokens

一、千问QwQ-32B:参数少但性能炸裂

阿里通义千问团队今日凌晨正式开源推理模型QwQ-32B,仅凭320亿参数(非嵌入参数31亿),竟在多项关键指标上追平甚至超越参数规模超6710亿的顶尖模型DeepSeek-R1!

性能亮点速览:

• 数学推理:在AIME24评测中表现与DeepSeek-R1持平,远超同类模型o1-mini;

• 代码生成:LiveCodeBench测试中,代码通过率与DeepSeek-R1相当;

• 通用能力:在指令遵循(IFEval)、函数调用(BFCL)等测试中,综合得分超越DeepSeek-R1;

• 超长上下文:支持131K token的输入长度,可处理复杂长文本任务。

更让开发者狂喜的是:QwQ-32B采用密集架构(Dense),无需复杂并行技术,普通显卡(如苹果M4 Max芯片笔记本)即可本地部署!成本仅为DeepSeek-R1的1/10,堪称中小企业的“生产力救星”。

评估集的测试效果

评估集的测试效果

怎么使用QwQ-32B

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/QwQ-32B"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

prompt = "How many r's are in the word \"strawberry\""

messages = [

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(

**model_inputs,

max_new_tokens=32768

)

generated_ids = [

output_ids[len(input_ids):] for input_ids, output_ids inzip(model_inputs.input_ids, generated_ids)

]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

print(response)

二、技术突破:强化学习(RL)炼就“思考习惯”

QwQ-32B的逆天表现,源于阿里在**大规模强化学习(RL)**上的创新实践。团队通过两阶段训练,让模型学会“像人类一样思考”:

-

- 第一阶段:专攻数学与代码

• 数学任务:通过答案正确性校验器提供反馈,而非传统奖励模型;

• 代码任务:搭建代码执行服务器,实时测试生成代码是否通过用例;

• 结果:数学推导精准度、代码生成效率持续提升,未出现性能瓶颈。

- 第一阶段:专攻数学与代码

-

- 第二阶段:通用能力跃迁

• 引入通用奖励模型+规则验证器,少量训练即提升指令遵循、人类偏好对齐等能力;

• 关键发现:RL训练中,“思考模式”比答案正确性更重要(与斯坦福最新研究结论一致)。

- 第二阶段:通用能力跃迁

划时代意义:QwQ-32B证明,中等模型+RL训练的组合,可突破参数规模限制,甚至挑战巨型MoE模型!

三、开源生态:开发者零门槛体验

阿里此次诚意拉满,全链路开放模型资源:

• 模型下载:Hugging Face、ModelScope同步上线,Apache 2.0协议商用无忧;

• 在线Demo:Hugging Face Spaces提供即时交互体验;

• API集成:示例代码已公开,快速接入现有系统。

网友实测反馈:

• “在MacBook上跑起来毫无压力,写代码比GPT-4还流畅!”

• “Agent功能绝了,调用工具时还能自我纠错!”

四、行业影响:AI平民化时代来临

QwQ-32B的开源或将改写行业规则:

• 学术圈:提供高质量基座模型,加速推理能力研究;

• 企业端:降低AI部署成本,推动金融、医疗、物流等场景落地;

• 伦理责任:阿里承诺同步开展合规性研究,平衡技术与社会责任。

专家评价:

“这是AI模型发展的重要转折点——性能天花板不再由参数数量决定,而是训练方法的革新。”

最先掌握AI的人,将会比较晚掌握AI的人有竞争优势

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

倘若大家对大模型抱有兴趣,那么这套大模型学习资料肯定会对你大有助益。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

学习路上没有捷径,只有坚持。但通过学习大模型,你可以不断提升自己的技术能力,开拓视野,甚至可能发现一些自己真正热爱的事业。

最后,送给你一句话,希望能激励你在学习大模型的道路上不断前行:

If not now, when? If not me, who?

如果不是为了自己奋斗,又是为谁;如果不是现在奋斗,什么时候开始呢?

更多推荐

已为社区贡献22条内容

已为社区贡献22条内容

所有评论(0)