DeepSeekR1 劲敌出现了,QwQ32B本地部署测试,RTX3060成功运行!

阿里千问平,突然在凌晨3点发布了最新推理模型!发布说明很简单“然后在下面甩出来几个链接,包括博客,HF,模型,演示和在线使用的网站。这条消息很简单,但是背后的东西一点都不简单。就凭一句可以,这成功了勾起了我的兴趣。除了文字描述之外, 推文中还给出了一张基准测试的图片。图中显示了 QwQ32B 和 deepseekR1 671B,以及 openai-o1的基准测试。从这个途中可以轻松的获取以下几点信

阿里千问平地一声雷,突然在凌晨3点发布了最新推理模型QwQ32B !

发布说明很简单“今天,我们发布了 QwQ32B,这是我们最新的推理模型,它只有 320亿参数,可以与 deepseek -R1 等尖端推理模型相媲美” 。

然后在下面甩出来几个链接,包括博客,HF,模型,演示和在线使用的网站。

这条消息很简单,但是背后的东西一点都不简单。

就凭一句可以32B****与DeepSeek r1 媲美,就已经可以用Diao炸天来形容了,这成功了勾起了我的兴趣。

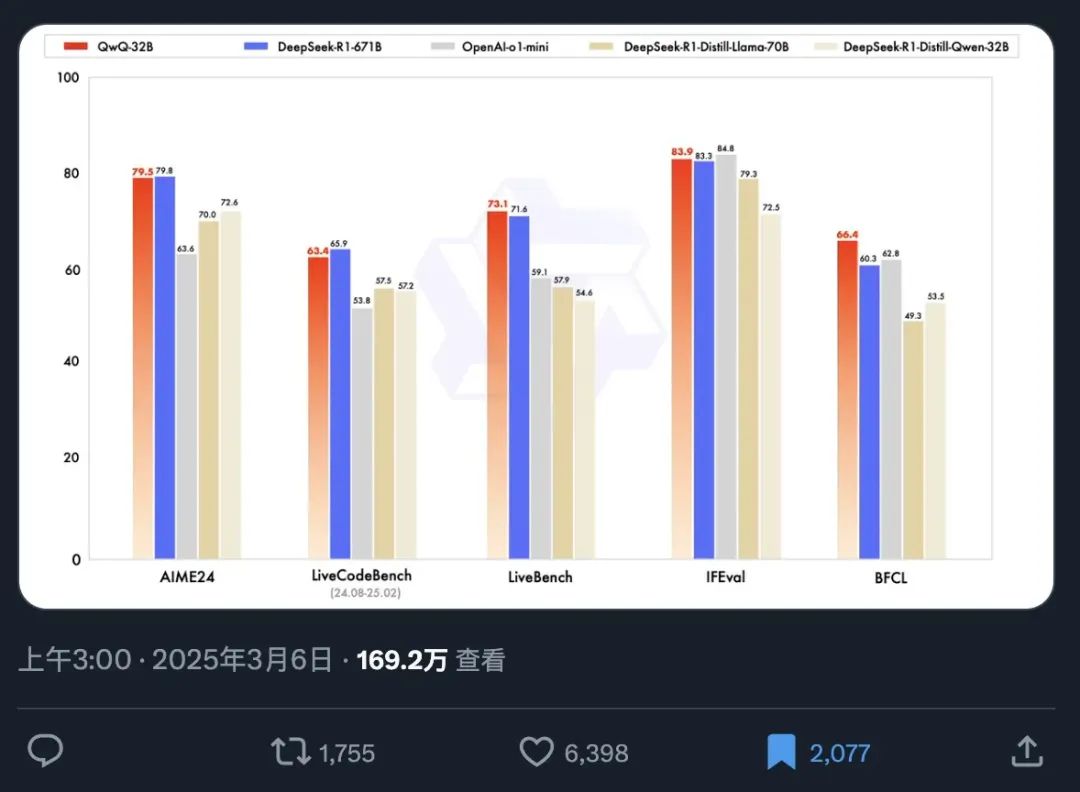

除了文字描述之外, 推文中还给出了一张基准测试的图片。

图中显示了 QwQ32B 和 deepseekR1 671B,以及 openai-o1的基准测试。从这个途中可以轻松的获取以下几点信息。

0. 12小时不到,169 万的阅读!

1. QwQ 320亿参数和 deepseekR1 6710 亿参数的满血版不分胜负(震惊.jpg)。

2. QwQ 吊打 32B 的 deepseek R1 蒸馏模型。

3. QwQ 多维度击败了 openai 的闭源模型 o1-mini

注意,这个模型只有 320亿参数啊。追平了 20 倍参数的巨无霸。

重点,现在你只要一张 RTX3090 或者 RTX4090 就可以把这个模型的量化版跑起来了。

DeepSeek 终于不孤单了,OpenAI 还有什么优势呢?

OpenAI 你好意思么?200 美金的 Pro,20 美金的Plus, 放在现在水平也一般般,还时不时降智!

既然是 32B 的模型,那么我们必须在本地安装一下试试。顺便实测一下这个本地运行的推理模型的智商。

现在要在本地运行大模型非常简单。只要 Ollama 支持就好了。

而 Ollama 的效率也极高,刚发布就支持了。

那么,一切就简单了。

人人都能上手完了。

1.安装并运行 Ollama

直接打开 ollama.com 官网,然后点击 Download 下载软件。

根据自己的操作系统来下载,目前支持 macOS的两个平台,还有 Windows 和 Linux。也就是说,基本上的系统都覆盖了。

下载完成之后,直接双击安装就好了!安装完成之后,在右下角托盘,或者 mac 的右上方,能看到一个羊驼的图标,就证明已经正常启动了。

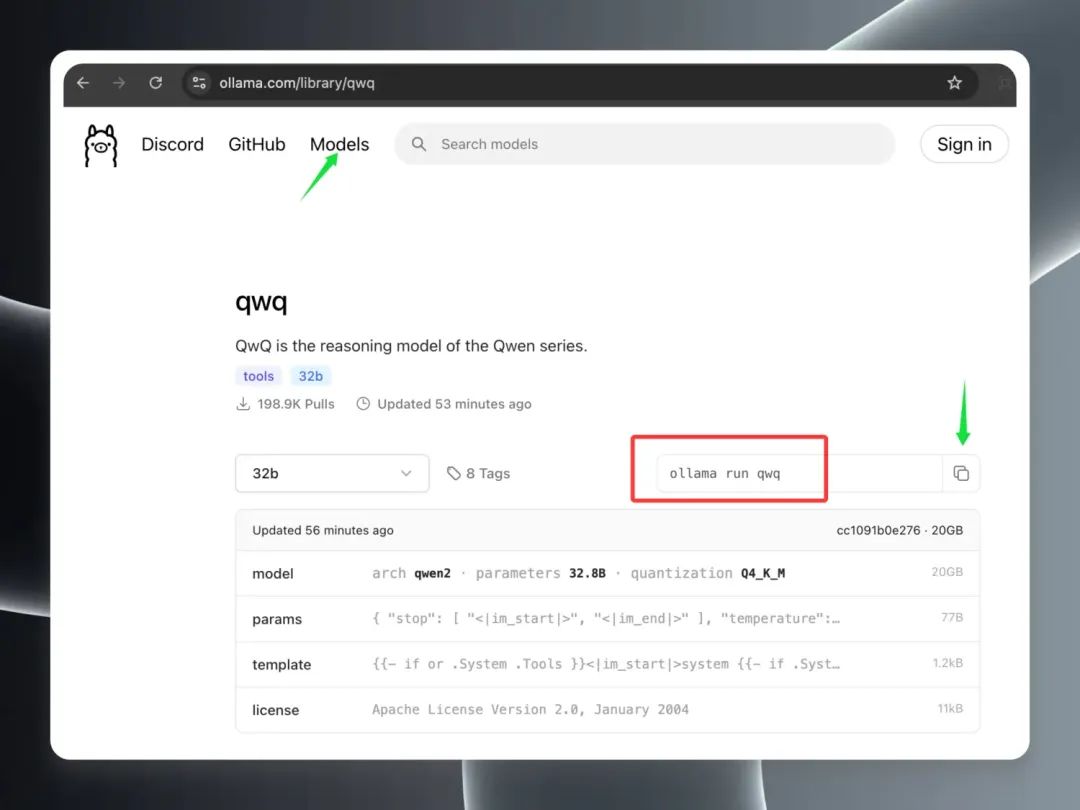

2.下载 QwQ 32B 模型

Ollama安装完成之后,就可以开始去下载 QwQ32B 这个模型了。

模型非常好找,已经在 Models 界面冲上热榜第一名了。找到 qwq 然后进入详情页。复制红色框中的命令。

打开本地的终端或者 CMD。

直接输入命令:ollama run qwq

然后 Ollama 就会自动去下载模型了,下载完成之后就会自动运行。

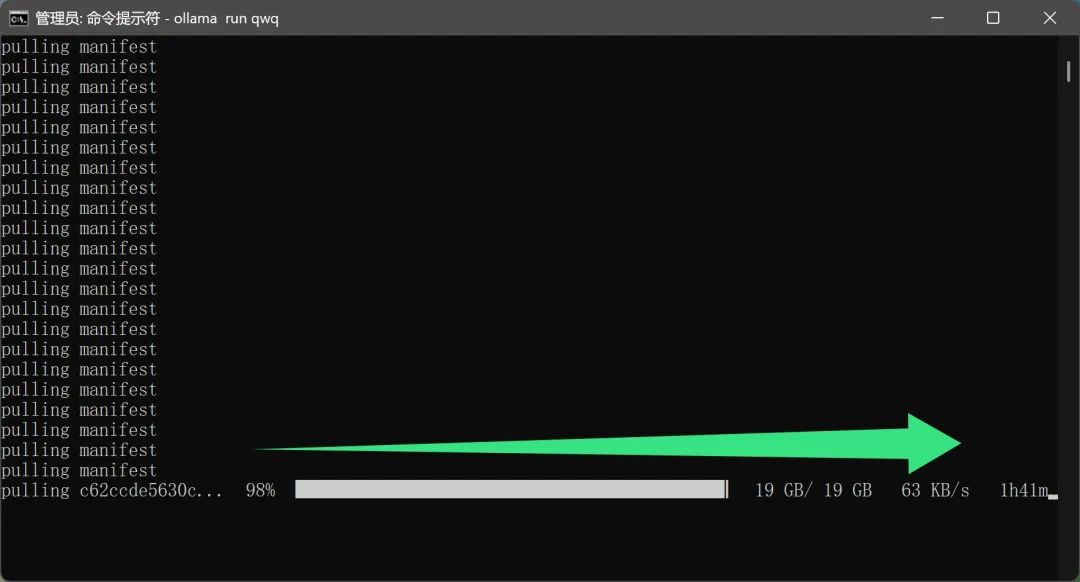

下载这个模型,好像不需要魔法。

喜大普奔啊!否则近 20G的文件,下起来也是挺耗流量。

但是,可能是当前比较热门,下载速度越来越慢,急死个人!

搞了一下午,到晚上才下完,但是运行后惊喜。

我在 RTX3060 12G上抱着试试看的心态,运行了这个大模型,居然加载成功了,输入了内容,居然有回答,没有爆显存。

而且智力程度,绝对比降智的 openai 强。

任务管理器的情况如下:

CPU,内存,显存,全部都高负荷运行了。

回答的速度大概是,哒,哒,哒,哒,哒…这种感觉。这速度只能说能用,但是不好用。

所以我又在 3090 上下了 20G 的模型。。。跑起来之后,健步如飞。

3.集成到客户端

直接在命令行对话,不太方面,我们之前介绍过很多客户端,现在就可以用上了。

我这次用的客户端是 chatwise,因为这个比较简洁。不知道这个软件怎么用,怎么下载的可以看我之前的文章。

下面简单说一下配置问题。

如果的软件和 ollama 是在同一个机器上,几乎不需要配置,打开就直接用。大部分人都是这样,打开就直接用。

如果你像我一样在另外一台电脑上安装了 ollama,那么可以像上图一样修改一下BaseURL。IP地址就是运行 ollama所在电脑的 IP地址,端口就是你自己在环境变量中配置的端口,默认端口是 13434。

配置完成之后,就可以直接选择模型了。

在 Ollama 分类下选择 qwq:latest,这个就是 32b Q4 量化模型。

4.智力测试

我在测试 openai 降智问题的时候,总结出了四个问题。只要你的 chatgpt o3 降智了,这些问题全部回答不出来。所以证明这几个问题,有一定的测试价值。

下面就一个一个来看一下,本地运行的 32B 模型,能否全部答对。

**问题 1:**deepseek 里面有几个e?

回答正确(16秒)

这个问题看似简单,现在还有大量的模型回答不了。

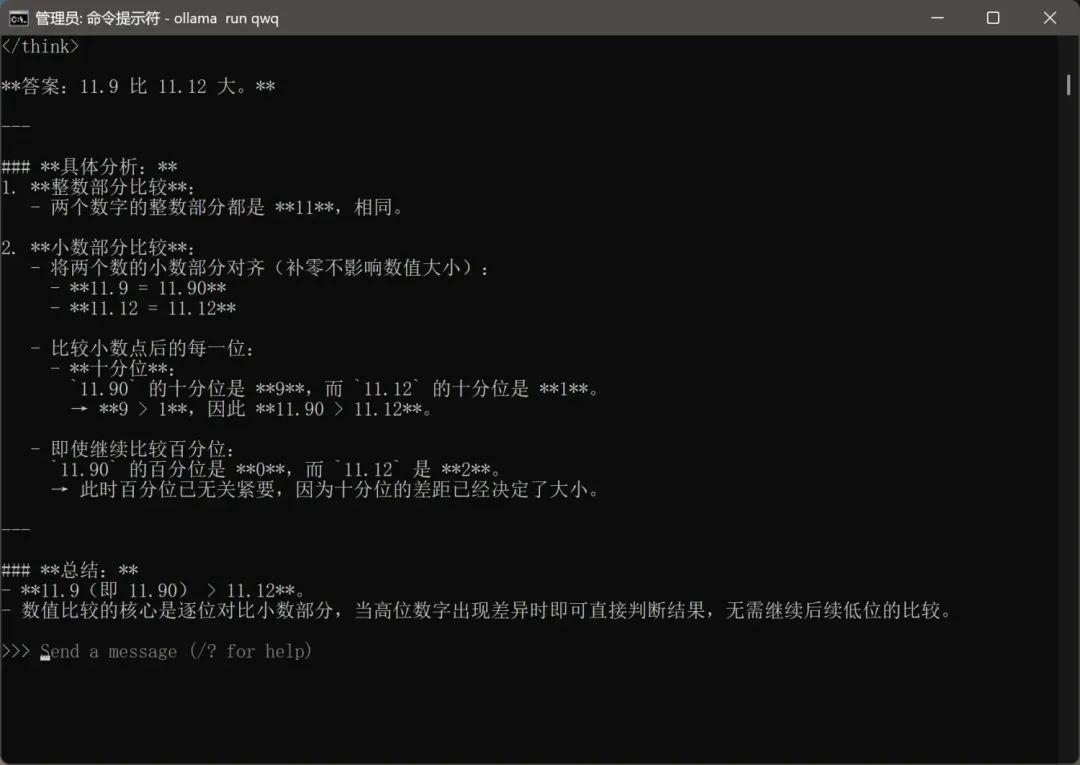

**问题 2:**11.9 和 11.12 哪个大?

回答正确(47 秒)

这也是一个经典的问题。很多大模型,连大小都比不清楚。

**问题 3:**找出一个正整数 n,使得 n! 可以被 2^n 整除

回答正确(121 秒)

这个问题的本质并不是找答案,而是要意识到没有符合的答案。

**问题 4:**有 5 个人排成一排,每人帽子颜色为红或蓝。他们可以看到前面的人的帽子,但看不到自己的。主持人宣布:“至少有一顶红帽子。”从最后一人开始,每人依次说“是”或“否”(表示是否知道自己帽子的颜色)。如果第 5 人说“否”,第 4 人说“是”,求所有可能的帽子颜色分布。

前面的问题都比较顺畅,但是这个问题出了一点状况。

第一次回答,疯狂思考,感觉脑子快烧坏了,我都有点心疼他(和我的显卡),在十多分钟的时候中断了。

重新开了一个对话,重新提问。

最终回答正确(196 秒)

然后我看了一下它的推理过程,它虽然脑子小,但是真的很努力。

结果简简单单几个字,脑子里思考了1万字啊,[完整版思考过程]。

这么测试下来,32B Q4 量化版也很强,那么 [32B 满血版]可想而知。所以基本可以判断,千问没有吹牛,QwQ 32B 确实很牛。用 320 亿的参数,能正面硬刚6710亿参数的 DeepSeek R1。

国产开源模型,一个比一个狠。

关键是,32B,只要一张24G 的显卡就能跑起来了啊,而且跑得挺快。以前简直不敢想啊,几百万的设备成本,现在可以降到一万多了。这东西出来了,感觉普通终端大有可为了。

不说了,快搞起来!!!

如何学习AI大模型?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献278条内容

已为社区贡献278条内容

所有评论(0)