【三步搞定】本地机器私有化部署Deepseek-r1:1.5b模型

模型参数规模典型用途CPU 建议GPU 建议内存建议 (RAM)磁盘空间建议适用场景1.5b (15亿)小型推理、轻量级任务4核以上 (Intel i5 / AMD Ryzen 5)可选,入门级 GPU (如 NVIDIA GTX 1650, 4GB 显存)8GB10GB 以上 SSD小型 NLP 任务、文本生成、简单分类7b (70亿)中等推理、通用任务6核以上 (Intel i7 / AMD

你还没有自己私有化部署过Deepseek吗?如果没有你就真的out了,堪称"AI界的六边形战士"我们自己是不是也应该拥有一套,不自己部署一个是不是缺点意思?!

AI军备竞赛已经开始打响,作为普通人无法避开科技浪潮,如何不让自己随波逐流,或许我们需要躬身入局去体验,思考和探索。

在本地部署 DeepSeek 只需要以下三步:

- 安装 Ollama

- 部署 DeepSeek

- 安装 open-webui【非必须,可选】

Ollama、DeepSeek 和 Open Web UI 三者之间的关系如下:

Ollama

- 定义:Ollama 是一个用于本地运行和管理大型语言模型(LLM)的开源工具,旨在简化在本地计算机上部署、运行和管理大型语言模型的流程。它支持多种操作系统(如 macOS、Linux 和 Windows),并提供了丰富的功能,使开发者、研究人员以及对数据隐私有较高要求的用户能够轻松地在本地环境中使用和定制大语言模型。Ollama 允许用户在本地运行多种开源大语言模型,如 LLaMA 2、DeepSeek、Mistral、Gemma 等,无需依赖云端服务,从而更好地保护数据隐私并降低延迟。

- 功能:Ollama 提供了对模型的管理功能,包括模型的下载、运行、参数调整等。它还支持多种模型,包括 DeepSeek。

-

DeepSeek

- 定义:DeepSeek 是一个开源的大型语言模型,由 Moonshot AI 开发。它在 2025 年 1 月发布了 DeepSeek-R1 推理大模型。

- 功能:DeepSeek 提供了强大的语言生成能力,可以用于多种自然语言处理任务。它可以通过 Ollama 进行本地部署和管理。

-

Open Web UI

- 定义:Open Web UI 是一个开源的 Web 界面工具,旨在提供一个用户友好的界面来与本地运行的 AI 模型进行交互。

- 功能:Open Web UI 提供了可视化交互界面,支持多种 LLM 运行程序,包括 Ollama。它允许用户通过浏览器与 Ollama 管理的模型(如 DeepSeek)进行交互,并提供了丰富的功能,如 Markdown 和 LaTeX 支持。

三者的关系

- Ollama 是一个“大管家”,用于管理和运行 AI 模型的工具,就像一个大模型的治理工具,DeepSeek 是一个具体的 AI 模型,是一个“超级大脑”,可以回答我们各种问题,可以通过 Ollama 进行管理和运行。

- Open Web UI 是一个可视化界面工具,是一个“聊天工具”,用于与 Ollama 管理的模型(如 DeepSeek)进行交互,让我们更方便地和DeepSeek交流。它为用户提供了一个更友好的操作界面。类似的可视化界面工具还有ChatBox。

我们先来看一下命令行运行起来的效果:

webui可视化管理模型运行起来的效果:

笔记本环境配置:

是不是很神奇,自己电脑上都能跑起来大模型了

我们先看那一下DeepSeek版本介绍,之后根据自己机器的配置选择要安装的版本:

|

模型参数规模 |

典型用途 |

CPU 建议 |

GPU 建议 |

内存建议 (RAM) |

磁盘空间建议 |

适用场景 |

|---|---|---|---|---|---|---|

|

1.5b (15亿) |

小型推理、轻量级任务 |

4核以上 (Intel i5 / AMD Ryzen 5) |

可选,入门级 GPU (如 NVIDIA GTX 1650, 4GB 显存) |

8GB |

10GB 以上 SSD |

小型 NLP 任务、文本生成、简单分类 |

|

7b (70亿) |

中等推理、通用任务 |

6核以上 (Intel i7 / AMD Ryzen 7) |

中端 GPU (如 NVIDIA RTX 3060, 12GB 显存) |

16GB |

20GB 以上 SSD |

中等规模 NLP、对话系统、文本分析 |

|

14b (140亿) |

中大型推理、复杂任务 |

8核以上 (Intel i9 / AMD Ryzen 9) |

高端 GPU (如 NVIDIA RTX 3090, 24GB 显存) |

32GB |

50GB 以上 SSD |

复杂 NLP、多轮对话、知识问答 |

|

32b (320亿) |

大型推理、高性能任务 |

12核以上 (Intel Xeon / AMD Threadripper) |

高性能 GPU (如 NVIDIA A100, 40GB 显存) |

64GB |

100GB 以上 SSD |

大规模 NLP、多模态任务、研究用途 |

|

70b (700亿) |

超大规模推理、研究任务 |

16核以上 (服务器级 CPU) |

多 GPU 并行 (如 2x NVIDIA A100, 80GB 显存) |

128GB |

200GB 以上 SSD |

超大规模模型、研究、企业级应用 |

|

671b (6710亿) |

超大规模训练、企业级任务 |

服务器级 CPU (如 AMD EPYC / Intel Xeon) |

多 GPU 集群 (如 8x NVIDIA A100, 320GB 显存) |

256GB 或更高 |

1TB 以上 NVMe SSD |

超大规模训练、企业级 AI 平台 |

为了能够运行成功,我们就选取部署1.5b的。1.5b,1.5Billion,15亿参数规模。

安装 Ollama

使用Homebrew安装:

使用命令:brew install ollama

% brew install ollama

==> Auto-updating Homebrew...

Adjust how often this is run with HOMEBREW_AUTO_UPDATE_SECS or disable with

HOMEBREW_NO_AUTO_UPDATE. Hide these hints with HOMEBREW_NO_ENV_HINTS (see `man brew`).

^C==> Downloading https://formulae.brew.sh/api/formula.jws.json

########################################################################################################################################## 100.0%

==> Downloading https://formulae.brew.sh/api/formula_tap_migrations.jws.json

########################################################################################################################################## 100.0%

==> Downloading https://formulae.brew.sh/api/cask.jws.json

########################################################################################################################################## 100.0%

==> Downloading https://formulae.brew.sh/api/cask_tap_migrations.jws.json

########################################################################################################################################## 100.0%

Warning: Treating ollama as a formula. For the cask, use homebrew/cask/ollama or specify the `--cask` flag. To silence this message, use the `--formula` flag.

Warning: You are using macOS 12.

We (and Apple) do not provide support for this old version.

It is expected behaviour that some formulae will fail to build in this old version.

It is expected behaviour that Homebrew will be buggy and slow.

Do not create any issues about this on Homebrew's GitHub repositories.

Do not create any issues even if you think this message is unrelated.

Any opened issues will be immediately closed without response.

Do not ask for help from Homebrew or its maintainers on social media.

You may ask for help in Homebrew's discussions but are unlikely to receive a response.

Try to figure out the problem yourself and submit a fix as a pull request.

We will review it but may or may not accept it.

==> Fetching dependencies for ollama: cmake and go

==> Fetching cmake

==> Downloading https://raw.githubusercontent.com/Homebrew/homebrew-core/1dcb0baf4a6816ea98006489556cb4dae04b8453/Formula/c/cmake.rb

########################################################################################################################################## 100.0%

==> Downloading https://github.com/Kitware/CMake/releases/download/v3.31.5/cmake-3.31.5.tar.gz

==> Downloading from https://objects.githubusercontent.com/github-production-release-asset-2e65be/537699/9ec949a1-2626-4bc3-a60a-e7655dc83b43?X-A

########################################################################################################################################## 100.0%

==> Fetching go

==> Downloading https://raw.githubusercontent.com/Homebrew/homebrew-core/1dcb0baf4a6816ea98006489556cb4dae04b8453/Formula/g/go.rb

########################################################################################################################################## 100.0%

==> Downloading https://storage.googleapis.com/golang/go1.20.14.darwin-amd64.tar.gz

########################################################################################################################################## 100.0%

==> Downloading https://go.dev/dl/go1.23.6.src.tar.gz

==> Downloading from https://dl.google.com/go/go1.23.6.src.tar.gz

########################################################################################################################################## 100.0%

==> Fetching ollama

==> Downloading https://raw.githubusercontent.com/Homebrew/homebrew-core/1dcb0baf4a6816ea98006489556cb4dae04b8453/Formula/o/ollama.rb

########################################################################################################################################## 100.0%

==> Cloning https://github.com/ollama/ollama.git

Cloning into '/Users/cheng.tang/Library/Caches/Homebrew/ollama--git'...

==> Checking out tag v0.5.7

HEAD is now at a420a453 fix default modelfile for create (#8452)

==> Installing dependencies for ollama: cmake and go

==> Installing ollama dependency: cmake

==> Patching

==> ./bootstrap --prefix=/usr/local/Cellar/cmake/3.31.5 --no-system-libs --parallel=12 --datadir=/share/cmake --docdir=/share/doc/cmake --mandir=

==> make

==> make install

==> Downloading https://formulae.brew.sh/api/formula.jws.json

########################################################################################################################################## 100.0%

🍺 /usr/local/Cellar/cmake/3.31.5: 3,767 files, 62.7MB, built in 12 minutes 42 seconds

==> Installing ollama dependency: go

==> ./make.bash

==> /usr/local/Cellar/go/1.23.6/bin/go install std cmd

🍺 /usr/local/Cellar/go/1.23.6: 13,239 files, 272.3MB, built in 3 minutes 57 seconds

==> Installing ollama

==> go generate ./...

==> go build -ldflags=-s -w -X=github.com/ollama/ollama/version.Version=0.5.7 -X=github.com/ollama/ollama/server.mode=release

==> Caveats

To start ollama now and restart at login:

brew services start ollama

Or, if you don't want/need a background service you can just run:

/usr/local/opt/ollama/bin/ollama serve

==> Summary

🍺 /usr/local/Cellar/ollama/0.5.7: 8 files, 25.3MB, built in 2 minutes 35 seconds

==> Running `brew cleanup ollama`...

Disable this behaviour by setting HOMEBREW_NO_INSTALL_CLEANUP.

Hide these hints with HOMEBREW_NO_ENV_HINTS (see `man brew`).

==> `brew cleanup` has not been run in the last 30 days, running now...

Disable this behaviour by setting HOMEBREW_NO_INSTALL_CLEANUP.

Hide these hints with HOMEBREW_NO_ENV_HINTS (see `man brew`).

Removing: /Users/cheng.tang/Library/Caches/Homebrew/ca-certificates--2024-11-26.all.bottle.tar.gz... (133.8KB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/go--gobootstrap--1.20.14.tar.gz... (95.5MB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/sqlite--3.47.1.tar.gz... (3.2MB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/xz--5.6.3.tar.gz... (2.2MB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/go_mod_cache... (11,864 files, 281MB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/go_cache... (7,337 files, 865.9MB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/Cask/docker--4.36.0,175267.dmg... (509MB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/Cask/wireshark--4.4.2.dmg... (66.0MB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/api-source/Homebrew/homebrew-core/ba88823a4b85f26db08da252d4350d197cc27f9f/Formula/openssl@3.rb... (7.1KB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/api-source/Homebrew/homebrew-core/ba88823a4b85f26db08da252d4350d197cc27f9f/Formula/pkgconf.rb... (3.3KB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/api-source/Homebrew/homebrew-core/ba88823a4b85f26db08da252d4350d197cc27f9f/Formula/python@3.13.rb... (21.8KB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/api-source/Homebrew/homebrew-core/ba88823a4b85f26db08da252d4350d197cc27f9f/Formula/sqlite.rb... (2.8KB)

Removing: /Users/cheng.tang/Library/Caches/Homebrew/api-source/Homebrew/homebrew-core/ba88823a4b85f26db08da252d4350d197cc27f9f/Formula/xz.rb... (2.3KB)

Removing: /Users/cheng.tang/Library/Logs/Homebrew/python@3.13... (17 files, 5.2MB)

Removing: /Users/cheng.tang/Library/Logs/Homebrew/sqlite... (6 files, 216KB)

Removing: /Users/cheng.tang/Library/Logs/Homebrew/xz... (7 files, 1.3MB)

Removing: /Users/cheng.tang/Library/Logs/Homebrew/pkgconf... (7 files, 206.5KB)

Removing: /Users/cheng.tang/Library/Logs/Homebrew/openssl@3... (7 files, 7.9MB)

Removing: /Users/cheng.tang/Library/Logs/Homebrew/ca-certificates... (64B)

==> Caveats

==> ollama

To start ollama now and restart at login:

brew services start ollama

Or, if you don't want/need a background service you can just run:

/usr/local/opt/ollama/bin/ollama serve安装完成后启动ollama:

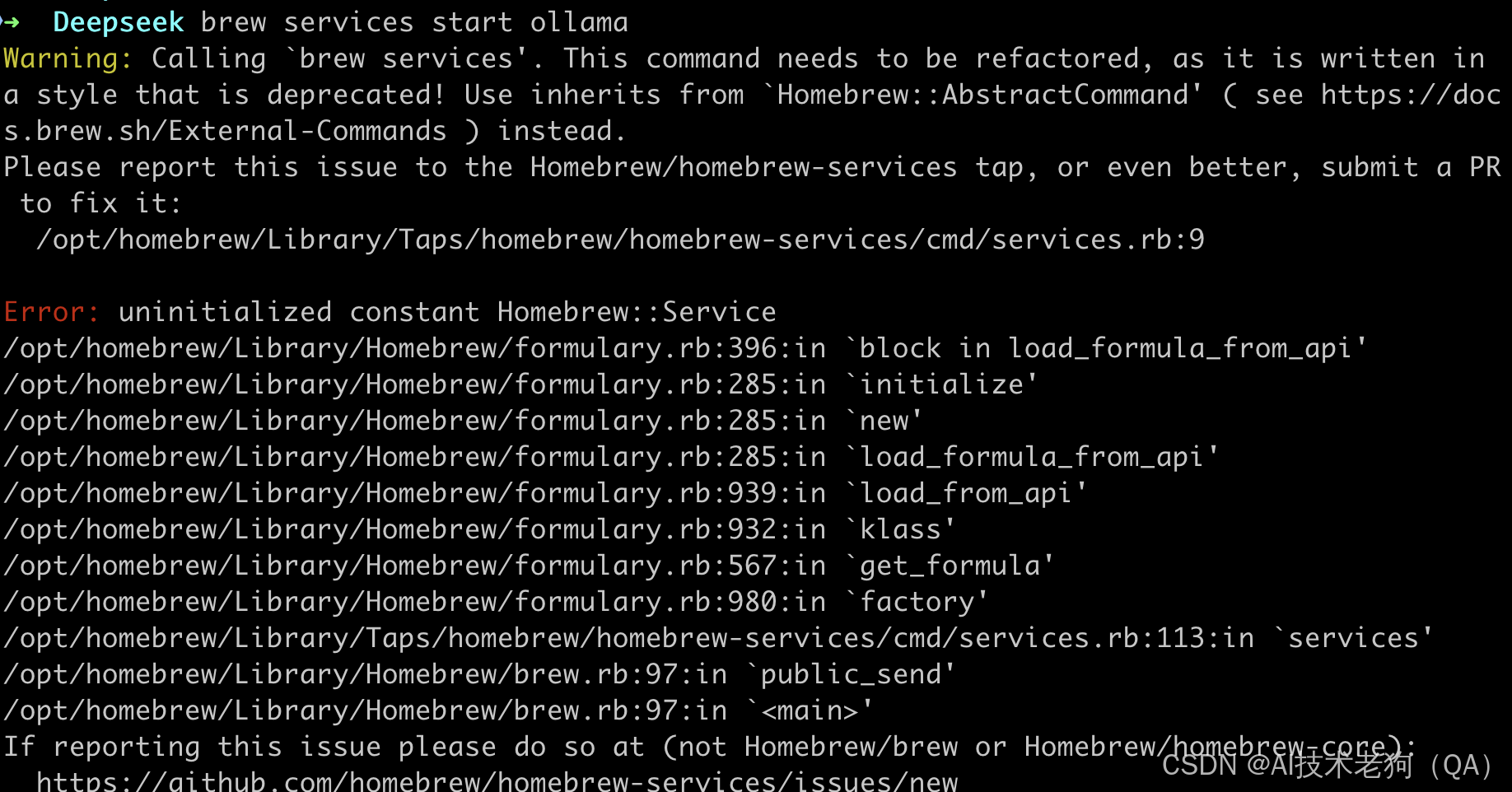

命令:

brew services start ollama

通过ollama拉取安装Deepseek:

命令:

ollama pull deepseek-r1:1.5b

运行Deepseek:

命令:

ollama run deepseek-r1:1.5b安装open-webui:

open-webui地址:

https://github.com/open-webui/open-webui

安装完成了就能看到文章开始的问答运行效果了,可以看到界面版本的窗口了

可以肆无忌惮的调戏Deepseek了 ^_^

问:

请告诉我如何训练本地化私有模型的医学能力答:

deepseek-r1:1.5b

Today at 18:35

思考用时 5 秒

在本地笔记本中使用 DeepSeek-R1:1.5B 模型来训练并应用到医学能力模型方面,可以按照以下步骤进行。由于 DeepSeek-R1:1.5B 是一个通用深度学习模型,可能需要一些特殊调整才能使其适用于特定的医学任务。以下是具体步骤:

1. 提供数据集

医学领域中的数据通常包含大量患者的数据,如患者的生理特征、疾病信息等。例如:

公开可用数据:可以使用 S3 数据库中的公共医疗数据集(如 UCI 二病分组数据库或 medical datasets)。这些数据集可能已经包含医疗相关的特征。

本地数据:如果需要训练一个本地化模型,可以手动收集或获取患者的数据,例如:

病史记录

基本临床诊断信息

物理学、生物学等基础数据

2. 构建医学能力模型

根据医学任务需求,可以将 DeepSeek-R1:1.5B 模型作为分类器或预测模型使用。例如:

疾病诊断:输入患者的基本特征,输出对特定疾病的概率

疾病风险评估:输出不同疾病的风险评分

治疗预测:预测患者的治疗效果

药物推荐:根据患者特征推荐相关药物

3. 设置训练环境

由于 DeepSeek-R1:1.5B 是一个通用模型,可能需要一些调整:

环境变量配置:

本地运行的笔记本是否支持 GPU?

是否有特殊的可用模型设置?

依赖项安装:

如果使用了 TF 或 PyTorch 等库,确保它们是本地版本(如 paddle.fusion)。

数据预处理:

数据集需要标准化或归一化(例如,将患者特征转换为数值格式),以便模型学习。

可以使用 OpenCV 或 scikit-learn 进行图像/文本特征提取。

4. 训练过程

以下是一般的训练步骤,结合医学应用的需求:

数据预处理:

将患者数据(如病史记录、生理数据等)编码为可以输入模型的格式(例如词嵌入)

模型设置:

可以将模型作为分类器或预测器使用。

训练策略:

使用交叉验证来评估模型性能,特别是对于医学任务,可能需要多轮交叉验证。

优化:

调整学习率、批量大小、损失函数(如 BCEWithLogitsLoss 或 CrossEntropyLoss)等,以提高模型表现。

5. 评估与解释

在医学应用中,除了准确率,还需要考虑其他相关指标:

精确度(Precision):true positive / (true positive + false positive)

召回率(Recall):true positive / (true positive + false negative)

F1 分数:2 * (precision * recall) / (precision + recall)

面积Under ROC Curve (AUC)

6. 应用与部署

将训练好的模型应用到医学场景:

API/笔记本调用:

如果是本地模型,可以编写 Python 程序(如 PyTorch 或 TensorFlow)将模型调用并返回结果。

医疗平台集成:

可以将模型与医院的其他医疗数据(例如电子表格、图像)整合到医疗平台上。

7. 挑战与优化

由于医学应用涉及高敏感性和低特异性,可能会有以下挑战:

解释性需求:如何解释模型决策过程?

资源消耗:本地化模型可能需要更多的计算资源。

患者隐私:数据集可能包括个人信息,需确保符合隐私政策。

8. 个性化医疗

结合医学任务,可以尝试一些个性化策略:

分阶段训练:

首先训练基础分类模型(如疾病诊断)

然后根据患者特征进一步优化模型

强化学习:

如果有时间和数据,可以尝试在患者状态(如健康、病态)之间进行决策。

集成其他医疗模块:

结合图像识别或临床记录处理,以提高模型性能。

总结

训练本地化医学能力模型时,需要考虑以下几点:

数据集的特殊性(如包含患者特征)

模型的通用性和针对性

评估指标的细化(如精确度、召回率等)

应用场景的独特需求

通过以上步骤,您可以尝试在本地笔记本中训练一个医学能力模型,并应用到实际医疗场景中。虽然1r:1.5b是最基础的版本,但是我们也算是拥有自己的模型了,开不开心,我们也可以准备数据进行训练他了,让他更懂你的心^_^

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)