锡产感知带你将部署完成的DeepSeek应用到自己的工程

DeepSeek大模型API调用

·

最近国产大模型 DeepSeek 非常火,DeepSeek 是一个开源模型,我们可以通过本地部署在自己的终端上随时使用,部署到本地后无需联网即可直接使用。基于Ollama框架部署DeepSeek或其他AI大模型,可以参考我的博客:

相信我们很多开发人员都使用过Postman对WebService接口进行开发调试。

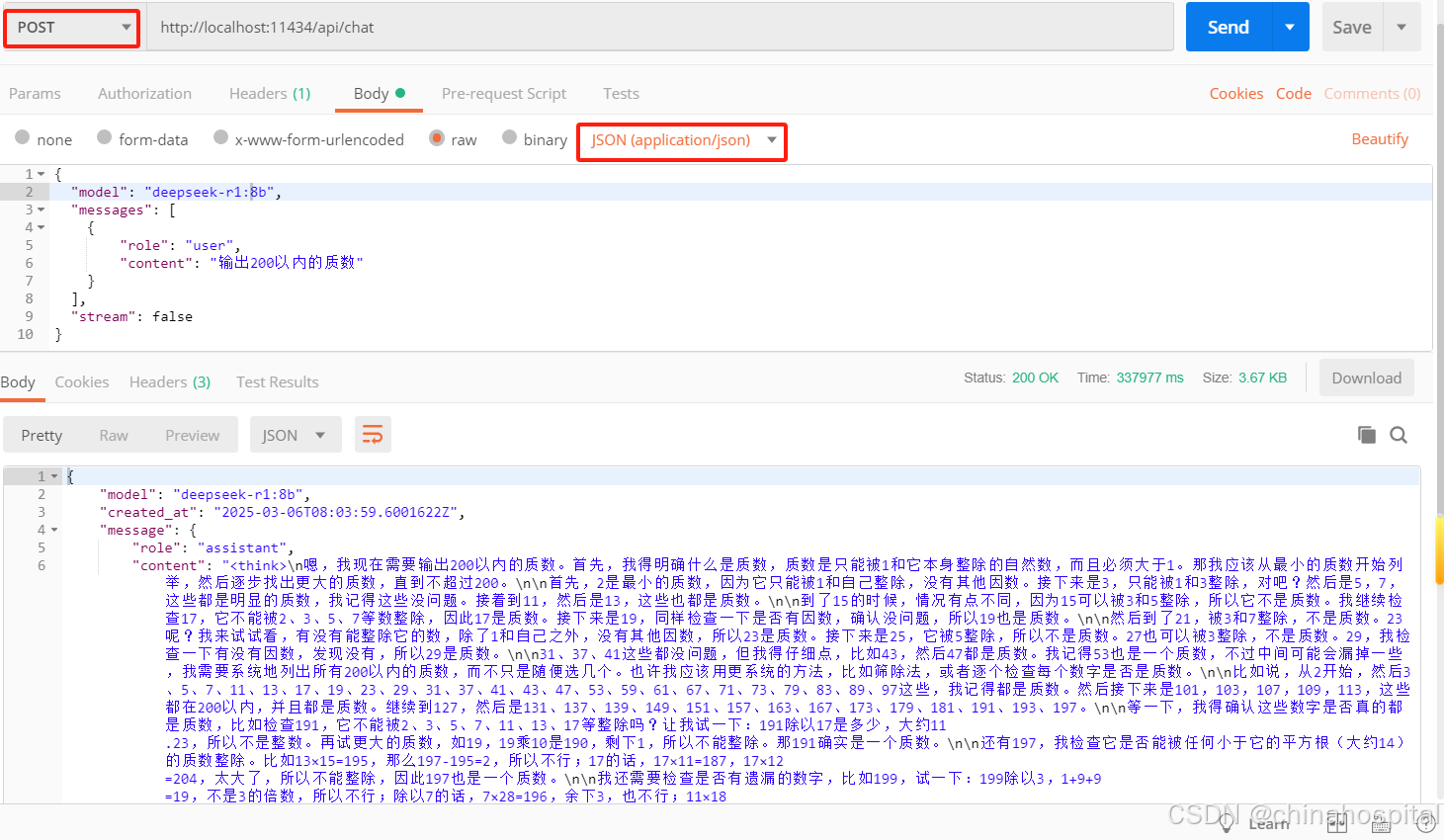

我这边部署完成后,使用Postman访问Ollama API并调用DeepSeek模型

使用Postman配置请求

请求类型为 POST。

在“输入”框中输入Ollama的API URL,本地部署的是 http://localhost:11434/api/chat(确保你的Ollama服务正在本地运行,Ollama没启动会一直卡着)。

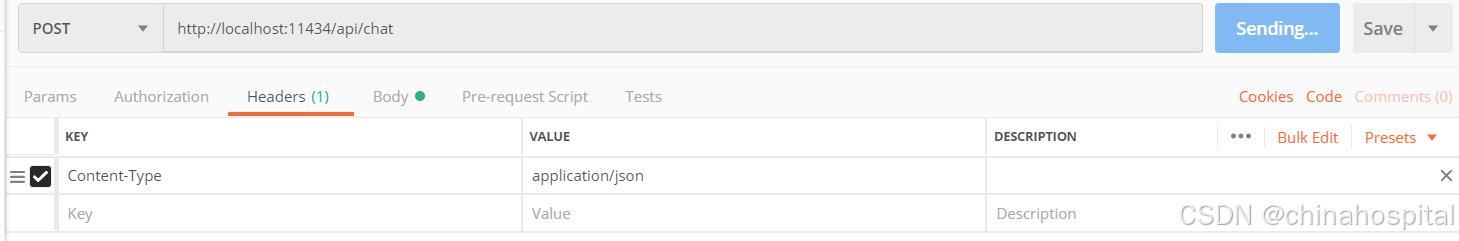

在“Header”标签页中,默认添加了以下内容:

Key: Content-Type

Value: application/json

编写请求体:

在“Body”标签页中,选择“raw”并设置编码为“JSON (application/json)”。

输入以下JSON格式的请求体:

{

"model": "deepseek-r1:8b",

"messages": [

{

"role": "user",

"content": "输出200以内的质数"

}

],

"stream": false

}我的本地大模型(http://localhost:11434/api/chat)查询出的结果

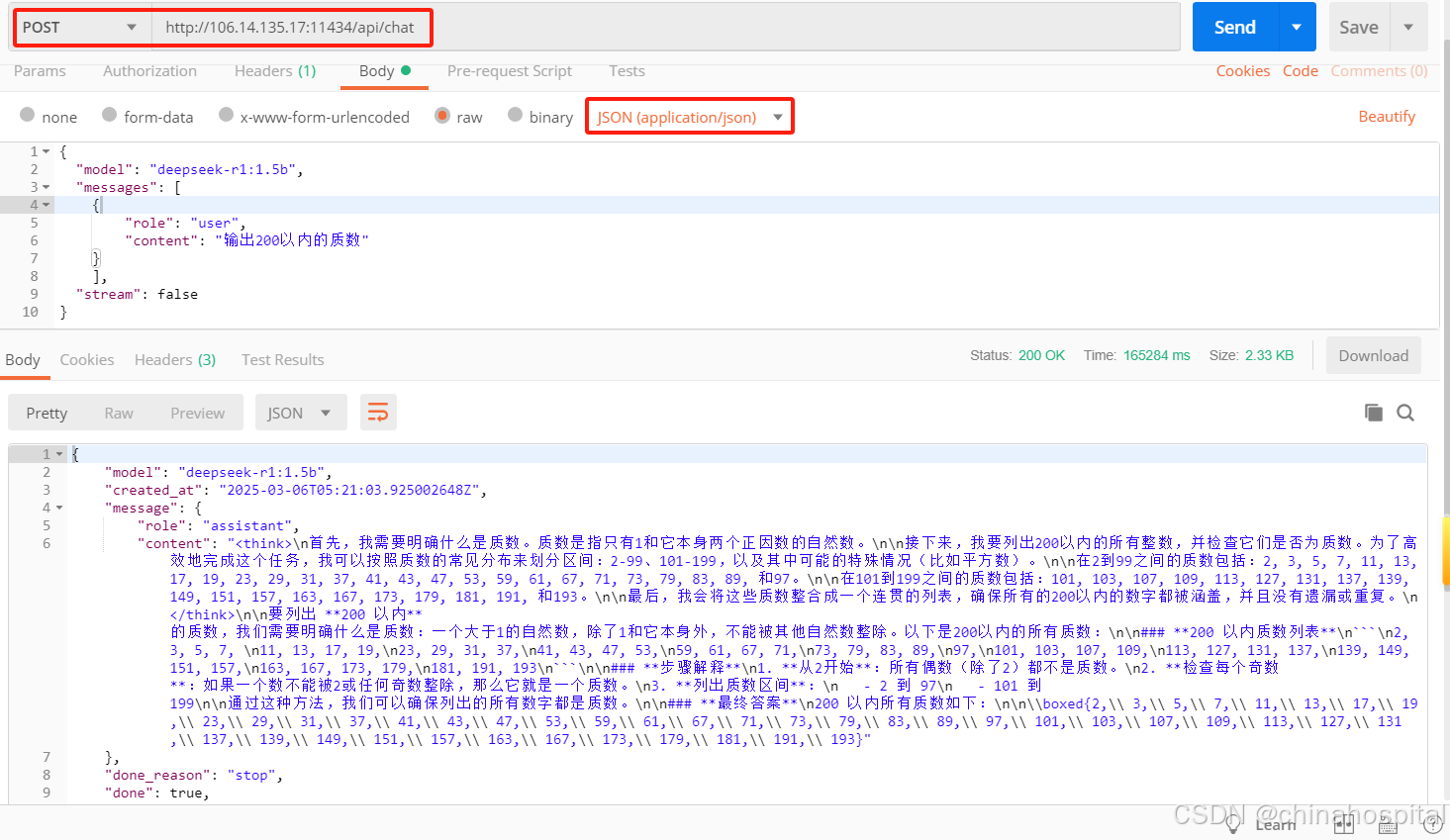

我的云端大模型(http://106.14.135.17:11434/api/chat)查询出的结果

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)