【AI】本地部署DeepSeek模型:从环境搭建到高效应用的完整指南

随着大模型技术的普及,本地部署成为保护数据隐私和实现定制化需求的关键方案。DeepSeek-R1作为开源大模型,凭借其强大的语义理解能力和灵活的部署方式,成为科研、企业及开发者的热门选择。

·

-

引言

随着大模型技术的普及,本地部署成为保护数据隐私和实现定制化需求的关键方案。DeepSeek-R1作为开源大模型,凭借其强大的语义理解能力和灵活的部署方式,成为科研、企业及开发者的热门选择

一、环境准备:硬件与软件要求

本地部署需根据模型版本选择硬件配置:

硬件需求

- 基础版(1.5B/8B):NVIDIA显卡(显存≥4GB,如RTX 3090)、16GB内存、50GB存储

- 高性能版(14B/32B):高端显卡(显存≥16GB,如RTX 4090)、32GB内存、100GB存储

- 满血版(70B+):需多卡A100/H100集群,显存≥80GB,内存≥128GB

二、部署流程:5步完成本地化

安装Ollama

Ollama 下载安装包(Windows选.exe,Mac选.dmg)

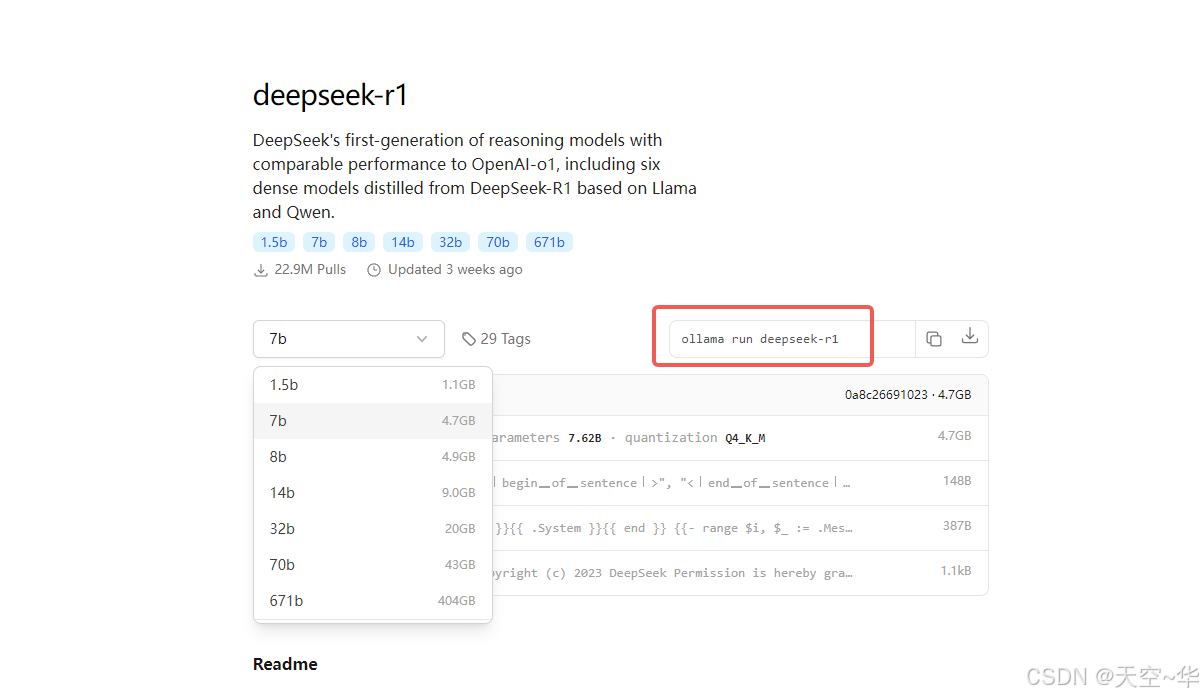

拉取模型文件

- 跳转到模型选择页面,选择适合自己的模型文件,页面地址: deepseek-r1

- 根据硬件选择模型版本(如

deepseek-r1:14b),打开CMD命令行执行:bash -

ollama run deepseek-r1:7b - 支持断点续传,若下载过慢可重启任务,windows 输入ctrl+c 即可

- 下载成功后,windows会直接弹出对话

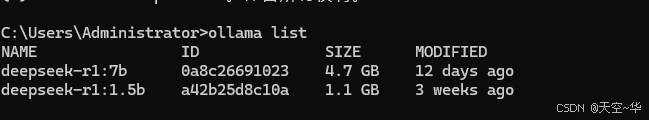

验证部署

- 查看已安装模型:

ollama list

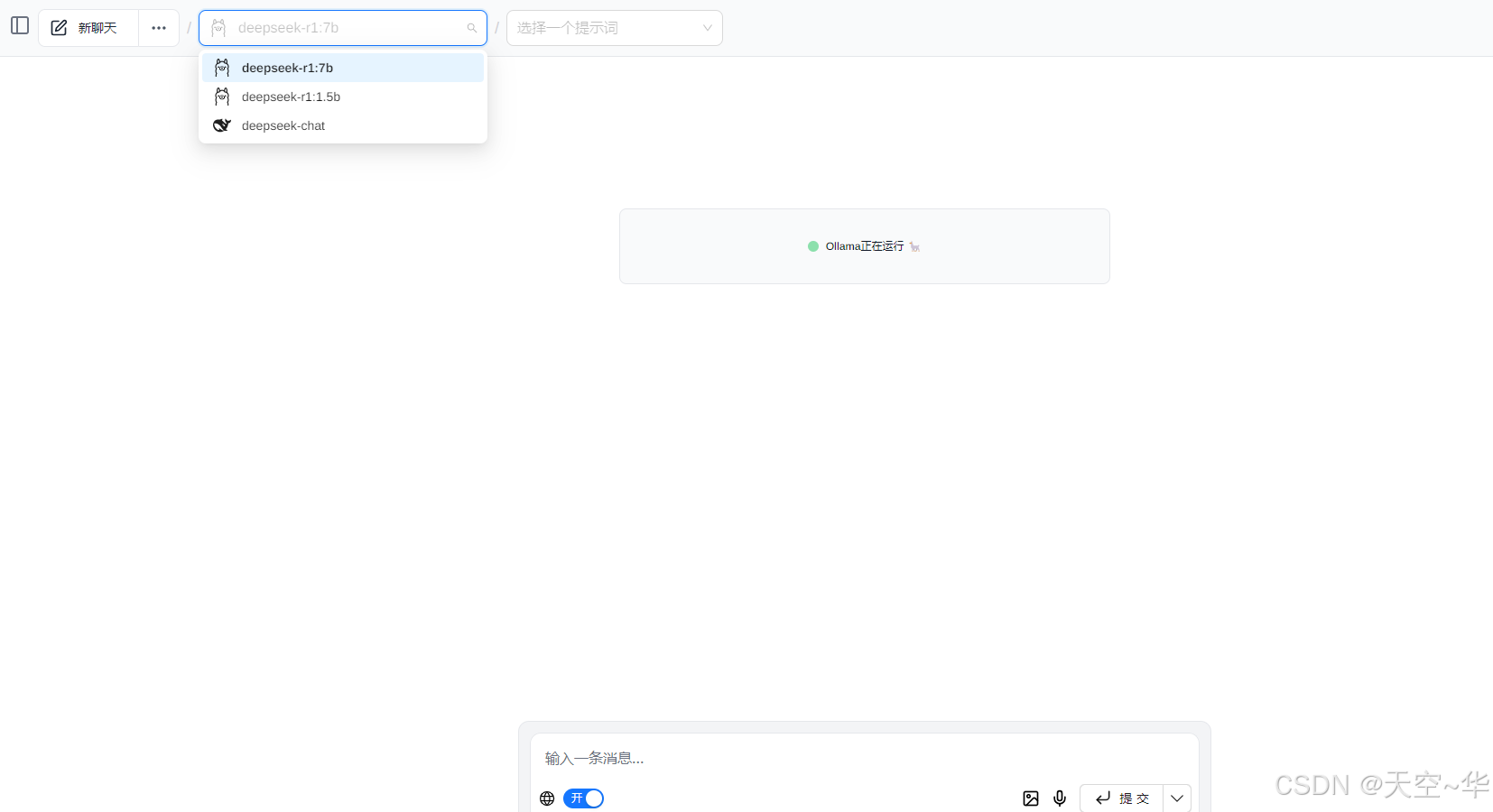

可视化界面扩展(可选)

- 去Google 商店搜索Page Assist 插件下载,可能需要翻墙。

- 安装Page Assist或Chatbox AI浏览器插件,提供类ChatGPT的交互界面。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)