【RAG 实践】DeepSeek+RagFlow+Ollama搭建本地大模型知识库

RAGFlow是一个基于深度文档理解的开源RAG(检索增强生成)引擎。当与LLM集成时,它能够提供真实的问答功能,并得到各种复杂格式数据的充分引用的支持。启动本地RAGFlow服务器创建知识库干预文件解析以基于您的数据集建立人工智能聊天。

【RAG 实践】DeepSeek + RagFlow+ Ollama 搭建本地大模型知识库

前言

RAGFlow是一个基于深度文档理解的开源RAG(检索增强生成)引擎。当与LLM集成时,它能够提供真实的问答功能,并得到各种复杂格式数据的充分引用的支持。

本快速入门指南描述了以下一般流程:

- 启动本地RAGFlow服务器

- 创建知识库

- 干预文件解析

- 以基于您的数据集建立人工智能聊天

RagFlow的安装和部署

前置条件

- CPU >= 4 核

- RAM >= 16 GB

- Disk >= 50 GB

- Docker >= 24.0.0 & Docker Compose >= v2.26.1

安装

克隆仓库

git clone https://github.com/infiniflow/ragflow.git

进入 docker 文件夹,利用提前编译好的 Docker 镜像启动服务器:

cd ragflow/docker

chmod +x ./entrypoint.sh

docker compose -f docker-compose-CN.yml up -d

服务器启动成功后再次确认服务器状态:

docker logs -f ragflow-server

启动成功后,查看启动端口

docker ps

访问地址:http://localhost:80 先注册账号,是下面这个页面

注册登录

在上图的界面中注册,然后登录就来到下面这个页面了

配置 Ollama 连接大模型

如下图我们先配置模型,点击右上角头像,再点击模型提供商

这里我是想连接我本地已经安装部署好的 Ollama ,通过 Ollama 我安装了deepseek-r1:7b大模型,具体的安装步骤在之前的那篇文章里,有需要的可以移步到那里看。

打开Ollama 后, 我是通过服务器模式启动的大模型

ollama serve

查看本地Ollama安装的模型

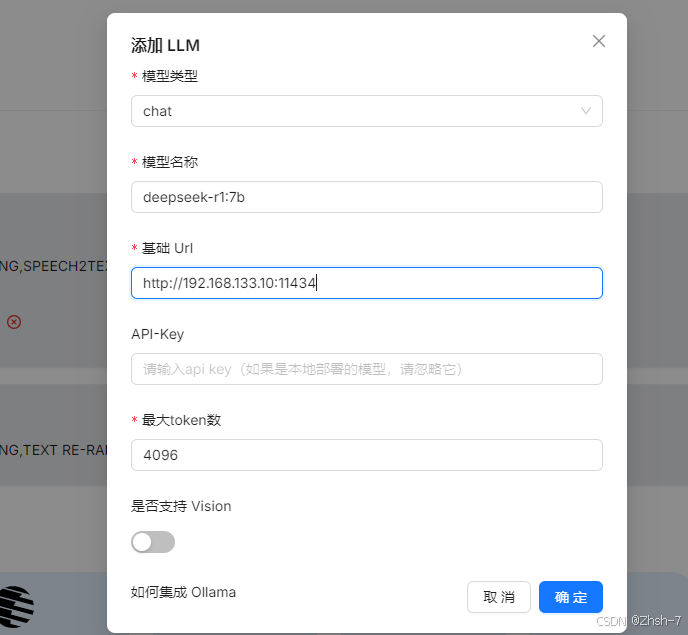

接着我们在 RagFlow 中配置模型,并使用 deepseek-r1:7b 大模型,注意由于 RagFlow 我是在 docker 中安装的,所以请求本地部署的 Ollama 地址要用 :http://192.168.133.10:11434

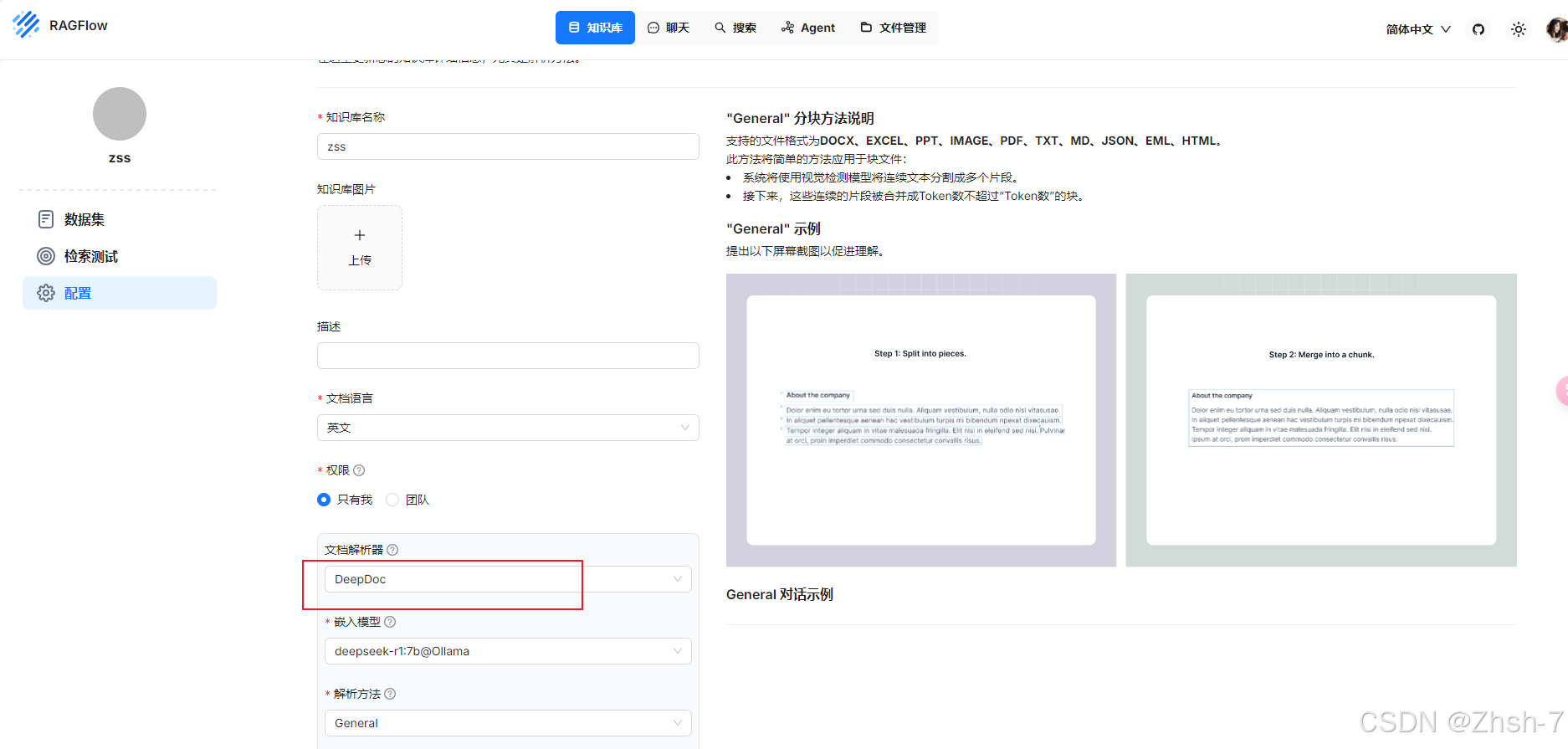

创建知识库

接下来我们就可以创建知识库了

接下来就是上传你的文件了,也比较简单,但我发现上传后文件处理的比较慢,应该是我电脑配置的原因

点击解析,这个比较耗时,取决电脑配置

文件上传并处理完成后,可以通过检索测试看一下文件有没有被正确检索。

至此,如果你上传完成全部的文件,知识库就算创建完毕了。

聊天

接着就到了展示成果的时候了,我们可以根据自己的知识库与模型进行自然语言交互了。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)