DeepSeek本地化部署及本地知识库的搭建(包含ollama和lm studio两种不同方式)

DeepSeek本地化部署及本地知识库的搭建(包含ollama和lm studio两种不同方式)

DeepSeek本地化部署及本地知识库的搭建(包含ollama和lm studio两种不同方式)

文章目录

1.deepseek本地部署

1.1 DeepSeek本地部署的必要性

- 网络稳定性:由于DeepSeek服务器可能面临网络波动或大规模攻击,导致访问不稳定。本地部署可以避免这一问题,确保模型随时可用。

- 数据隐私保护:对于涉及敏感数据的任务,用户可能不希望将数据上传到云端处理。本地部署可以将所有数据保存在本地电脑上,提高数据安全性。

- 资源利用:本地部署可以充分利用本地硬件资源,如GPU等,提高模型推理速度

**DeepSeek**本地化部署实现数据的安全,保护了数据的隐私性和实现了数据的离线可用。

2.Ollama本地化部署DeepSeek流程

2.1下载Ollama

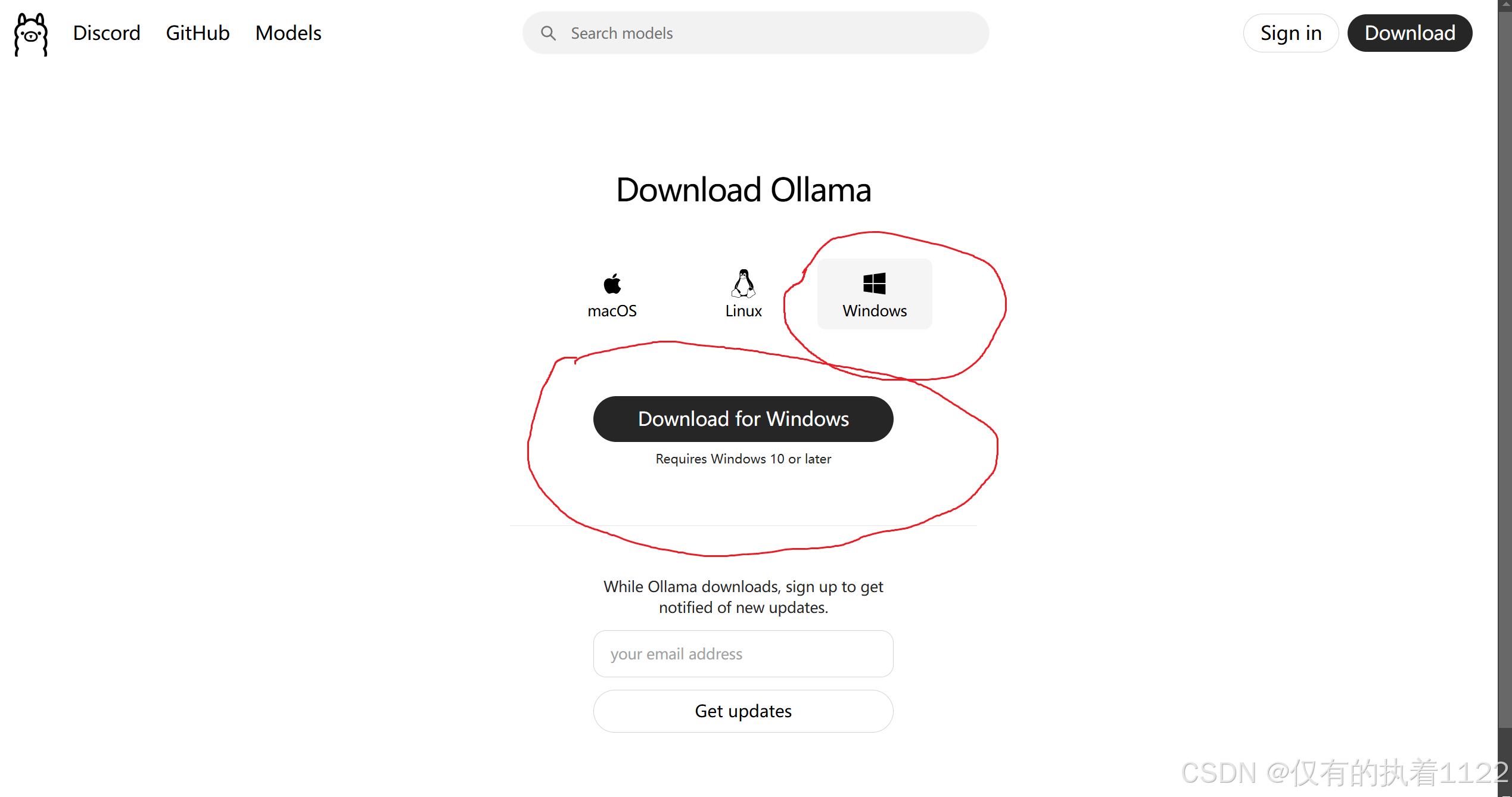

进入Ollama官网 下载,根据自己的系统下载即可,我这里选择windows版本

这里下载需要用到科学上网才行。

2.2安装Ollama

下载好的exe文件直接安装即可(ps 默认安装路径会直接安装到c盘,不想装在c盘的同学安装前可以自行查找相关方法教程)

2.3验证是否安装成功

通过cmd命令进入windows命令行出现以下的版本号代表安装成功

#输入以下命令

ollama -v

ollama version is 0.5.12

#输入ollama可以列出ollama的险关所有命令

ollama

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.

2.4安装deepseek-r1模型

这里根据自己电脑配置选择自己合适的模型这里给一个大致的参考

| CPU | 内存 | 硬盘 | 显卡 | |

|---|---|---|---|---|

| DeepSeek-R1-1.5B | 最低4核,推荐Intel/AMD多核处理器 | 8GB+ | (模型文件约1.5~2GB) | 非必需(纯CPU推理),若需GPU加速可选4GB+显存(如GTX 1650) |

| DeepSeek-R1-7B & DeepSeek-R1-8B | 8核+ | 16GB+ | (模型文件约4~5GB) | 推荐8GB+显存(如RTX 3070/4060) |

| DeepSeek-R1-14B | 12核+ | 32GB+ | 60GB+ | 推荐16GB+显存(如RTX 4080),部分来源提及12GB+显存(如RTX 4070)也可满足。 |

| DeepSeek-R1-32B | 16核+ | 32GB+ | 60GB+ | 推荐24GB+显存,如RTX 4090或A5000)部分来源提及12GB+显存(如RTX 4070)也可满足。 |

这里复制这里红圈部分

#cmd命令行里直接复制运行模型就开始下载了

ollama run deepseek-r1

#下载完成后执行以下命令出现下列模型代表成功

ollama list

NAME ID SIZE MODIFIED

shaw/dmeta-embedding-zh:latest 55960d8a3a42 408 MB 12 hours ago

deepseek-r1:1.5b a42b25d8c10a 1.1 GB 12 hours ago

#这里我们尝试运行以下下载好的模型执行 ollama run deepseek-r1:1.5b(ps刚才下载好的模型名称)

ollama run deepseek-r1:1.5b

>>> deepseek是什么

<think>

</think>

深度求索人工智能基础技术研究有限公司(简称“深度求索”或“DeepSeek”),成立于2023年,是一家专注于实现AGI的中国公司。

2.5安装词嵌入模型dmeta-embedding(用来做本地知识库)

#这里安装词嵌入模型

ollama run shaw/dmeta-embedding-zh:latest

3.LM Studio本地化部署DeepSeek流程

3.1下载LM Studio

3.2安装LM Studio

安装好之后打开就是这样

3.3下载deepseek模型

下载deepseek模型推荐HF-Mirror下载

这里选择GGUF后缀的格式的deepseek模型

选择合适自己电脑配置的模型(ps 这里下载时建议复制下载链接去迅雷里下载速度快而且稳定)

3.4deepseek模型载入

下载好之后这里找到模型文件地址把下载好的模型文件复制进去(ps 找到存放模型路径后要再新建一个文件夹名字和模型名字一致即可再把下载好的模型放进这个文件夹里才能识别)

按照下图载入模型就可以与它对话了

4.Cherry Studio 软件结合Ollama或LM Studio完成本地私有知识库的的搭建

4.1Cherry Studio 软件介绍

CherryStudio 是一款集多模型对话、知识库管理、AI 绘画、翻译等功能于一体的全能 AI 助手平台。 CherryStudio的高度自定义的设计、强大的扩展能力和友好的用户体验,使其成为专业用户和 AI 爱好者的理想选择。无论是零基础用户还是开发者,都能在 CherryStudio 中找到适合自己的AI功能,提升工作效率和创造力。

4.2Cherry Studio下载

这里按照自己的系统版本要求下载即可

4.3ollama方式构建本地知识库

安装完成后打开软件

打开管理界面如下,会带出你本地安装的deepseek模型和dmeta词嵌入模型,点击右侧的加号进行添加。

模型添加成功后按照下图操作导入刚才添加的模型

到这一步就完成了ollama模型引入,我们可以直接在操作栏页面问它相关的问题了。

新建一个知识库并添加ollama下载好的词嵌入模型

上传本地的相关文件到知识库中

配置自己的本地知识库。

4.4lm studio方式构建本地知识库

手动开启lm studio 局域网服务

剩下步骤参考4.3即可

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)