手把手教你在本地配置Deepseek模型:从零开始超详细

详细介绍了如何在本地部署Deepseek-R1模型,基于Ollama框架完成从安装到配置的全过程。内容包括Ollama的安装与验证、Deepseek-R1模型的下载与本地部署、以及如何使用Chatbox AI进行图形化交互。通过本教程,读者可以轻松在本地环境中运行Deepseek-R1,享受智能助手带来的高效AI交互体验。

引言

最近,Deepseek-R1作为一款强大的智能助手模型,受到了广泛关注。网页端的使用极其方便,但是也面临卡顿问题。此时有些单位或者个人就想着把Deepseek模型部署于本地,本文将详细介绍如何在本地部署Deepseek-R1模型,基于Ollama框架完成从安装到配置的全过程。

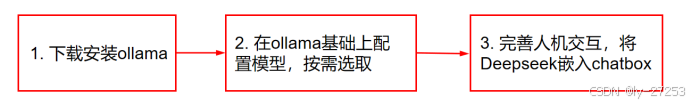

整体流程如图1所示

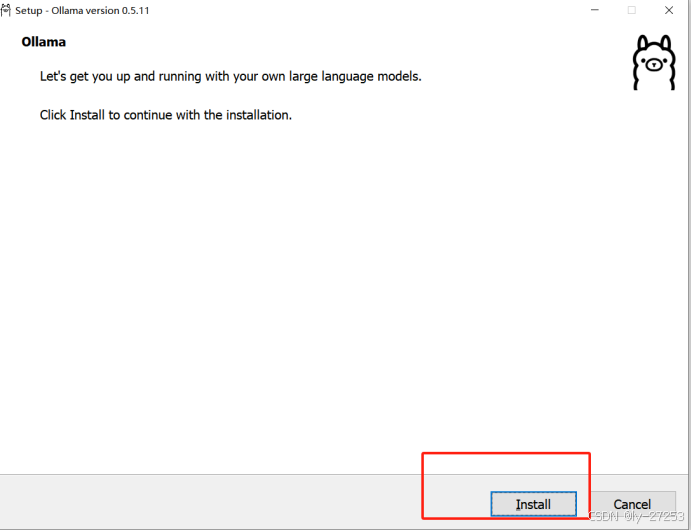

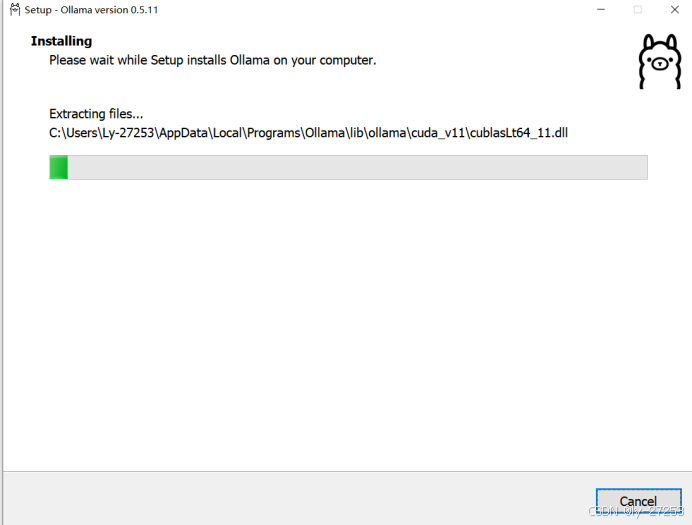

1. 安装Ollama

在本地运行Deepseek-R1之前,我们需要先安装Ollama。主要是因为Deepseek-r1依赖Ollama提供的运行环境或框架。Ollama可能负责管理模型、处理依赖或提供必要的计算资源,确保Deepseek-r1能够正常运行。

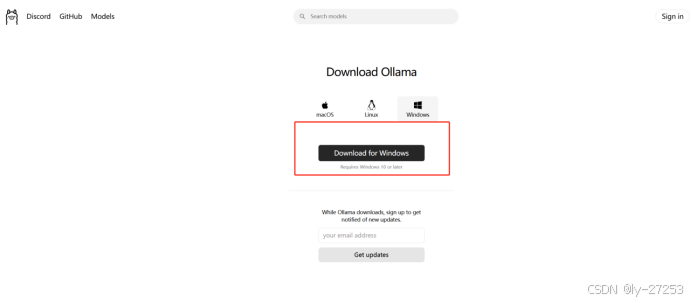

1.1 下载Ollama

访问Ollama的官方网站下载页面,选择适合你操作系统的安装包:

1.2 检查Ollama是否安装成功

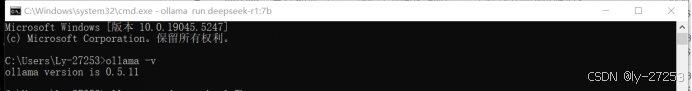

安装完成后,按下键盘上的 Win + R 键,输入 cmd 打开命令提示符窗口,然后输入以下命令:

ollama -v

如果安装成功,命令行会返回Ollama的版本号信息。如下图:

ollama version 1.0.0

2. 在本地部署Deepseek-R1模型

安装好Ollama后,接下来我们需要下载并配置Deepseek-R1模型,完成本地部署。

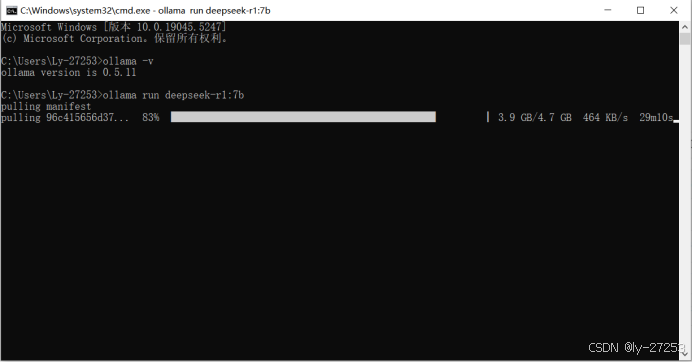

2.1 下载Deepseek-R1模型

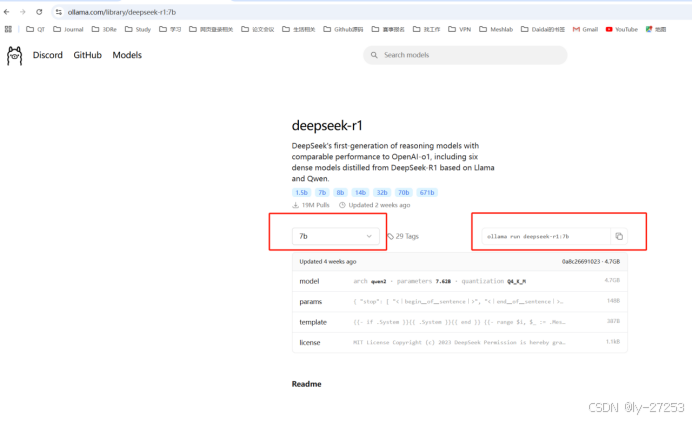

访问Ollama的模型库页面,找到Deepseek-R1模型:

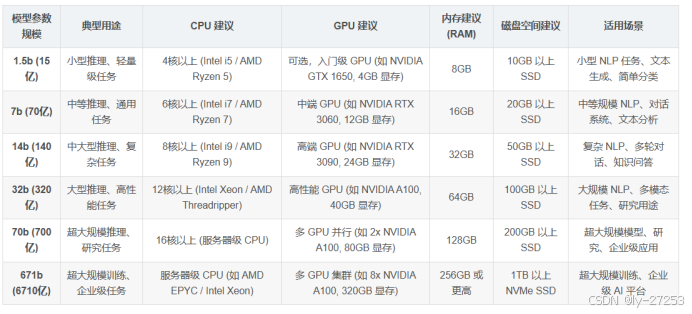

根据你的本地硬件配置选择合适的模型参数。例如,如果你的显卡型号为3060,可以选择以下命令进行下载:

ollama run deepseek-r1:7b

复制上述命令,然后回到命令提示符窗口,粘贴并执行该命令。等待下载进度条完成。

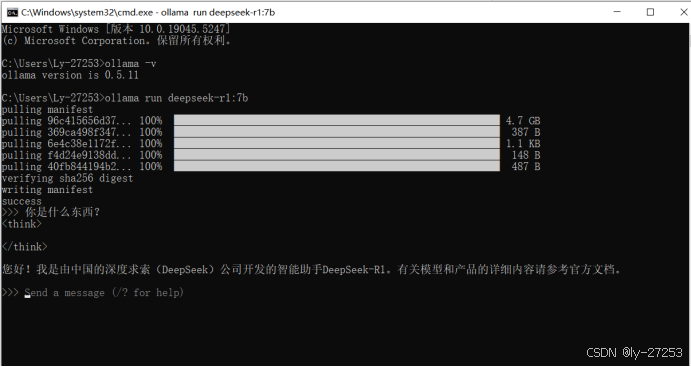

2.2 验证本地部署

下载完成后,你可以在终端中与Deepseek-R1进行简单的对话,验证模型是否成功部署。例如:

我问:“你是什么东西?”

它回复:“您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。有关模型和产品的详细内容请参考官方文档。”

如果能够正常对话,如上图所示,说明Deepseek-R1已经成功部署到本地!

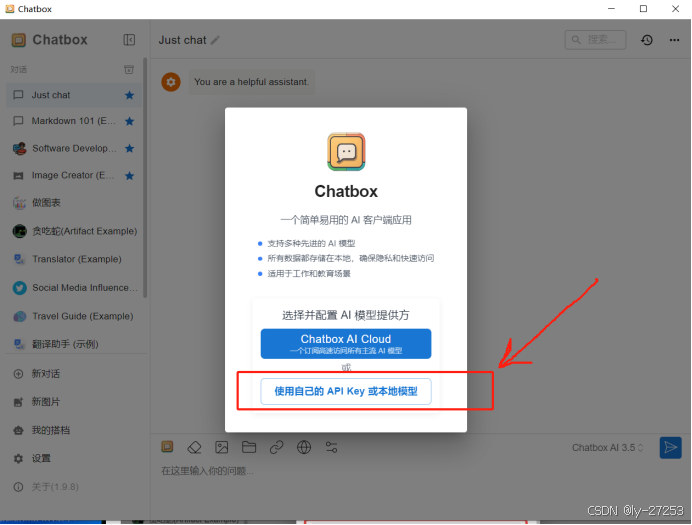

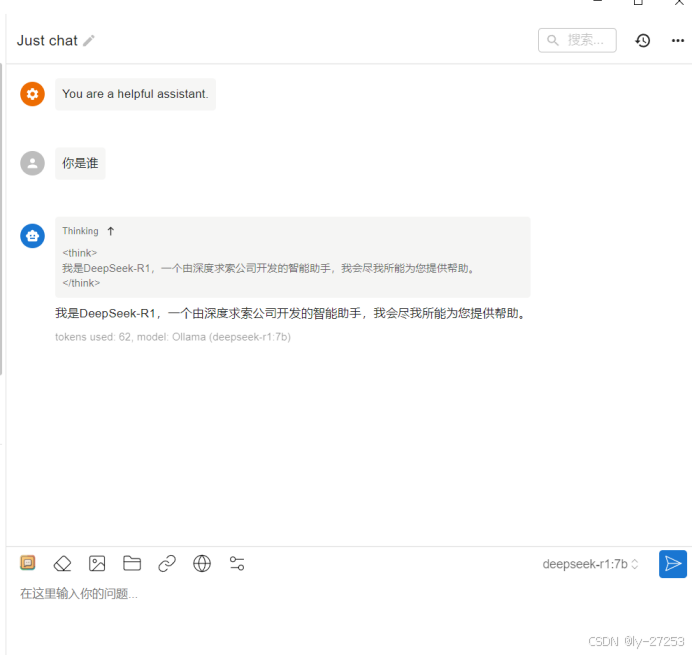

3. 下载人机交互界面(可选)

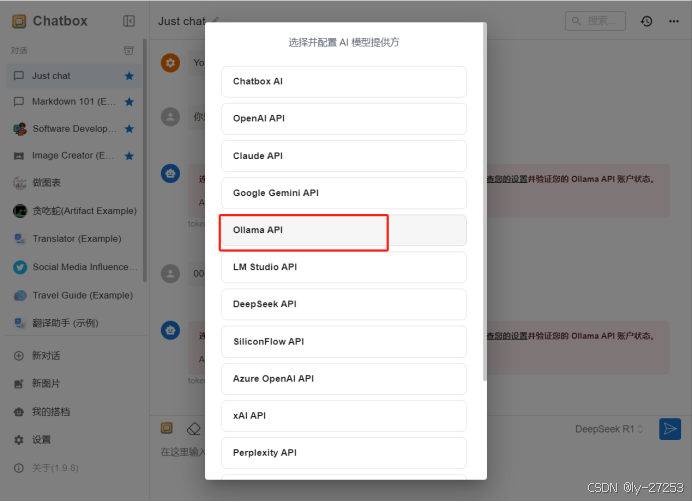

为了更方便地与本地部署的Deepseek-R1进行交互,你可以下载一个图形化的人机交互界面。推荐使用 Chatbox AI,它支持本地模型调用,操作简单易用。

安装完成后,打开Chatbox AI,选择本地部署的Deepseek-R1模型,即可开始愉快的聊天体验!

4. 开始使用

完成以上步骤后,你就可以在本地环境中通过命令行或图形界面与Deepseek-R1进行交互了。无论是日常聊天、知识问答,还是代码调试,Deepseek-R1都能为你提供强大的支持!

总结

本教程详细介绍了如何在本地部署Deepseek-R1模型,基于Ollama框架完成从安装到配置的全过程。通过本教程,可以轻松流畅地在本地使用Deepseek-R1,不会产生卡顿!但需要注意的是,由于私人电脑硬件资源有限,大家很能在自己电脑实现“满血版的Deepseek”。参数较少的模型,生成的答案或者回复可能不那么尽人意!

标签:

#Ollama #Deepseek-R1 #本地部署 #AI助手 #模型配置 #Chatbox AI #人工智能教程

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)