DeepSeek完整版本地部署最简教程来了,全程0代码

全程0代码本地部署大型模型,傻瓜式操作

DeepSeek彻底出圈了,火到了大江南北,火到人尽皆知。虽然在线已经足够好用,但把模型部署到本地,才能真正实现独家定制,避免DeepSeek服务器繁忙的问题,让 DeepSeek R1 的深度思考成为你的专属服务。

关于本地部署DeepSeek,我们选择的是Ollama。

Ollama是一个基于 Go 语言开发的开源框架,它允许用户在本地启动并运行大型语言模型。它提供了一个简单易用的内容生成接口,但无需开发经验即可直接与模型进行交互。

为什么选择Ollama而不是其他的框架,比如LM Studio?那是因为Ollama的可扩展性强,虽然初期配置复杂,但我们可以通过工具来把初期的配置简单化。

ServBay让Ollama初期配置简单化。

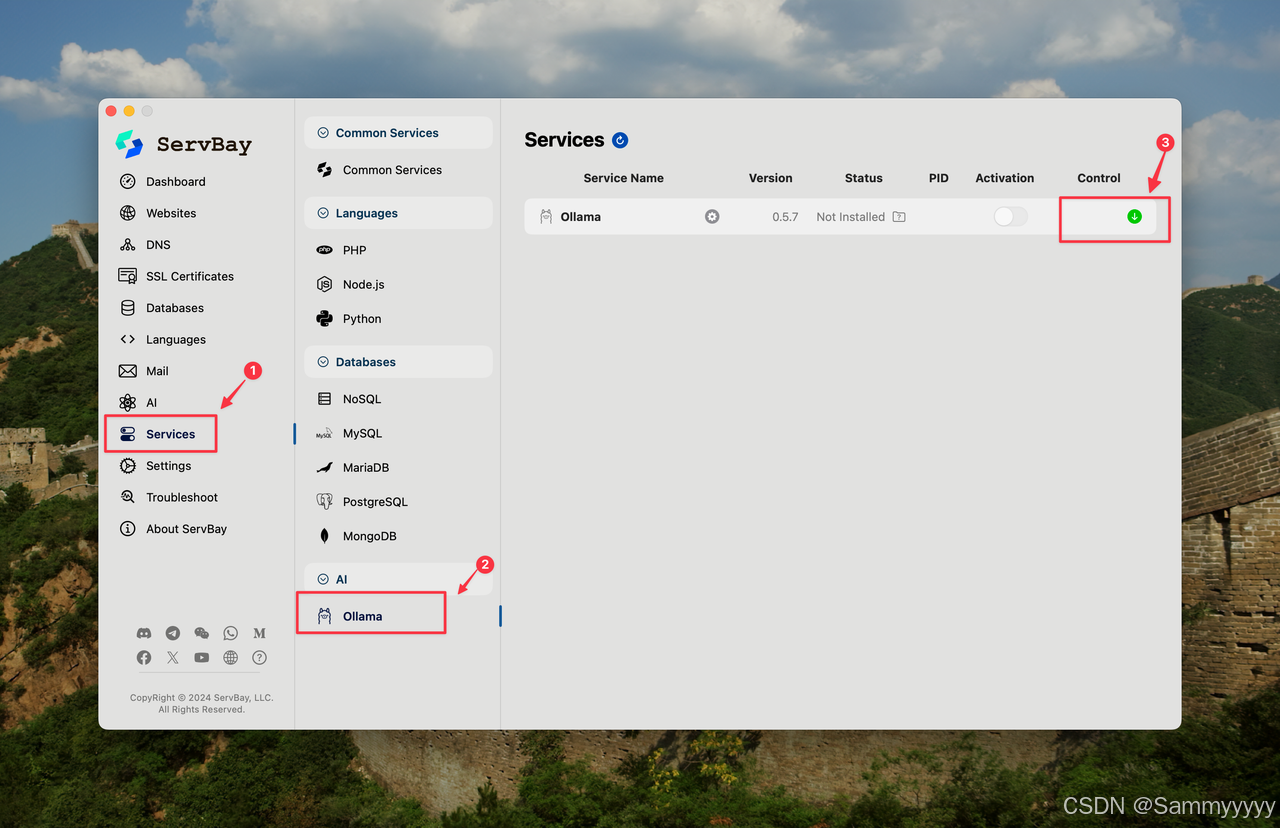

用ServBay安装Ollama

首先我们下载ServBay并根据软件提示安装好之后,到左边的菜单中选择服务,下方的AI -- Ollama,然后点击绿色的下载按钮即可下载。

ServBay下载地址https://www.servbay.com

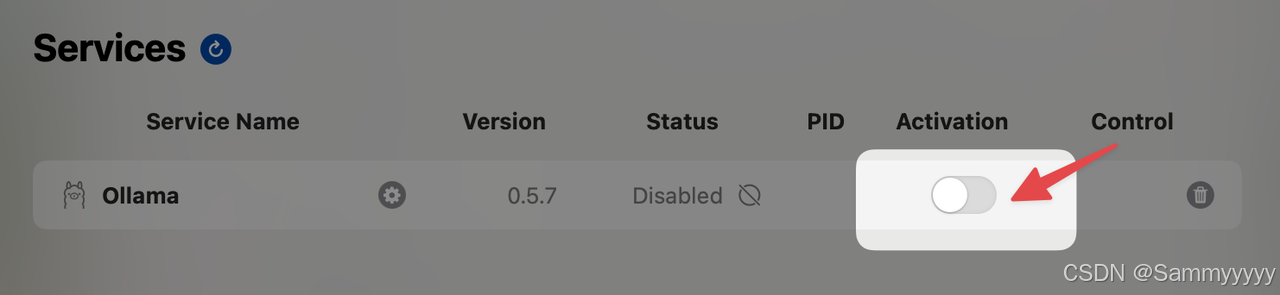

只需要注意的是,下载完成后需要点击激活按钮启动Ollama。

安装模型

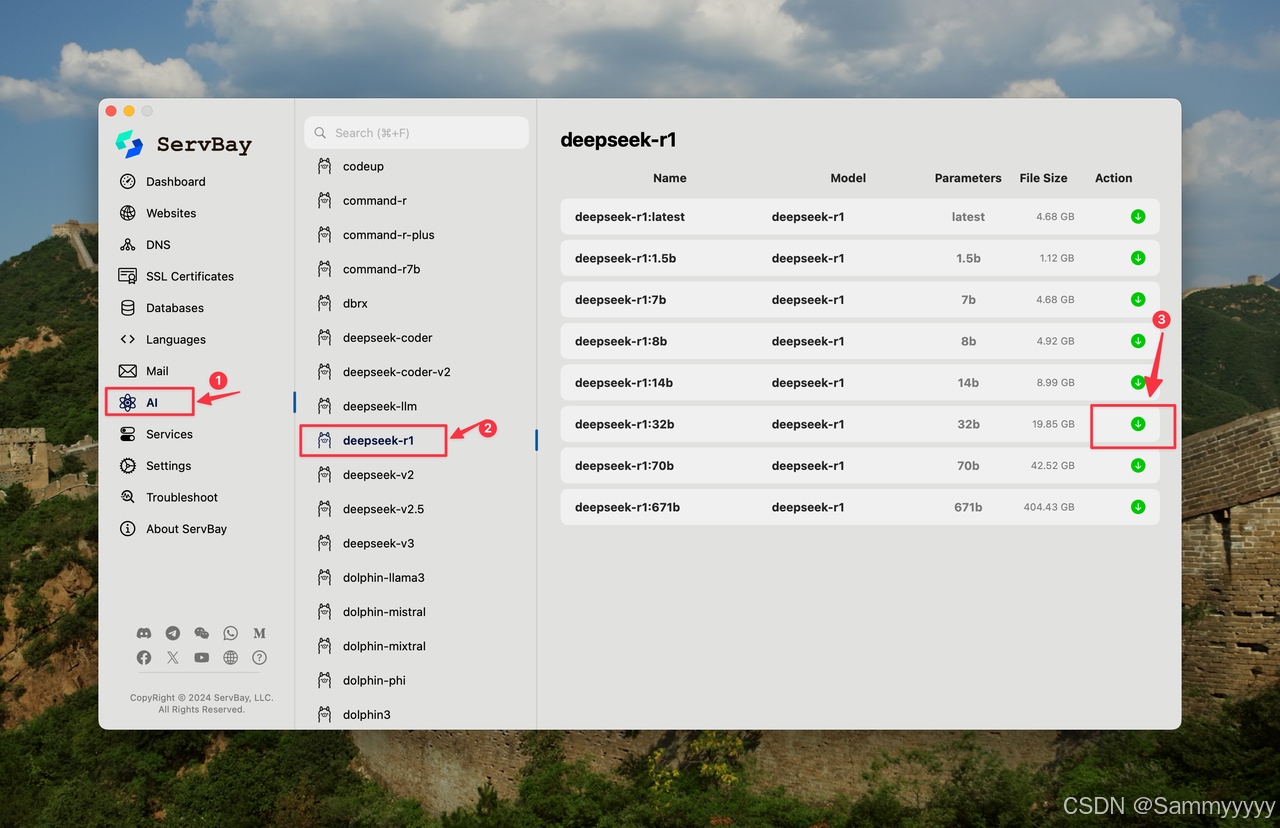

接着到左边的菜单栏,点击AI,在中间的模型中找到deepseek-r1,选择需要的模型大小,点击绿色按钮下载即可

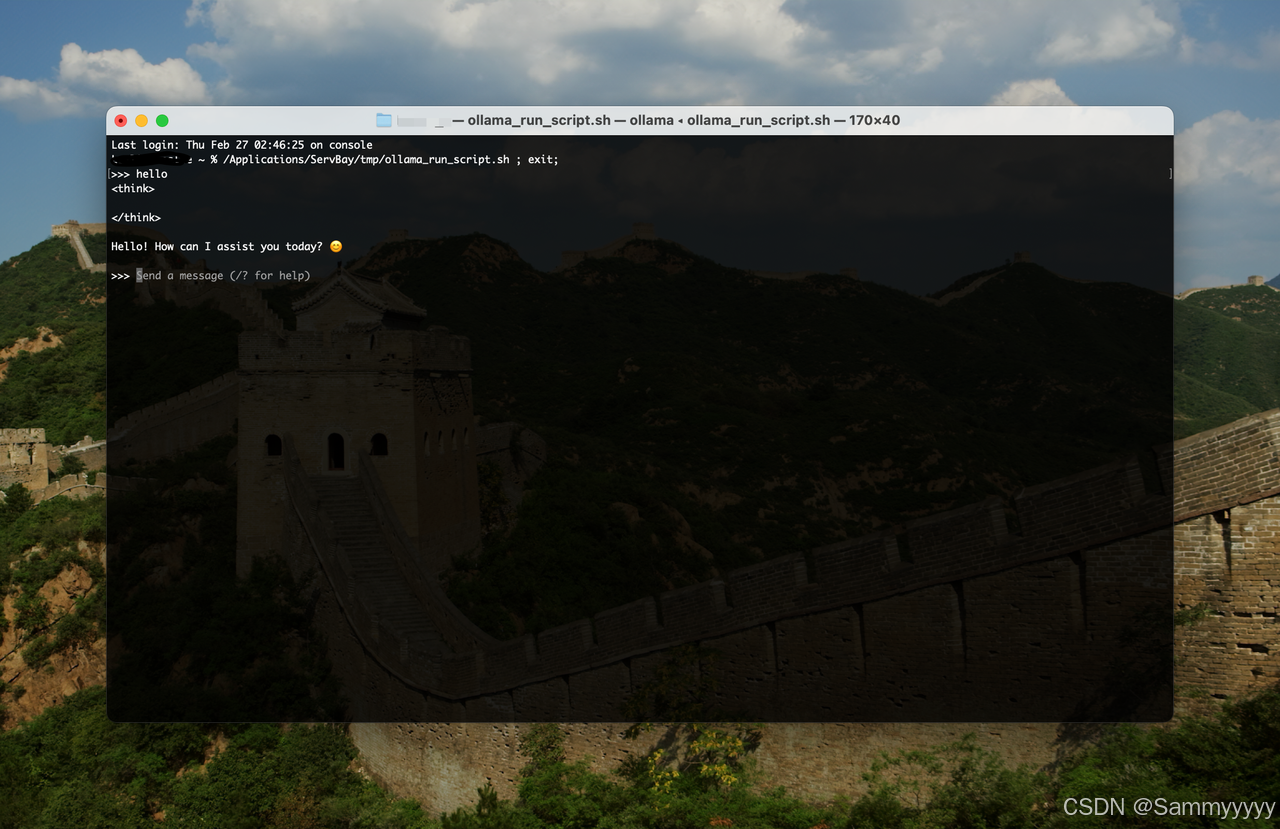

下载完成后,对话需要通过终端进行操作,这使用起来比较不方便。

那么我们就需要采用GUI方式调用Ollama API,并实现完整的GUI对话功能,而我选择的是Chatbox。

配置Chatbox

Chatbox是人工智能客户端应用,类似于一个智能的“聊天窗口”,能够连接多种语言模型。

下载并安装好Chatbox之后,就可以开始配置。

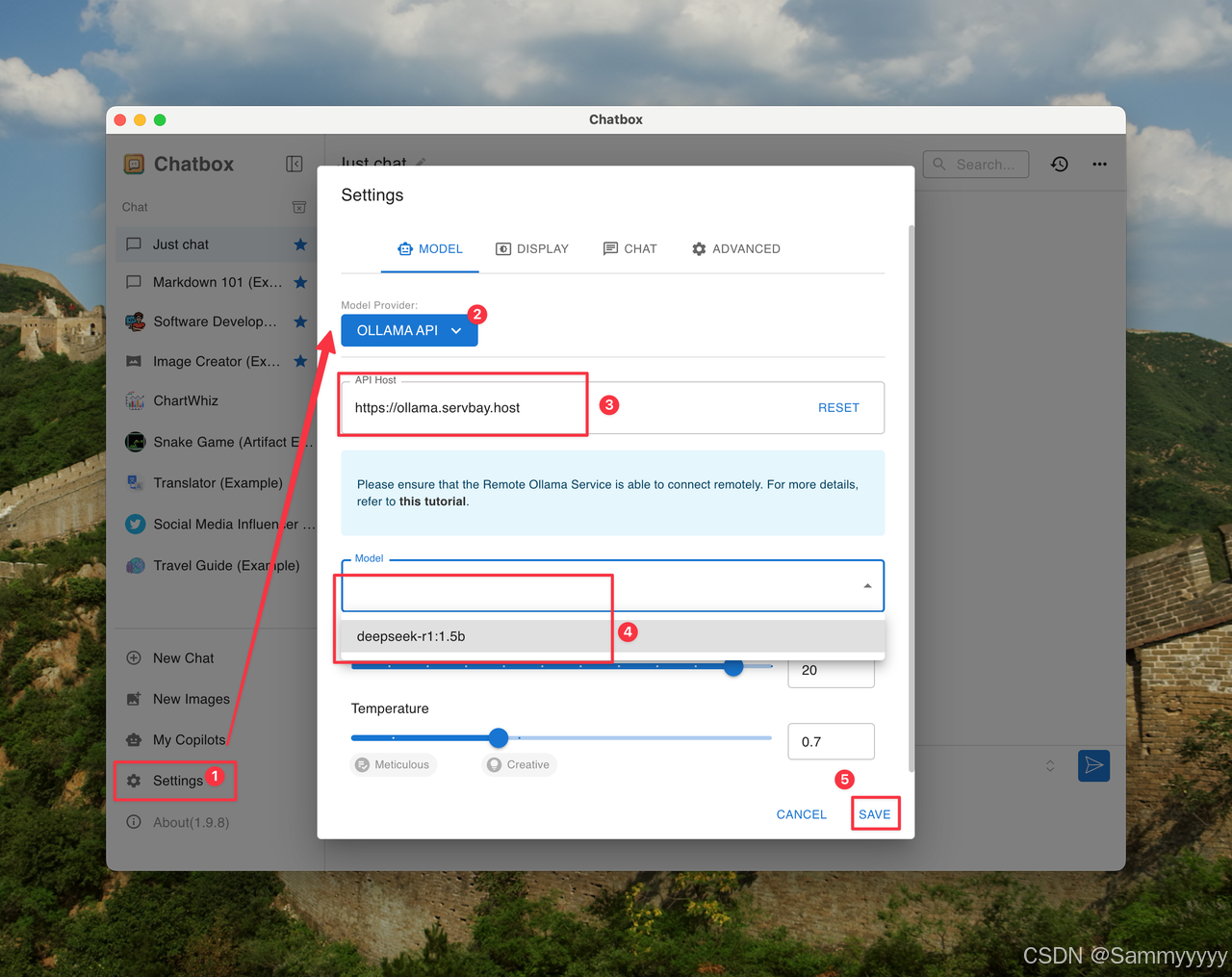

打开ChatBox,选择模型提供方OLLAMA API,API host输入 https://ollama.servbay.host

选择对应的模型deepseek-r1,保存。

Chatbox下载地址https://chatboxai.app

之后,我们就可以使用GUI来进行对话了。

写在最后

无论是Ollama,还是ServBay,作为一种工具,如果能够合理有效地运用,都能对我们的工作和学习产生极大的帮助。它们不仅能够提升工作效率,减少重复性劳动,还能够帮助我们更好地解决问题。特别是在快速变化的时代,掌握和利用这些工具,不仅能让我们在专业领域中保持竞争力,也能为个人成长和知识积累提供强有力的支持。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)