Deepseek的windows本地部署超级无敌宇宙简单详细小白入门版本【Ollama】

本文介绍怎么用Ollama来在Windows10+系统上本地部署deepseek模型,属于基础 | 简单 | 练手の娱乐 | 学习性质内容。

目录

本文介绍怎么用Ollama来本地部署deepseek模型,属于基础 | 简单 | 练手の内容。

1 下载Ollama

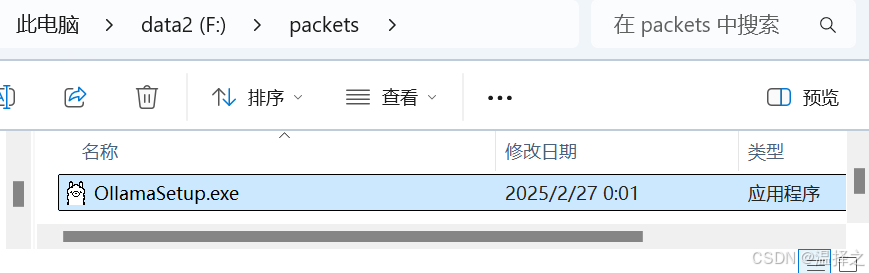

Ollama官网:Ollama官网网址

进入上述官网地址后,下面红框即可下载Ollama的安装包OllamaSetup,注意下面的小字有提示要求win10版本及其以上;可能需要挂梯子才能下载哦。

2 安装Ollama

Ollama安装包安装Ollama的话无法修改安装路径,是默认安装到C盘的,这里为了避免对C盘的占用,采用命令行的安装方法自定义安装地址;同样,利用Ollama下载deepseek模型也是会默认把模型下载在C盘,我们将把这两个下载地址都修改到自定义位置。

2.1 安装Ollama

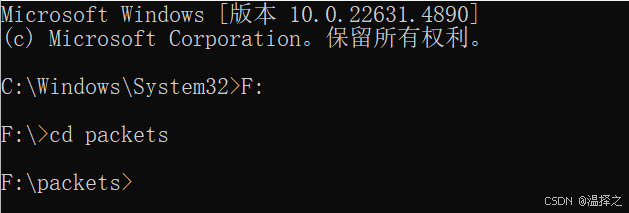

首先用管理员权限打开cmd;

进入OllamaSetup安装包的地址。【也就是上面下载的那个】

然后运行这个命令行指定安装Ollama的地址:

OllamaSetup.exe /DIR="F:\tools\Ollama"运行上述命令后会弹出安装界面,直接点击install后等待即可。

安装完成后,Ollama默认为打开状态,此时我们先在任务栏右键Ollama图标,退出Ollama。【注:似乎开机的时候Ollama也会自动启动,可能需要手动关闭一下】

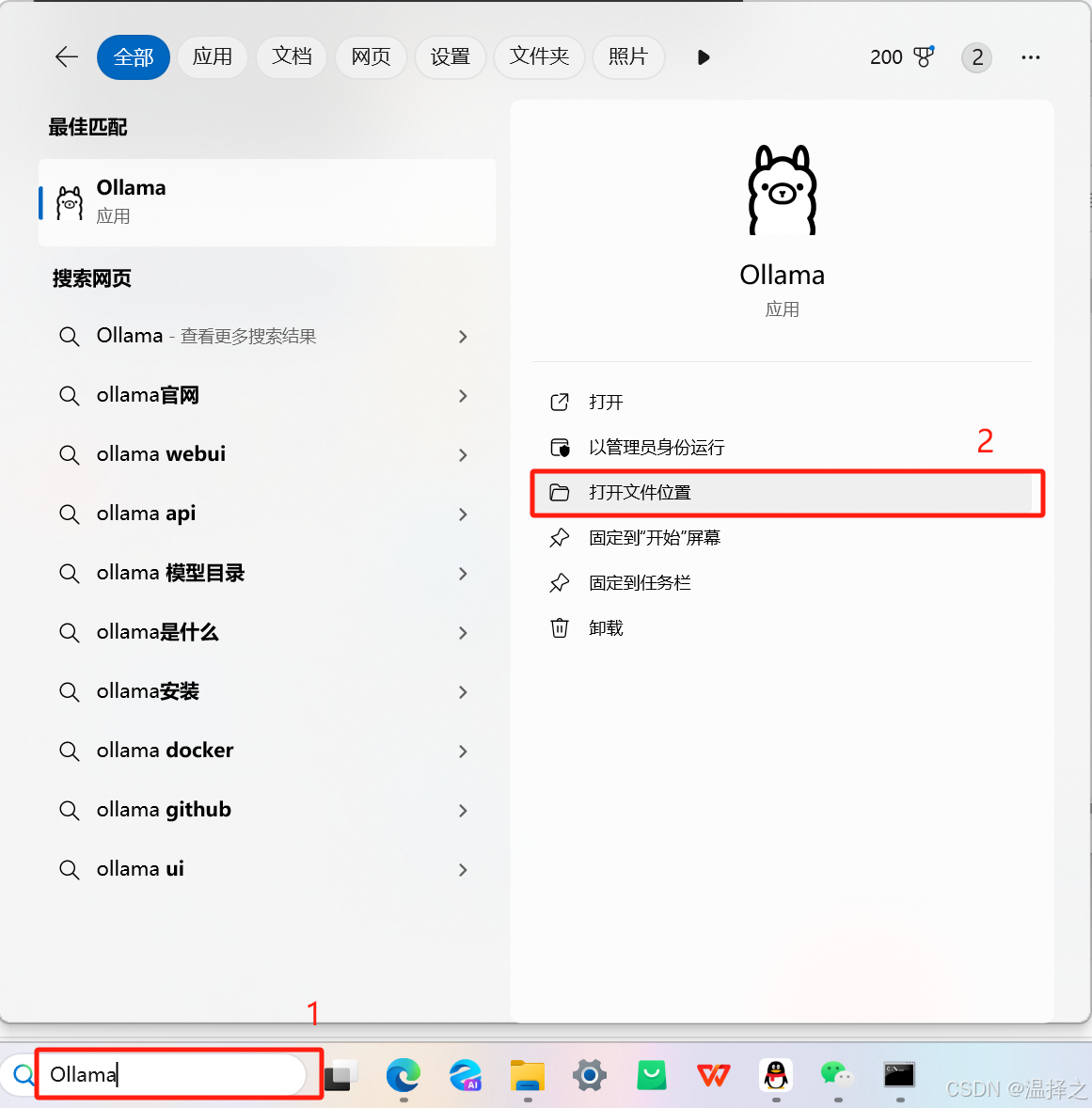

(可选)Ollama安装后在桌面没有快捷方式,虽然Ollama快捷方式也没什么用,但如果想要的话,可以在电脑搜索Ollama -> 打开到文件位置 -> 把快捷方式移动到自己想要的地方。

2.2 更改模型储存位置

打开环境变量

然后添加一个Ollama的模型下载的路径到用户变量里面。具体如下图:首先点环境变量,打开环境变量面板,然后在用户变量那里点击“新建”,创建一个变量。变量名就用OLLAMA_MODLES,变量值输入你希望将模型下载到的路径,例如图片里F:\tools\Ollama是我的Ollama安装路径,而Models是我在Ollama的文件夹中新建了一个文件夹Models,我希望我的模型下载到这里。然后按顺序一路确定退出即可。

2.3 验证Ollama

打开一个新的cmd,输入命令行:Ollama -v

如果此时ollama没有运行的话,会是如下,也是正确的,不用担心。

3 安装Deepseek模型

3.1 选择Deepseek版本

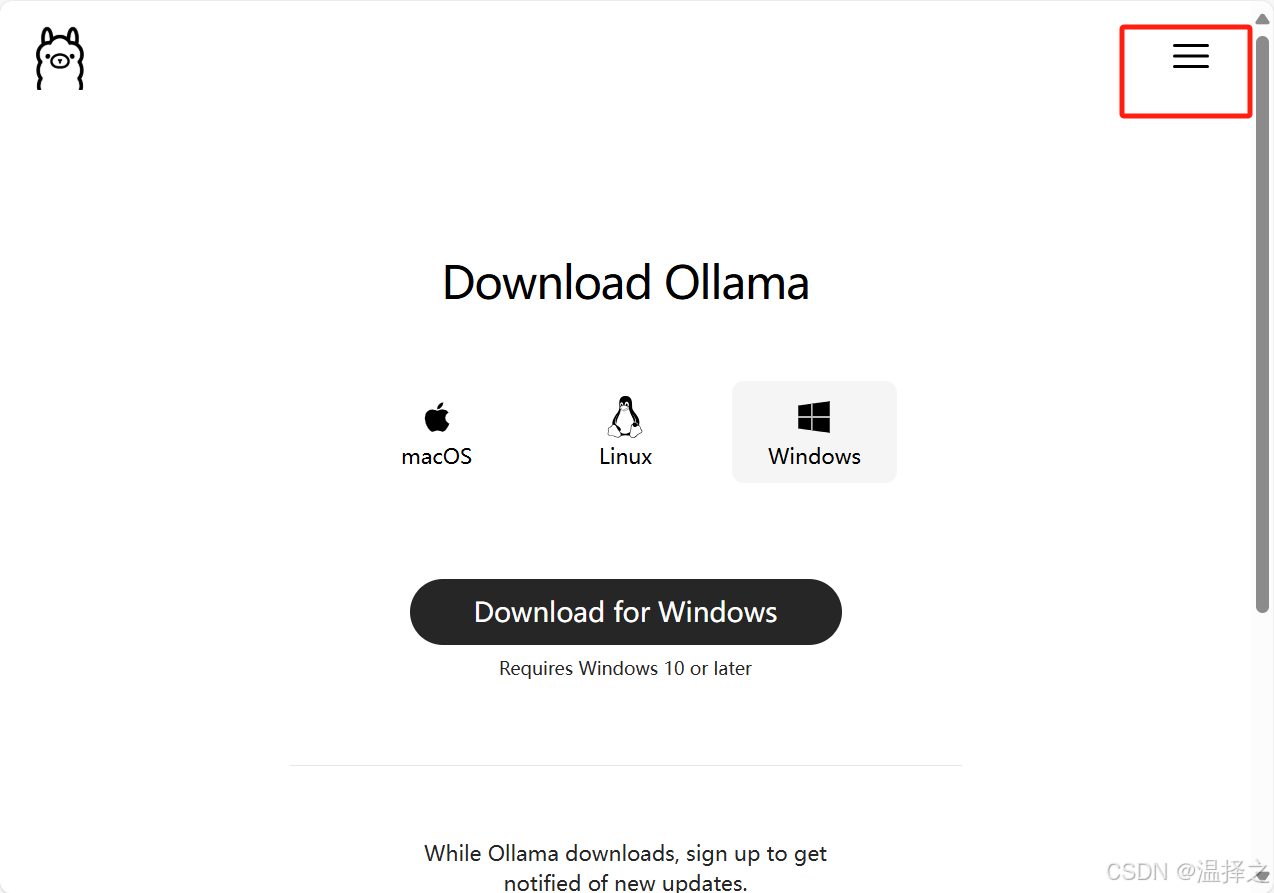

打开Ollama官网Ollama官网网址,然后点击Models。(如果没有全屏看不到Models,建议全屏或者从右上角菜单进入)。

然后就会看到很多模型,第一个就是deepseek-r1,点击进入(万一不是的话搜索应该就能找到)

进去以后,点击下拉框我们可以看到deepssek模型的各个版本,越往下对电脑的配置要求越高,需要根据自己的电脑配置选择合适的版本。

硬件要求参考如下,此处借鉴博客一文读懂DeepSeek-R1本地部署配置要求(建议收藏)_deepsee-r1 部署要求-CSDN博客。

这里只列出前几个模型,本地部署基本到14b就到头了,后面的要求太高应该用不到。主要考虑显卡即可,游戏本应该弄个7b不成问题,而且7b功能较完善一点,可以浅浅把玩;1.5b的小废物属实一点用都没有。

| 版本 | CPU | 内存 | 显卡 | 场景 |

| DeepSeek-R1-1.5b | 最低 4 核(推荐 Intel/AMD 多核处理器) | 8GB+ | 非必需(纯 CPU 推理),可选 4GB+ 显存(如 GTX 1650) | 聊天机器人,简单问答【基本没啥用,甚至没有深度思索】 |

| DeepSeek-R1-7b | 8 核以上(推荐现代多核 CPU) | 16GB+ | 8GB+ 显存(如 RTX 3070/4060)【本人RTX3060可,下载慢点】 |

中等复杂NLP任务(摘要、翻译等);轻量级多轮对话系统;【这个就有深度思索了】 |

| DeepSeek-R1-8b | 基本同上 | 基本同上 | 基本同上 | 更高精度的轻量级任务【这个没试了】 |

| DeepSeek-R1-14b | 12 核以上 | 15GB+ | 16GB+ 显存(如 RTX 4090 或 A5000) | 长文本理解生成 |

【可选】不知道怎么查显卡的朋友看这里,简要说明一下。进入我的电脑/此电脑后,右键空白位置,进入属性,高级系统设置 -> 硬件 -> 设备管理器 -> 显示适配器,4位置的那个就是我的显卡配置。

如果不是RTX,想通过显存来查自己适合哪个版本,可以打开cmd,输入下列代码行。可以看到我的这里有一个6144MiB,这是我的显存大小,1024MiB=1GB,所以我的其实是6GB左右。

nvidia-smi | findStr "MiB"3.2 安装Deepseek

下拉框那儿选中自己要的版本,然后复制右边的命令行,新开一个cmd,运行这行代码等待安装完成即可。 然后就会开始下载:

然后就会开始下载:

下载结束后再运行这个命令行,就会进入和deepssek的对话:

【小注】此处本人出现过不思考(<think>部分没有内容)、模型只会回答“您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。关于模型和产品的具体信息,请参见官方发布的内容如还有其他问题,欢迎继续提问!"这样的神奇问题,简单粗暴的解决方式是:重开模型!!

3.3 命令行使用指南

退出模型:/bye

查看Ollama管理的模型:ollama list

运行模型:ollama run <模型名>

查看其他ollama命令:ollama -h

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)