锡产感知带你在CentOS7系统部署DeepSeek

锡产感知带你在Windows10系统部署DeepSeek-CSDN博客

锡产感知带你使用Python部署DeepSeek-CSDN博客

当下Deepseek非常火,本文将带大家在自己的服务器(Linux)搭建deepseek使用。

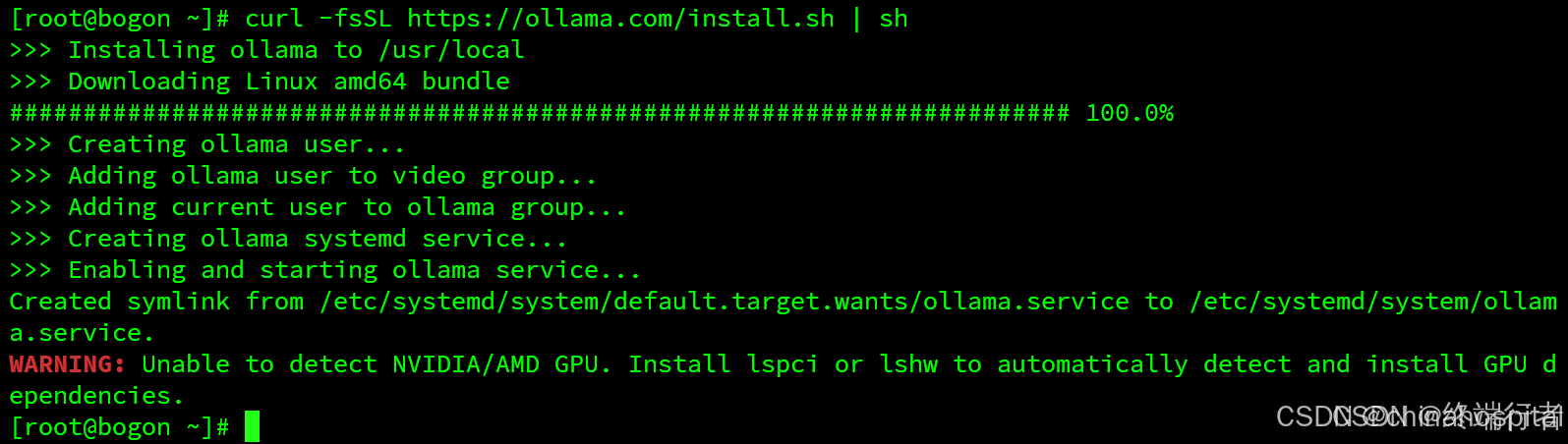

第一步:下载安装Ollama

[root@bogon ~]# curl -fsSL https://ollama.com/install.sh | sh

在Service中增加下面两行

[root@bogon ~]# vim /etc/systemd/system/ollama.service

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

然后重启ollama服务

[root@bogon ~]# systemctl daemon-reload

[root@bogon ~]# systemctl restart ollama

[root@bogon ~]# netstat -lntp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 1082/sshd

tcp 0 0 127.0.0.1:25 0.0.0.0:* LISTEN 1259/master

tcp6 0 0 :::11434 :::* LISTEN 9101/ollama

tcp6 0 0 :::22 :::* LISTEN 1082/sshd

tcp6 0 0 ::1:25 :::* LISTEN 1259/master

11434为ollama的端口

测试访问

第二步:部署Deepseek R1模型

还是在ollama官网上,点击Models,选择deepseek-r1,不同版本对应的体积大小不同,体积越大模型越精细化,只需要复制命令即可,我这里选择8b。

[root@bogon ~]# ollama run deepseek-r1:8b

注:这里等待的时间比较长,需要多等一会,一直到最后出现success为止。

成功之后可以在cli命令行模式下进行简单的聊天

[root@bogon ~]# ollama run deepseek-r1:8b

>>> 你好

<think>

</think>

你好!很高兴见到你,有什么我可以帮忙的吗?

ctrl+d 退出聊天

第三步 安装open-webui 界面化访问

安装docker

[root@bogon ~]# yum install -y yum-utils device-mapper-persistent-data lvm2

[root@bogon~]# yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

[root@bogon ~]# yum install -y docker-ce

[root@bogon ~]# systemctl start docker && systemctl enable docker

运行open-webui容器,有些网站使用的是ghcr.io服务器导致下载速度很慢,这里已经替换

[root@bogon ~]# docker run -d -p 8081:8080 -e OLLAMA_BASE_URL=http://106.14.135.17:11434 -v /data/open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main

浏览器访问:

http://106.14.135.17:8081/auth

按提示创建管理员账号,创建完成之后需要多等待一会,弹出登陆页面。整个过程需要等待时间过长,有可能是因为博主的机器配置与网络有关

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)