如何在Windows上搭建Ollama+Ragflow+Deepseek-R1自定义知识库

在信息爆炸的时代,如何有效地管理和利用海量的数据,成为了企业和开发者面临的一大挑战。幸运的是,随着AI技术的不断进步,我们可以通过构建智能知识库来帮助解决这一问题。本文将带你一步步了解如何在Windows环境下,使用和搭建自己的自定义知识库。

在信息爆炸的时代,如何有效地管理和利用海量的数据,成为了企业和开发者面临的一大挑战。幸运的是,随着AI技术的不断进步,我们可以通过构建智能知识库来帮助解决这一问题。本文将带你一步步了解如何在Windows环境下,使用Ollama、Ragflow和Deepseek-R1搭建自己的自定义知识库。

一、 Ollama:强大的AI聊天平台

Ollama是一个开源的聊天AI平台,它可以帮助开发者将自定义知识库与自然语言处理模型结合,进行交互式查询。Ollama可以支持与多种数据源的集成,非常适合搭建智能知识库。

安装Ollama

1.访问Ollama官网,下载Windows版本的安装包。

下载后点击安装就可以了,但是Ollama的安装程序并没有提供设置安装路径的选项,默认安装路径在C:\Users\<用户名>\AppData\Local\Programs\Ollama, Ollama的程序大概会占4.5G的空间

2.指定ollama程序的安装位置

如果需要指定Ollama安装到其它的位置,参考下面的步骤:先找到

OllamaSetup.exe所在的目录下,然后通过命令

3.指定Ollama的大模型文件存储的位置

Ollama的默认数据存储位置在C:\Users\<用户名>\.ollama\models,而每个大模型的文件都是以G为单位的。如果需要改变大模型文件位置,参考如下操作。

退出Ollama,在Windows的右下角的Ollama图标上点击右键,选择"Quit Ollama"

4.更改大模型文件存放位置

配置环境变量 “变量名”输入“OLLAMA_MODELS”(注意要大写),“变量值”输入“<要保存大模型文件的位置>”(提前创建好相应目录),点击“确定”

5.验证是否成功,可以在“命令提示符”里执行“set”,可以在下面的变量列表里找到刚才的设置

然后重启下电脑

二、 Ragflow:自动化文档处理与知识库构建

Ragflow是一个强大的自动化文档处理工具,能够将各种文档(如PDF、Word、Excel等)转化为结构化的数据,进一步整理成可用于知识库的信息。它能够自动识别文档中的关键内容,创建有效的索引,并将信息结构化存储。

1.从https://github.com/infiniflow/ragflow 克隆仓库

$ git clone https://github.com/infiniflow/ragflow.git2.找到.env配置文件,将默认为 v0.16.0-slim 版本,即未嵌入模型的 RAGFlow Docker 镜像,改成嵌入模型镜像,具体如下操作方式

3.使用预先构建的 Docker 镜像启动服务器:

$ cd ragflow/docker

$ docker compose -f docker-compose.yml up -d 4.服务器启动并运行后检查服务器状态:

4.服务器启动并运行后检查服务器状态:

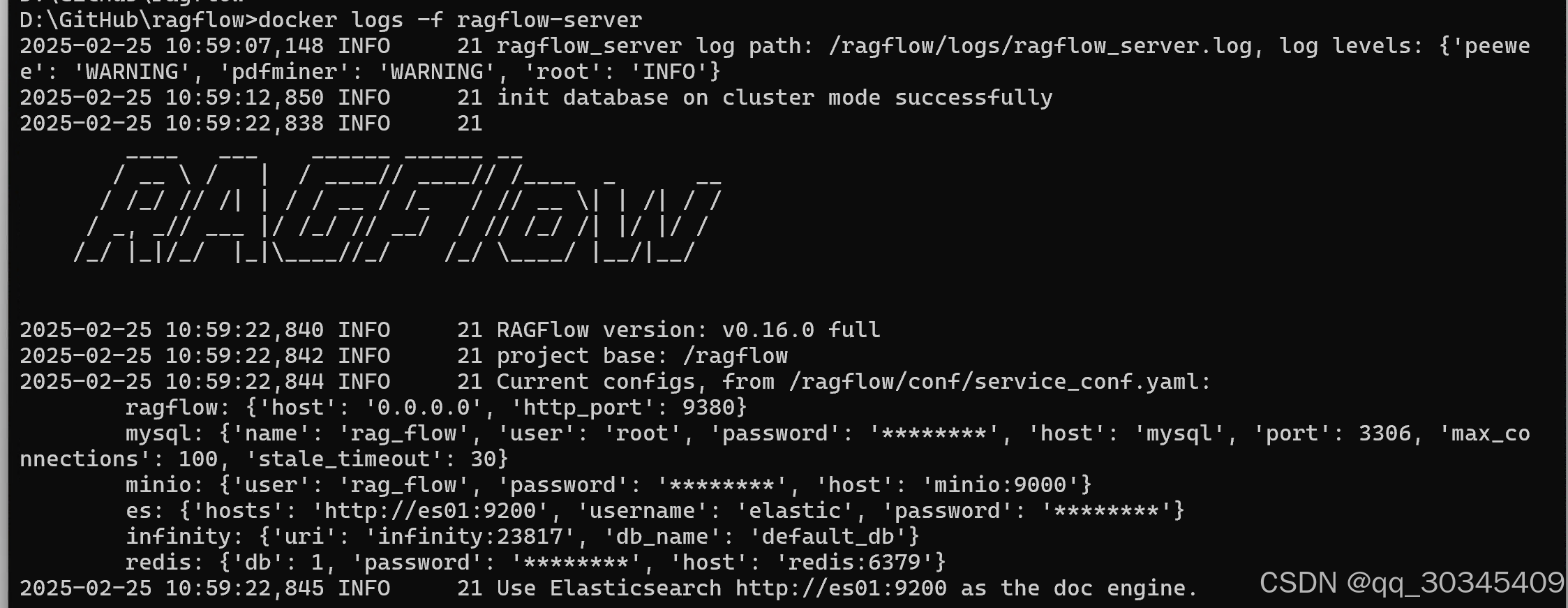

$ docker logs -f ragflow-server以下输出确认系统启动成功:

三、 Deepseek-R1:智能搜索与检索引擎

安装Deepseek-R1

ollama run deepseek-r1:8b 可以发一条消息来验收是否成功

可以发一条消息来验收是否成功

四、在RAGflow中构建个人知识库并实现基于个人知识库的对话问答

四、在RAGflow中构建个人知识库并实现基于个人知识库的对话问答

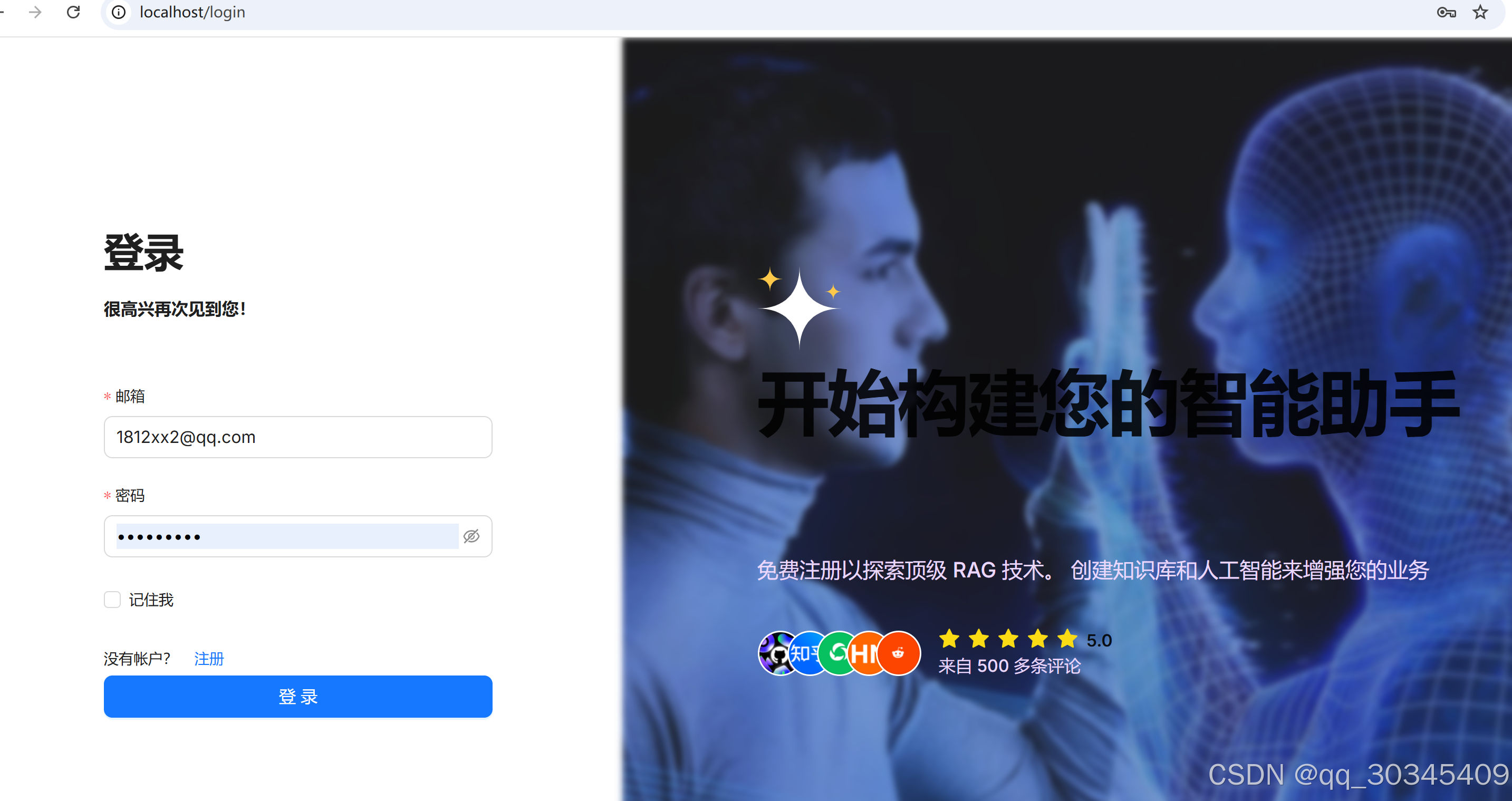

在浏览器中输入http://localhost

模型名称可以通过命令查看

模型名称可以通过命令查看

本地部署deepseek 成功

然后就可以在聊天中发消息进行测试了

然后就可以在聊天中发消息进行测试了

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)