DeepSeek开源周首日,45分钟狂揽400+ Star!

它通过优化推理过程中的KV Cache,让我们能够在更少的硬件设备上处理更长的上下文长度,大幅降低了推理成本。2月24日上午9点,DeepSeek开源了用于Hopper GPU的高效MLA解码核心FlashMLA,仅上线45分钟就收获400+ Star,火爆程度可见一斑。易安点评:在当前AI开源浪潮中,DeepSeek以实际行动展示了什么是真正的开放。通过开源核心技术,不仅能促进整个行业的发展,也

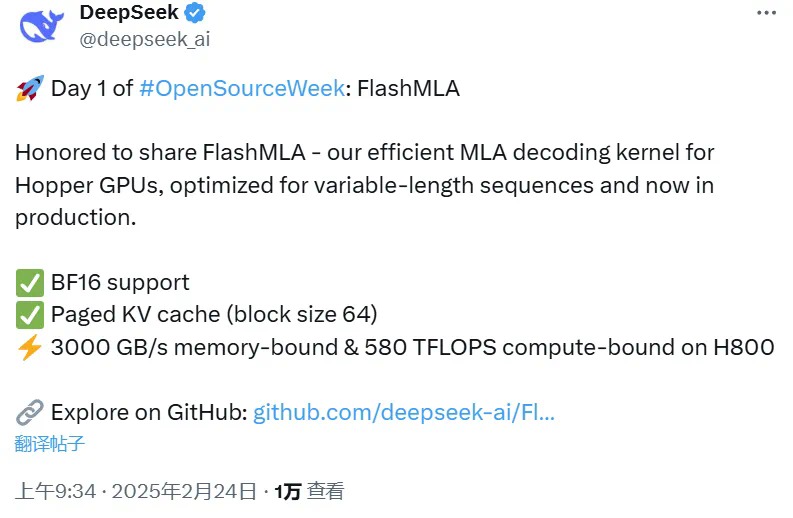

重磅!DeepSeek正式开启开源周,首日就放出大招,开源其核心推理加速技术FlashMLA。这是怎样一个重量级项目?让我们一探究竟。

开源周首日劲爆消息

DeepSeek在上周五预告本周将连续开源五个重磅项目,一开始就兑现承诺。2月24日上午9点,DeepSeek开源了用于Hopper GPU的高效MLA解码核心FlashMLA,仅上线45分钟就收获400+ Star,火爆程度可见一斑。

什么是FlashMLA?为什么它如此重要?

MLA(Multi-Level Attention)技术是DeepSeek大模型的关键创新点。它通过优化推理过程中的KV Cache,让我们能够在更少的硬件设备上处理更长的上下文长度,大幅降低了推理成本。此次开源的FlashMLA是这一技术的升级版本。

核心特性:

-

BF16支持

-

分页KV缓存(块大小64)

- 惊人的性能:H800 SXM5 GPU上可达到

-

内存速度上限:3000 GB/s

-

计算上限:580 TFLOPS

-

部署要求:

如果你想尝试这个项目,需要准备:

-

Hopper GPU

-

CUDA 12.3+

-

PyTorch 2.0+

快速上手指南:

-

安装:

python setup.py install

-

运行基准测试:

python tests/test_flash_mla.py

-

实际应用示例:

from flash_mla import get_mla_metadata, flash_mla_with_kvcache

业界反响

项目一经发布就收获了大量好评,甚至有网友幽默地表示:"听说第五天会是AGI"。确实,这样的开源力度和诚意让人期待接下来会有更多惊喜。

易安点评:在当前AI开源浪潮中,DeepSeek以实际行动展示了什么是真正的开放。通过开源核心技术,不仅能促进整个行业的发展,也能让更多开发者受益。期待DeepSeek开源周的后续精彩内容!

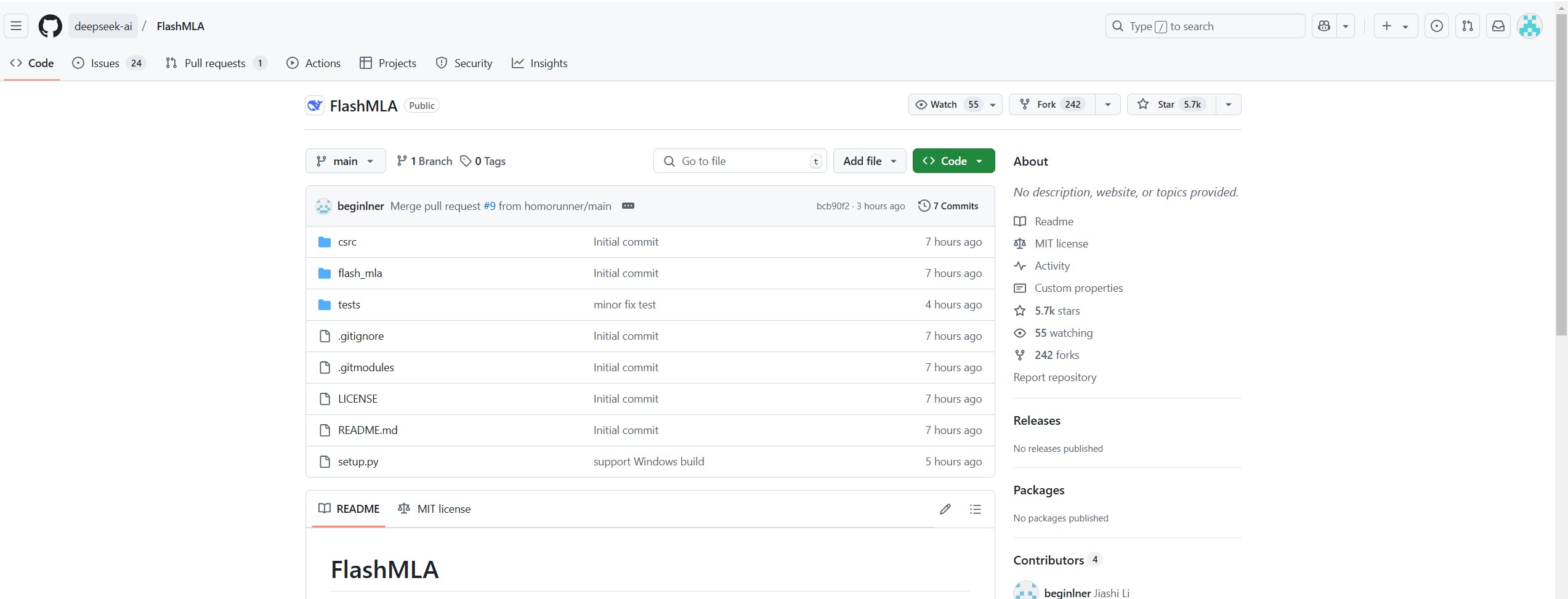

项目地址:https://github.com/deepseek-ai/FlashMLA

我是易安,一位专注AI技术研究的AI超级个体。每天为大家带来前沿AI工具评测和实践经验,用通俗易懂的方式解读复杂的技术概念。

👉 点击关注,一起探索AI技术的无限可能!

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)