DeepSeek本地部署指南:带你拥有一个无限制次数、团队可使用的本地DeepSeek

最近,由深度探索公司发布的一款大模型应用DeepSeek火爆国内外,连续多日登上国内各大平台的热搜。DeepSeek-R1训练成本低昂、开源、性能堪比目前世界上表现最好的大模型OpenAI-o1应用,在数学推理、程序设计、自然语言理解等领域展现出卓越性能,对于广大从业者无疑是福音。但是,DeepSeek-R1由于爆火访问量大,经常报“服务器繁忙,请稍后再试”,使用体验不好,也影响正常使用。本地部署

一、引言

最近,由深度探索公司发布的一款大模型应用DeepSeek火爆国内外,连续多日登上国内各大平台的热搜。DeepSeek-R1训练成本低昂、开源、性能堪比目前世界上表现最好的大模型OpenAI-o1应用,在数学推理、程序设计、自然语言理解等领域展现出卓越性能,对于广大从业者无疑是福音。

欢迎关注工 众 号:ItBeeCoder,查看更多高质量技术文章,发送“ds”获取资料

以下是DeepSeek官网(https://www.deepseek.com/)发布的该模型与其他国内外主流模型的对比。

但是,DeepSeek-R1由于爆火访问量大,经常报“服务器繁忙,请稍后再试”(个人的使用体验是晚上11点-早上8点深度思考(R1)模式报服务器繁忙的概率低),使用体验不好,也影响正常使用。本地部署能够有效解决该问题,所以最近尝试了一下本地部署DeepSeek,由于个人电脑配置较低,版本是DeepSeek-R1-Distill-Qwen-1.5B,下文介绍的部署流程亲测可用。

二、Ollama 安装部署

Ollama 是一个开源的本地大语言模型运行框架,目前比较主流、成本最低的部署本地大模型的方法,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。本文介绍使用Ollama 本地化部署DeepSeek的主要流程。ollama的官网地址是:https://ollama.com/。

访问ollama官网下载ollama, https://ollama.com/download,可以看到Ollama支持macOS、Linux,Windows三种系统。如果是macOS和Windows系统,点击下载即可。如果是Linux,使用命令:

curl -fsSL https://ollama.com/install.sh | sh

进行下载。不同网络环境下载时间可能不同。

关于curl命令的用法,工 众 号:ItBeeCoder里, 【Linux curl命令用法详解(1)】里有详细介绍,感兴趣的读者可到该文查看

如果是Windows系统,下载完成后,点击exe文件即可安装完成。Linux系统的话,使用curl命令即可完成安装。

安装完成后,使用

ollama --version

命令确认是否安装成功。如下所示即为安装成功。

ollama 会在我们本地服务监听 11434 端口,在Windows系统中,浏览器中访问地址:http://localhost:11434,如下所示,可以看到Ollama已经在运行。

在Linux系统中,使用以下命令查看端口的使用情况:

sudo lsof -i :11434

关于lsof命令的用法,工 众 号:ItBeeCoder里,【Linux:查看端口使用情况常用方法指南】 里有详细介绍,感兴趣的读者可到该文查看

三、使用Ollama安装DeepSeek

1、访问Ollama官网:https://ollama.com/library,可以看到第一个即是DeepSeek-R1,点击进入,可以看到有不同蒸馏版本和满血版(参数为6710亿,大小为404GB)的DeepSeek模型。

2、对于蒸馏版本的DeepSeek模型,下拉列表中选择不同的参数,如:1.5B,即可使用命令ollama run deepseek-r1:1.5b拉取并运行模型。如果部署是满血版(指参数为6710亿的deepseek-r1),使用命令:ollama run deepseek-r1:671b。

上文提到的蒸馏可理解为从其他模型如Qwen 7B(DeepSeek-R1-Distill-Qwen-7B)中提取知识来训练自己,能够减小模型大小,显著降低计算资源需求,提供更高效的推理能力。Distill即为“蒸馏”的意思。

欢迎关注工 众 号:ItBeeCoder,查看更多高质量技术文章,发送“ds”获取资料

3、补充说明

1)deepseek不同版本介绍

deepseek蒸馏版的参数量有:1.5B、7B、14B、32亿、70B等,从 1.5B 到 70B 不等,有以下几种版本:

DeepSeek-R1-Distill-Qwen-1.5B

DeepSeek-R1-Distill-Qwen-7B

DeepSeek-R1-Distill-Qwen-14B

DeepSeek-R1-Distill-Qwen-32B

DeepSeek-R1-Distill-Llama-8B

DeepSeek-R1-Distill-Llama-70B

以DeepSeek-R1-Distill-Qwen-14B为例:

DeepSeek-R1 是主模型的名字;Distill表示这是一个蒸馏后的版本;Distill后面跟的名字表示该版本是从哪个模型蒸馏来的,DeepSeek-R1-Distill-Qwen-14B 表示该版本是从阿里巴巴的大模型千问(Qwen)蒸馏而来,最后的参数量14B(其它如 671B、32B、1.5B)表示模型中可训练参数的数量( “B” 全称是 “Billion” ,也就是中文中的十亿。671B、32B、1.5B 分别表示模型的参数量为 6710亿、320亿和15亿。),参数量越大,模型的表达能力和复杂度越高,对硬件资源的需求越高。

不同版本需要的硬件不同,例如,部署满血版的 DeepSeek-R1 至少需要 1T 内存和双 H100 80G 的推理服务器。

欢迎关注工 众 号:ItBeeCoder,查看更多高质量技术文章,发送“ds”获取资料

四、可视化客户端Chatbox

目前市面上有很多可以在本地与 AI 模型交互的客户端,个人在使用过程中体验较好的是Chatbox,安装简单,界面简洁,交互友好。

Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和Ollama 在内的多种主流模型的 API 接入 ,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。官网地址是https://chatboxai.app/zh,以下是官网的截图,可以免费下载Windows系统的客户端,也支持网页版和移动端Android、IOS系统。目前在Github上该工具的star数已经有31.7K。

Chatbox下载之后,按照提示安装即可。以下是安装完成后首次进入界面时候的提示,要求用户选择配置AI模型提供方,本文是本地部署的模型,所以选择“使用自己的API Key或本地模型”。

然后进入到设置页面,可以在下拉列表中选择模型提供方,这里是OLLAMA API,OLLAMA默认监听的是11434接口,其它配置信息如下所示,设置完成后,点击保存即可。

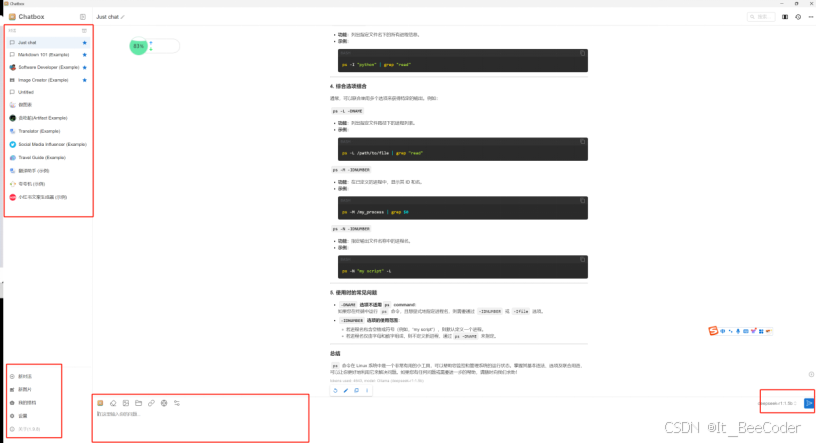

以上配置完成后,即可正常使用Chatbox,以下是Chatbox界面上的一些区域划分。

以上,DeepSeek本地部署及用户客户端安装整个流程完成。用户即可丝滑、不受次数限制使用,摆脱DeepSeek官方服务【服务器繁忙】的困扰。

欢迎关注工 众 号:ItBeeCoder,查看更多高质量技术文章,发送“ds”获取资料

五、补充:Ollama常用命令

Ollama 提供了一些命令帮助用户更好地管理和使用 Ollama 模型。

1)模型管理类

ollama run <model>:下载并运行指定的模型。例如,ollama run llama2 会自动下载并启动 LLaMA 2 模型。

ollama pull <model>:只下载模型,但不运行。例如,ollama pull mistral。

ollama list:查看本地已有的模型列表。

ollama rm <model>:删除指定的模型。例如,ollama rm llama2。

ollama cp <source_model> <destination_model>:复制模型。例如,ollama cp llama3 my-model。ollama push <model>:将模型推送到注册仓库。

ollama create <model_name> -f <Modelfile>:从 Modelfile 创建模型。例如,ollama create my-model -f Modelfile。

2)服务管理类

ollama serve:启动 Ollama 服务。

ollama ps:列出正在运行的模型。

3)其他

ollama show <model>:显示指定模型的信息。

ollama help:获取关于任何命令的帮助。

ollama --version:查看ollama 版本,判断是否安装成功。

4)Docker中,可以使用以下命令进入Ollama容器

docker exec -it ollama bash

六、使用文档

官方也提供了Deepseek的使用文档,地址为:官方也提供了Deepseek的使用文档,地址为:https://api-docs.deepseek.com/zh-cn/。

欢迎关注工 众 号:ItBeeCoder,查看更多高质量技术文章,发送“ds”获取资料

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)