在本地部署Deepseek

这篇文章介绍用LM Studio和huggingface部署一个deepseek到自己的电脑上,应该不需要代码知识,至少不需要太多。

这篇文章介绍用LM Studio和huggingface部署一个deepseek到自己的电脑上,应该不需要代码知识,至少不需要太多

准备

电脑

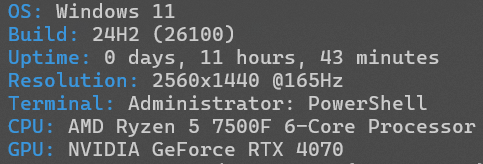

我的电脑显卡是 RTX 4070(12GB显存)

软件

首先你需要一个LM Studio软件,https://lmstudio.ai/,安装包我放在文章开头,你也可以自己下载。

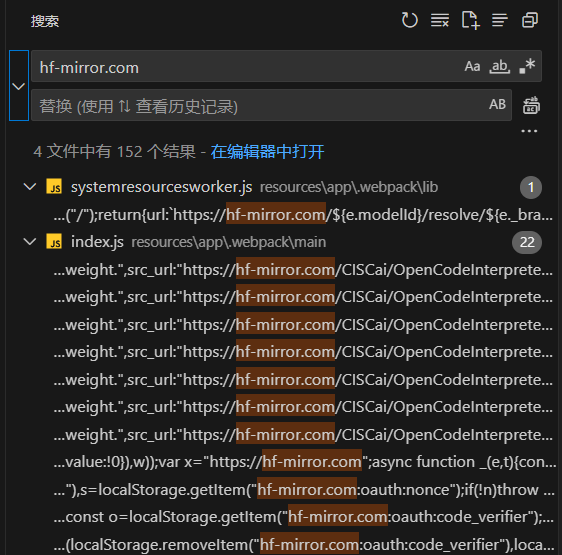

安装成功后,一般情况下打开软件是加载不出来东西的,因为默认连接的 https://huggingface.co/ 在国外,我们需要替换成国内镜像站 https://hf-mirror.com/。

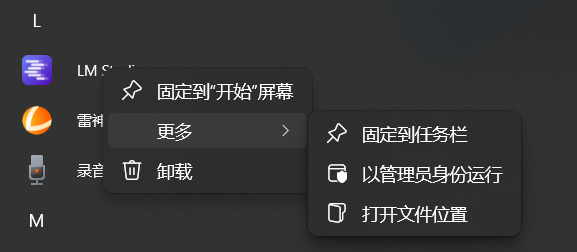

安装成功以后,我们需要找到LM Studio的安装文件夹

再对快捷方式再“打开文件位置”,就找到了安装位置,再用VS Code打开这个文件夹

利用VS Code的全局搜索与替换功能,将所有的 huggingface.co 全部替换成 hf-mirror.com

此时重新启动软件,应该就能刷出来模型的列表了。

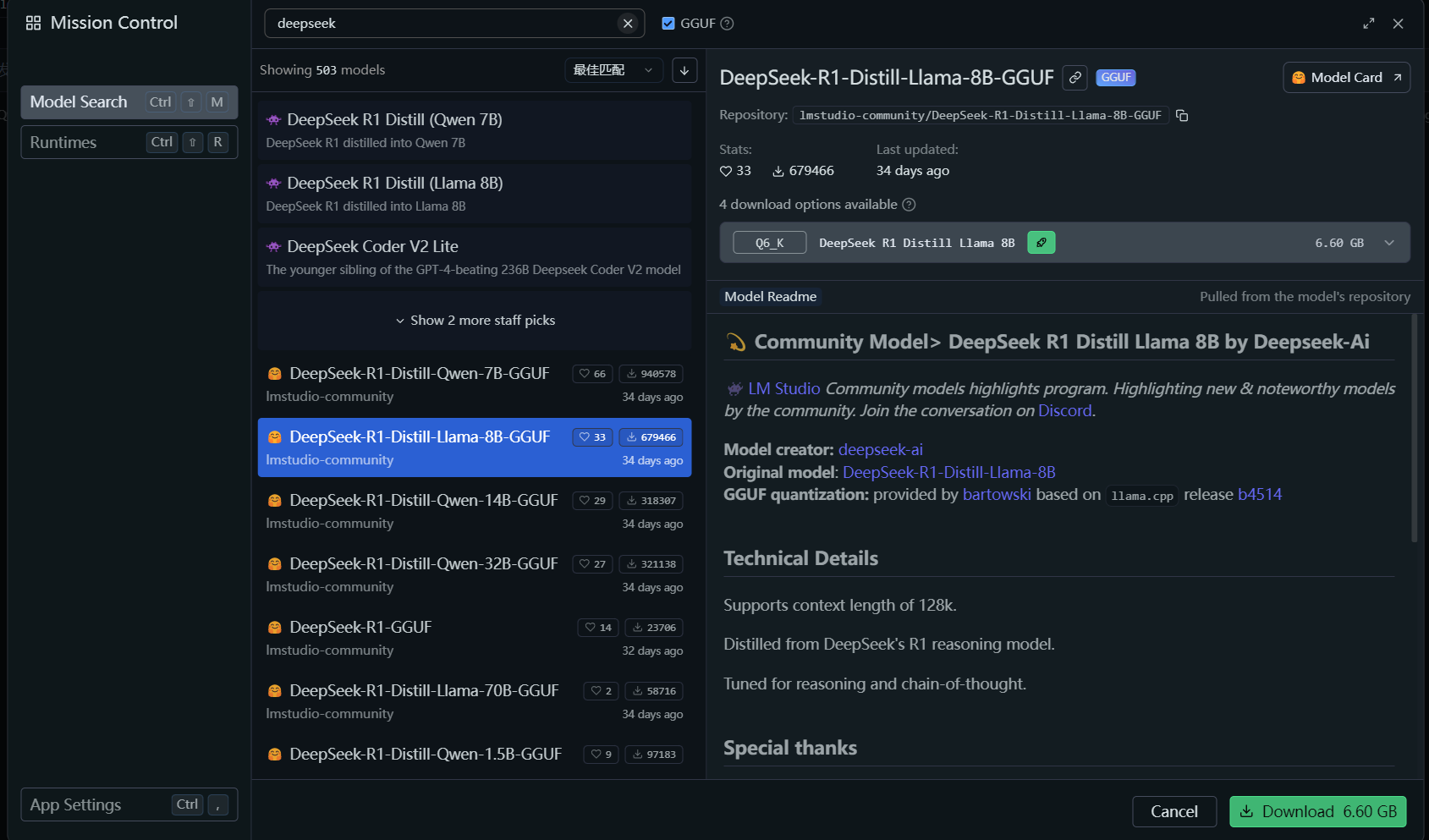

安装

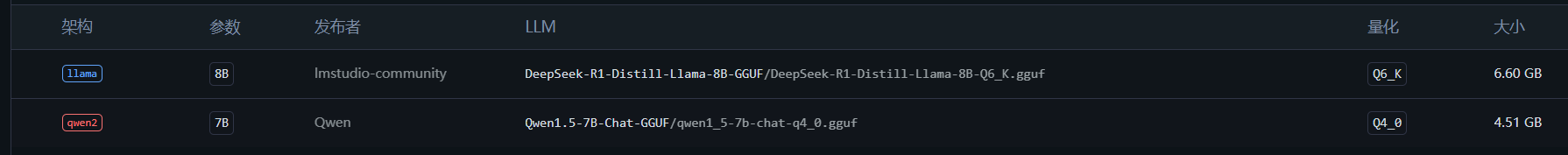

我们以DeepSeek-R1-Distill-Llama-8B-GGUF,Q6_K为例子,左侧选择发现,直接搜索下载即可。

即使使用镜像下载也可能比较慢,你也可以直接访问https://hf-mirror.com/,搜索,获取下载链接以后用第三方下载器下载

下载完成应该是个gguf格式的文件。然后用这个替换掉LM Studio下载文件夹下的临时下载文件,比如我的位置是C:\Users\用户名\.lmstudio\models\lmstudio-community\DeepSeek-R1-Distill-Llama-8B-GGUF,在这个目录下用下载好的gguf文件替换掉临时下载的文件,就能在左侧“我的模型”看到了

使用

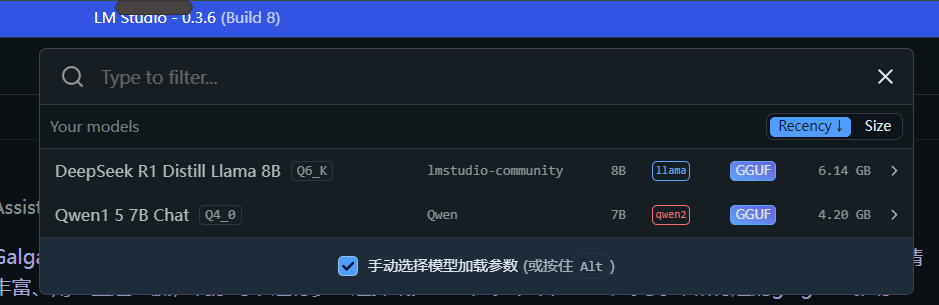

在首页开启对话时,选择要加载的模型:

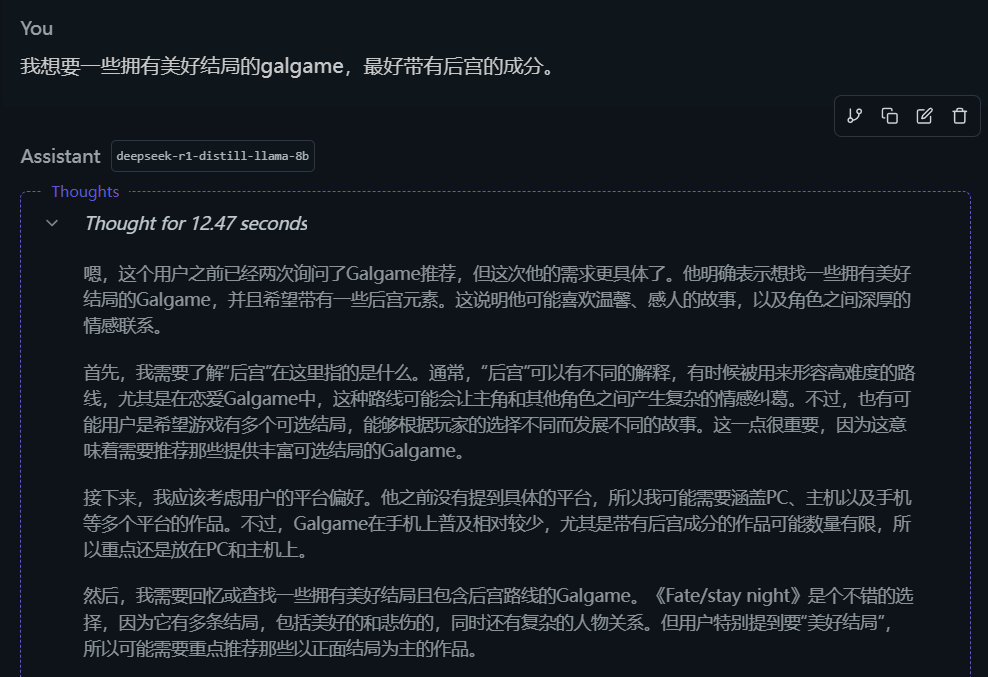

然后对话即可。

注意,这个模型需要 0.3.9 版本以上的 LM Studio,我在用 0.3.8 的 LM Studio 时遇到了bug,论坛上也有人报告这个问题:https://hf-mirror.com/lmstudio-community/DeepSeek-R1-Distill-Llama-8B-GGUF/discussions/1,所以请用最新的。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)