告别天价算力!本地部署DeepSeek大模型保姆级教程(基于Ollama 和 ChatBox)

在人工智能蓬勃发展的时代,本地化部署语言模型成为众多开发者和技术爱好者探索的前沿领域。DeepSeek R1 作为一款功能强大的语言模型,凭借其卓越的推理和生成能力,在自然语言处理等领域展现出独特优势。借助 Ollama 和 ChatBox 进行本地部署,我们能够在自己的设备上轻松驾驭这一强大工具,深入探索其无限潜力。接下来,我将为大家详细介绍在 Windows 系统上完成这一部署过程的每一个关键步骤,并附上关键环节的截图,助力大家顺利完成部署。

一、部署前准备

(一)硬件要求

不同版本的 DeepSeek R1 模型对硬件的要求有所差异,以下为您详细介绍:

1.5B 版本:适合在低资源设备上进行部署,常用于基础的文本处理任务。

CPU:最低需要 4 核,多核心能够在一定程度上提升处理速度,使模型在运行时更流畅地完成任务。

内存:8GB 及以上,充足的内存可以保障模型在处理文本时,有足够的空间存储临时数据和中间结果。

硬盘:需要 3GB 以上的存储空间,用于存放模型文件以及运行过程中产生的一些临时文件。

显卡:非必需配置,如果希望借助 GPU 加速来提升运行效率,可选显存 4GB 及以上的显卡,以加快模型的推理速度 。

7B 版本:可用于本地开发测试等场景,满足一些基础的复杂任务需求。

CPU:建议 8 核以上,强大的 CPU 核心数能够在并行处理任务时发挥优势,尤其在模型处理大量文本数据时,能有效缩短处理时间。

内存:16GB 及以上,相比 1.5B 版本,7B 模型需要更多内存来存储更大规模的参数和数据,以确保模型稳定运行。

硬盘:8GB 及以上,用于存储模型文件以及相关的配置文件等。

显卡:推荐 8GB 及以上显存的显卡,显卡在模型运行过程中,能够加速矩阵运算等操作,显著提升模型的推理速度,特别是在处理长文本或高并发请求时。

8B 版本:适用于需要更高精度的轻量级任务,硬件需求与 7B 版本相近但略高。

CPU:8 核以上,且建议选择时钟频率较高的 CPU,以应对模型对计算能力的更高要求,在处理高精度任务时,能够更快地完成复杂计算。

内存:16GB 及以上,随着任务精度要求的提高,模型需要更多内存来存储更精确的计算数据和中间结果。

硬盘:8GB 及以上,用于存储模型文件以及运行过程中产生的临时文件和日志文件等。

显卡:8GB 及以上显存的显卡,与 7B 版本类似,显卡的加速作用在处理高精度任务时尤为重要,能够帮助模型更快地生成更准确的结果。

14B 版本:常用于企业级复杂任务场景,对硬件性能有较高要求。

CPU:12 核以上,在企业级应用中,模型可能需要同时处理多个复杂任务,多核心的 CPU 能够有效提升任务处理效率,确保系统的响应速度。

内存:32GB 及以上,大规模的模型参数和复杂的企业级数据处理需求,需要大量内存来支撑,以保证模型在高负载下稳定运行。

硬盘:15GB 及以上,用于存储企业级应用中产生的大量数据以及模型的备份文件等。

显卡:16GB 及以上显存的显卡,在处理企业级复杂任务时,如大规模数据分析、复杂文本生成等,强大的显卡能够显著提升模型的处理速度和效率。

32B 版本:适用于高精度专业领域任务,对硬件性能要求较高。

CPU:16 核以上,在专业领域任务中,模型需要进行大量复杂的计算和推理,多核心的 CPU 能够提供强大的计算能力,满足专业领域对模型性能的严格要求。

内存:64GB 及以上,为了存储大规模的专业数据和高精度的模型参数,需要足够的内存来保障模型的运行,以确保模型在处理专业任务时的准确性和稳定性。

硬盘:30GB 及以上,用于存储专业领域的大量数据和模型文件,以及运行过程中产生的各种结果文件。

显卡:24GB 及以上显存的显卡,在处理高精度专业任务时,显卡的强大计算能力能够加速模型的推理过程,提高任务处理的速度和精度。

70B 版本:适合科研机构等进行高复杂度生成任务,对硬件要求极高。

CPU:32 核以上,高复杂度的生成任务需要极其强大的计算能力,多核心的 CPU 能够并行处理大量复杂计算,确保模型在处理高难度任务时的高效运行。

内存:128GB 及以上,为了存储海量的模型参数和处理高复杂度任务所需的大量数据,需要充足的内存来支撑,以保证模型在运行过程中不会因内存不足而出现卡顿或错误。

硬盘:70GB 及以上,用于存储科研机构在进行高复杂度任务时产生的大量数据和模型文件,以及各种实验结果和分析数据。

显卡:通常需要多卡并行,单张显卡的性能已无法满足 70B 模型在高复杂度任务中的需求,通过多卡并行可以显著提升显卡的计算能力,加速模型的运行,以实现复杂的科研任务,如大规模语言生成、复杂算法验证等。

如果您仅进行简单的测试或学习,1.5B - 7B 版本配合相对较低配置的硬件即可;若用于专业领域或企业级应用,建议选择 32B 及以上版本,并配备相应高性能硬件 。

此外,为确保模型运行时数据处理的高效性,通用的硬件建议如下:

处理器:除上述各版本对应要求外,若条件允许,建议选用多核高性能 CPU,如英特尔酷睿 i7 及以上系列,或 AMD 锐龙系列中性能相当的处理器。这类处理器能够显著提升数据处理速度,为模型运行提供坚实的基础。

GPU:NVIDIA 的 GPU 在兼容性和性能表现上尤为突出,在满足各版本显存要求基础上,推荐使用 RTX 30 系列或 Ampere 架构 GPU ,强大的 GPU 加速能力对于模型推理和训练过程至关重要,能够大幅缩短运行时间,提高工作效率。

内存:在满足各版本内存要求基础上,系统内存至少为 16GB ,在处理大规模任务时,32GB 及以上的内存配置能有效避免因内存不足导致的程序卡顿甚至崩溃,确保系统运行的稳定性和流畅性。

存储:准备至少 50GB 的可用硬盘空间,除满足各版本模型存储需求外,还用于存储相关依赖以及中间运行数据,保障部署和运行过程的顺利进行。

(二)软件要求

操作系统:请确保您的系统为 Windows 10/11 ,以保证与后续安装的软件具备良好的兼容性。

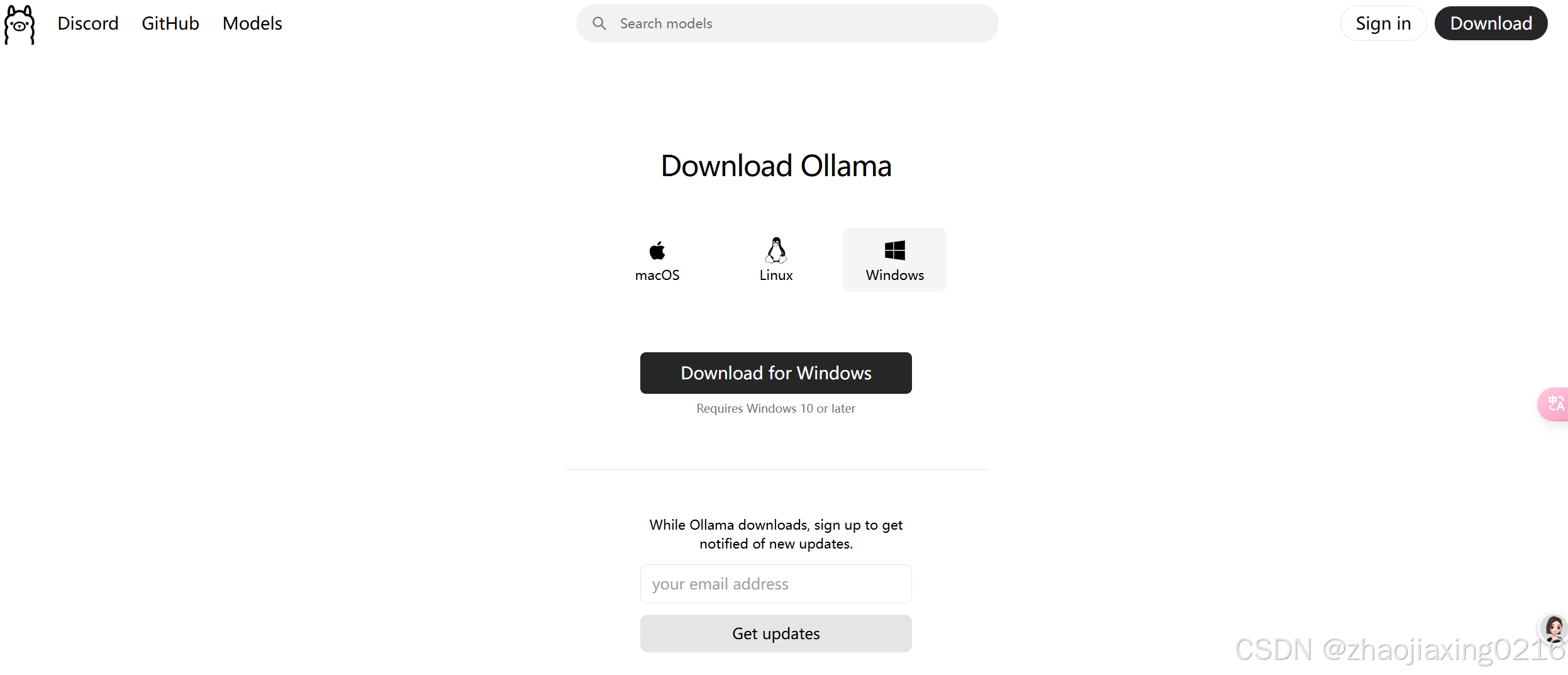

二、安装 Ollama

下载安装包:打开常用浏览器,访问 Ollama 官网https://ollama.com/download/windows。在官网首页,找到醒目的 “Download for Windows” 按钮,点击它进入下载页面。在下载页面中,找到适用于 Windows 系统的安装包下载链接,点击进行下载。

开始安装:下载完成后,找到下载的安装包文件(通常位于浏览器的默认下载路径或您指定的下载文件夹中),双击该安装包出现如下界面,选择install进行安装。

验证安装:安装完成后,打开命令提示符,输入ollama --version 。若能正确输出版本信息,如0.5.11 ,则表明 Ollama 已成功安装,如下所示:

C:\Users\YourUsername>ollama --version

三、安装 ChatBox

查找下载入口:打开浏览器,访问 ChatBox 官方网站(https://chatboxai.app/zh#download)。如下图所示:

下载安装包:找到适用于 Windows 系统的安装包下载链接,点击进行下载。下载完成后,找到下载的安装包文件(通常在浏览器默认下载路径或您指定的文件夹中)。

运行安装程序:双击安装包,启动安装向导。在安装向导的欢迎界面,点击 “下一步” 继续。

安装完成:安装完成后,会弹出安装完成界面,点击 “Finish” 完成安装。此时,您可以在桌面或开始菜单中找到 ChatBox 的快捷方式,方便后续使用。

四、使用 Ollama 下载 DeepSeek R1 模型

打开命令提示符,输入以下命令开始下载 DeepSeek R1 模型:

ollama pull deepseek-r1

如果您需要下载特定版本,比如 7B 版本,可以使用以下命令:

ollama pull deepseek-r1:7b

由于模型文件通常较大,下载过程可能会根据网络情况耗时不等,请您耐心等待。在下载过程中,请确保网络连接稳定,避免因网络波动导致下载失败。

2. 下载完成后,输入以下命令验证模型是否成功下载:

ollama list

在输出的已安装模型列表中,您应能看到deepseek-r1 或对应的版本信息。若未找到相关信息,可能是下载过程出现问题,请重新检查下载命令和网络连接。

五、配置 ChatBox 与 DeepSeek R1 模型连接

-

打开 Chatbox 软件,点击左下角的设置图标。

-

在设置中选择“模型提供方”,选择“Ollama”。

-

在“API 域名”框中填写 http://localhost:11434(这是 Ollama 的默认端口)。

-

在“模型”下拉菜单中选择您部署的 DeepSeek 模型版本(如 deepseek-r1:7b)。

-

其他选项保持默认即可,最后点击“保存”。

六、运行与测试

在 ChatBox 中,输入您想要询问的问题或任务,例如 “写一段 Python 代码实现冒泡排序”,然后点击发送按钮。在输入问题时,请尽量表述清晰,以便模型能够准确理解您的需求。

ChatBox 会将您的请求发送给 Ollama,Ollama 随即调用 DeepSeek R1 模型进行处理,并将处理结果返回给 ChatBox。在 ChatBox 界面中,您将看到模型生成的回答。通过这一过程,您可以直观感受到 DeepSeek R1 模型的强大功能。

示例运行

假设我们要询问关于量子计算的简单解释,在 ChatBox 中输入 “请用简单的语言解释量子计算”,稍等片刻,DeepSeek R1 模型会给出类似这样的回答:“量子计算是利用量子力学原理进行计算的技术。与传统计算机使用二进制的 0 和 1 来存储和处理信息不同,量子计算机使用量子比特(qubit)。量子比特可以同时处于 0 和 1 的叠加态,这使得量子计算机在某些复杂计算任务上,比如密码学破解、分子模拟等,相比传统计算机能够实现指数级的加速。” 通过这个示例,我们可以看到 DeepSeek R1 模型在知识问答方面的出色表现。

七、常见问题及解决办法

(一)模型下载失败

原因:模型下载失败可能是由于网络问题,如网络连接不稳定、网络中断等;也可能是 Ollama 服务器端出现临时故障,导致无法正常提供下载服务。

解决办法:首先检查网络连接是否正常,您可以尝试打开其他网页或进行网络测试,确保网络畅通。若网络正常,可尝试更换网络环境,如从 Wi-Fi 切换到移动数据,或反之。如果是服务器端问题,建议稍后再尝试下载,通常服务器故障会在短时间内得到修复。

(二)ChatBox 无法连接到模型

原因:ChatBox 无法连接到模型可能是因为地址配置错误,如输入的服务器地址有误或端口号被占用;也可能是 Ollama 服务未正常启动,导致无法响应 ChatBox 的连接请求。

解决办法:仔细检查 ChatBox 中的地址配置是否为http://127.0.0.1:11434 ,确保地址和端口号准确无误。同时,打开命令提示符,输入ollama status 查看 Ollama 服务状态。如果未启动,输入ollama server 启动服务。若端口号被占用,您可以尝试更改 Ollama 的服务端口,具体方法可参考 Ollama 的官方文档。

(三)模型运行缓慢

原因:模型运行缓慢可能是由于硬件配置不足,如 CPU 性能较低,无法满足模型运行的计算需求;GPU 未正确识别,导致无法发挥其加速作用;内存不足,使得模型在处理数据时频繁进行磁盘交换,影响运行速度。

解决办法:考虑升级硬件,如更换更高性能的 CPU、升级 GPU 或增加内存。同时,检查 GPU 驱动是否安装正确,以及 Ollama 是否正确识别 GPU。您可以通过设备管理器查看 GPU 驱动状态,若有问题,可前往 NVIDIA 官网下载最新驱动进行安装。此外,关闭其他占用资源的程序,释放系统内存,也能有效提升模型运行速度。

通过以上详细步骤,您已经成功使用 Ollama 和 ChatBox 在 Windows 系统上部署并运行了 DeepSeek R1 模型。现在,您可以尽情探索 DeepSeek R1 在自然语言处理、代码生成、知识问答等多领域的应用潜力,开启属于您的人工智能探索之旅。如果在部署和使用过程中遇到任何问题,欢迎随时查阅相关资料或向技术社区寻求帮助。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)