本地部署deepseek并结合vscode使用

:: tipollama官网下载太慢,点击下方下载其余到官网下载点击下载以后双击安装::: tipollama默认安装在C盘,不可以更改安装路径。

本地部署deepseek并结合vscode使用

1. 安装ollama

::: tip

ollama官网下载太慢,点击下方下载

:::

其余到官网下载

点击下载以后双击安装

::: tip

ollama默认安装在C盘,不可以更改安装路径

:::

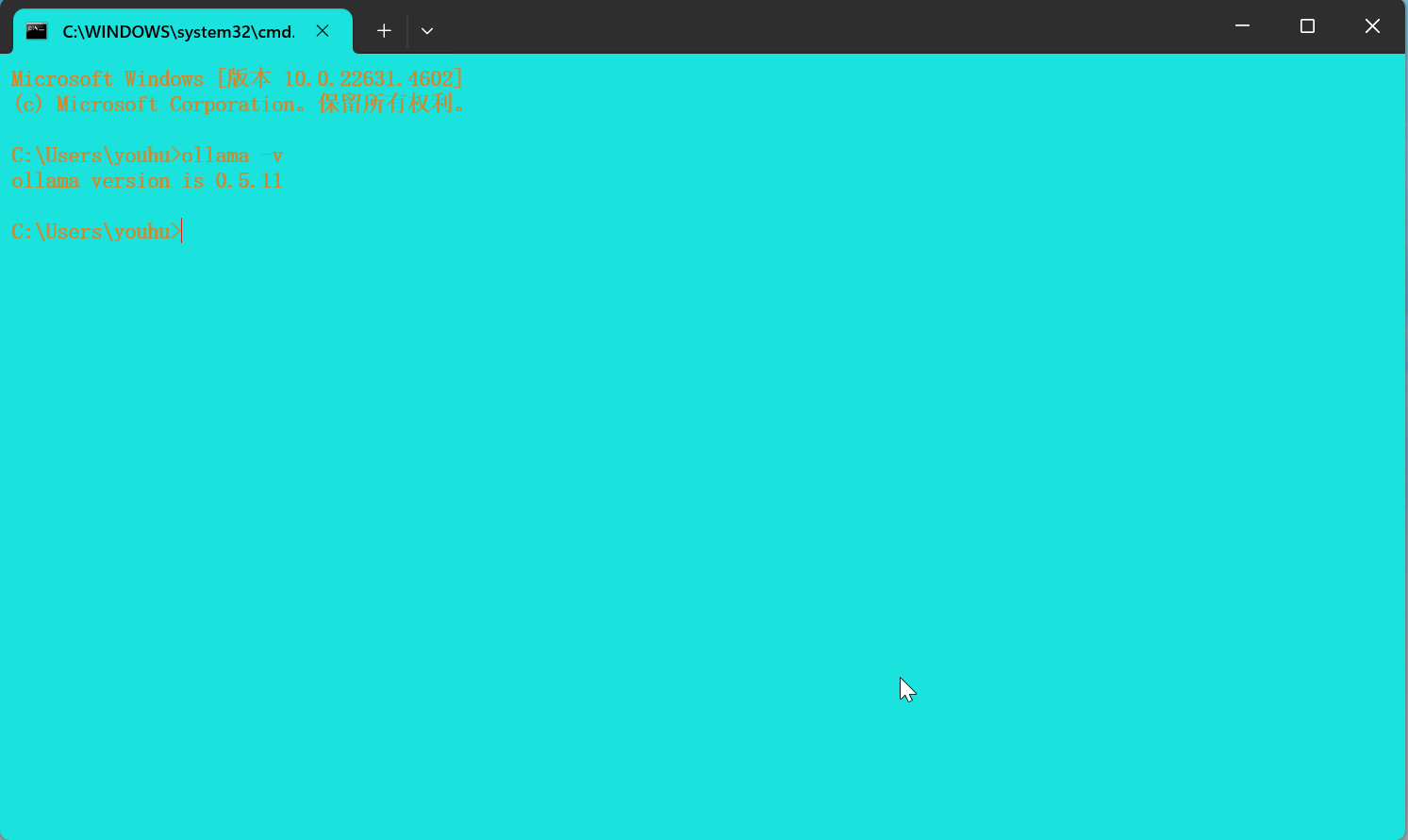

验证安装是否成功

win+R打开运行,输入cmd回车,输入ollama -v回车

ollama -v

如下图所示:

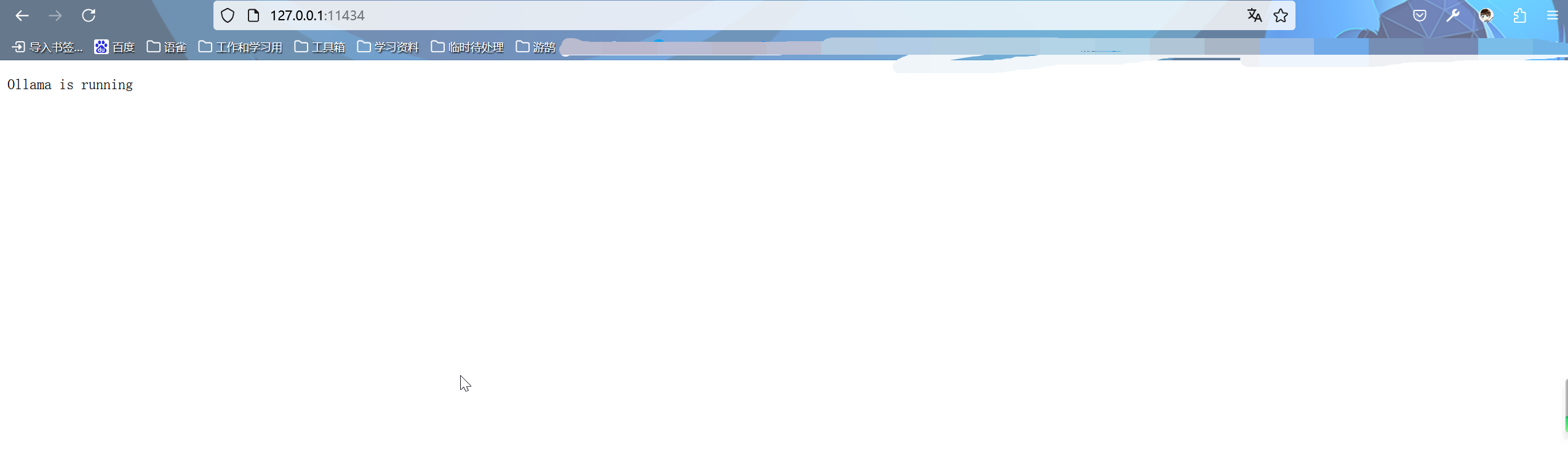

也可以开发浏览器,输入http://127.0.0.1:11434/回车,如下图所示:

2. 安装deepseek

1选择合适模型

DeepSeek模型的不同版本对硬件配置的需求各不相同,具体如下:

1.5B版本:

CPU:最低4核(推荐Intel或AMD多核处理器)

内存:8GB+

硬盘:3GB+(模型文件约1.5-2GB)

显卡:非必需(纯CPU推理),若GPU加速可选4GB+显存(如GTX 1650)

7B版本:

CPU:8核以上(推荐现代多核CPU)

内存:16GB+

硬盘:8GB+(模型文件约4-5GB)

显卡:推荐8GB+显存(如RTX 3070/4060)

8B版本:

CPU:8核以上

内存:16GB+

硬盘:8GB+(模型文件约4-5GB)

显卡:推荐8GB+显存(如RTX 3070/4060)

14B版本:

CPU:12核以上

内存:32GB+

硬盘:15GB+

显卡:16GB+显存(如RTX 4090或A5000)

32B版本:

CPU:16核以上(如AMD Ryzen 9或Intel i9)

内存:64GB+

硬盘:30GB+

显卡:24GB+显存(如A100 40GB或双卡RTX 3090)

70B版本:

CPU:32核以上(服务器级CPU)

内存:128GB+

硬盘:70GB+

显卡:多卡并行(如2x A100 80GB或4x RTX 4090)

进入ollama官网,点击Models,选择第一个deepseek-r1,选择好对应模型,复制命令.如下图所示:

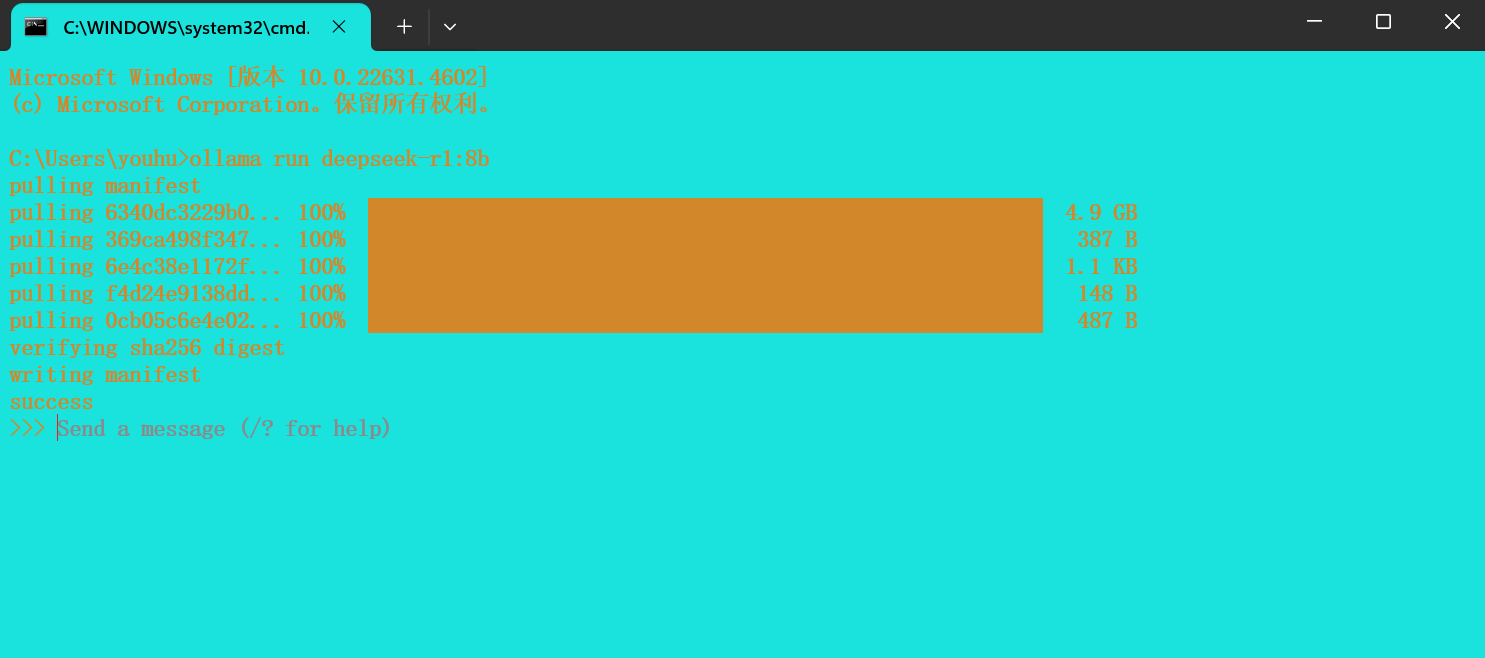

ollama run deepseek-r1

win+R打开运行,输入cmd回车,复制命令,回车,如下图所示:

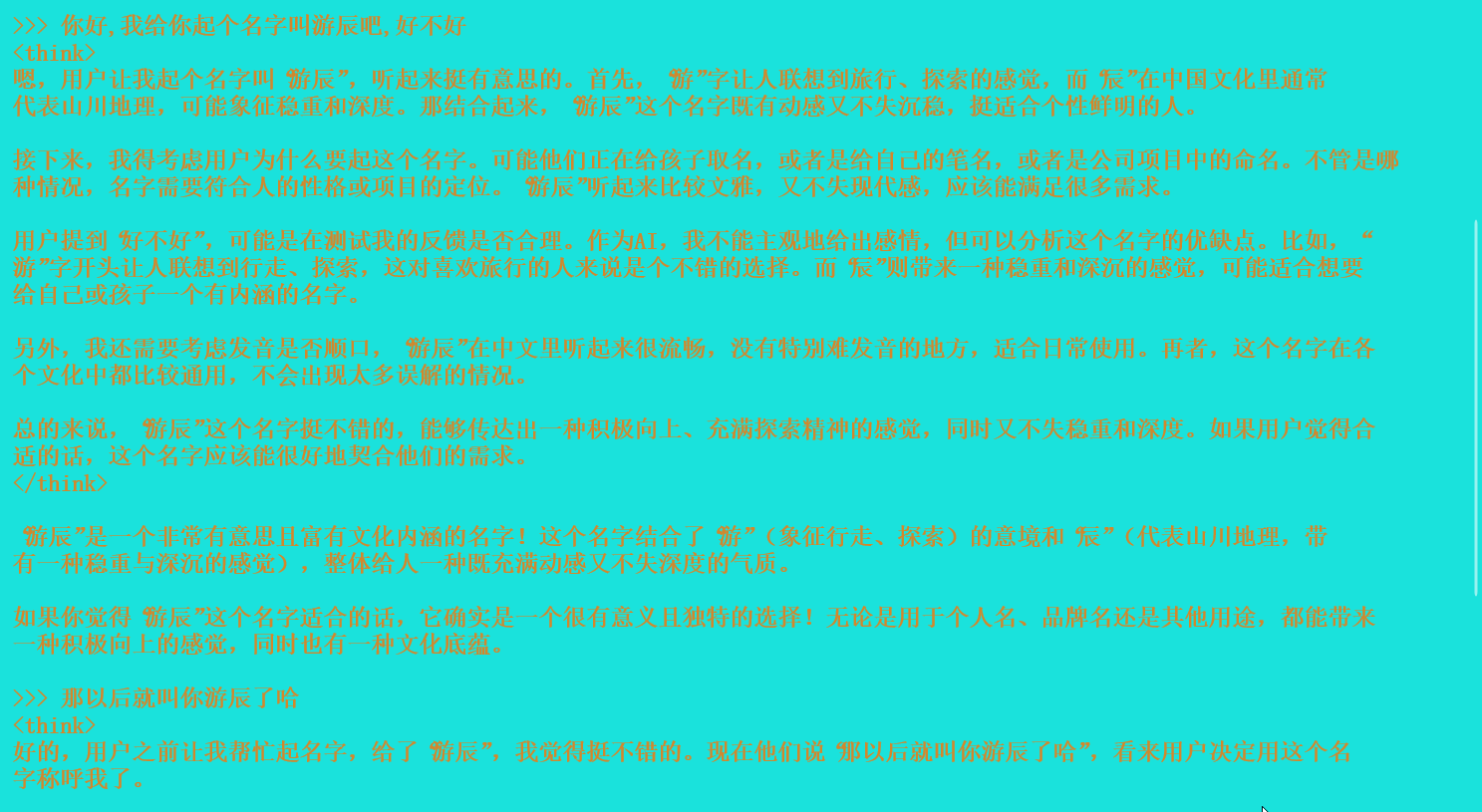

下载成功以后,测试如下

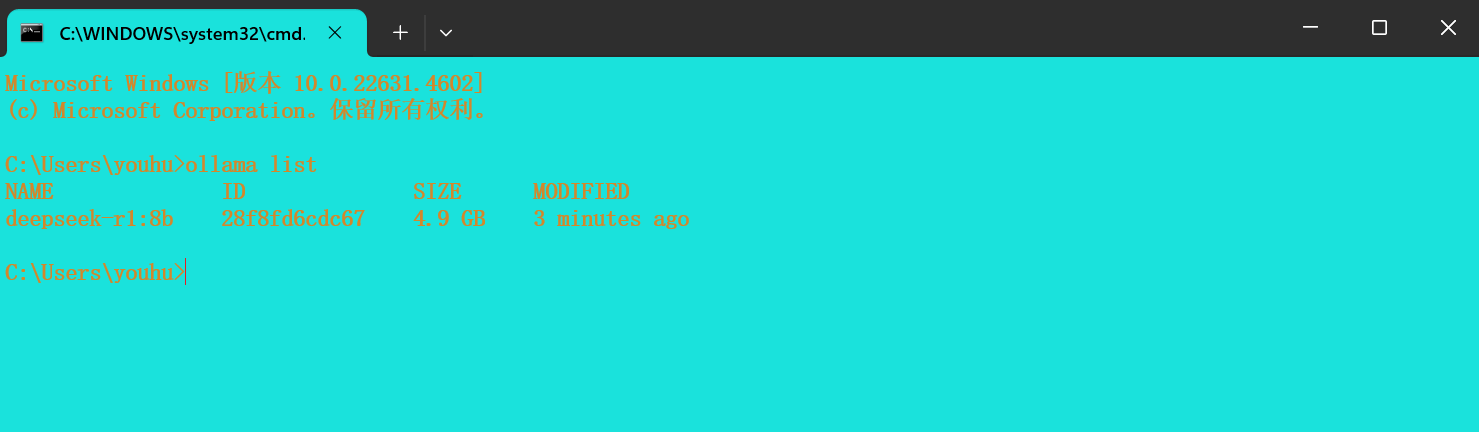

查看本地模型

ollama list

如图所示:

3. vscode配置deepseek

以下推荐几款插件

- 腾讯云 AI 代码助手

- Roo Code (prev. Roo Cline)

- CodeGPT: Chat & AI Agents

- Cline Chinese

::: tip

这里首推腾讯云 AI 代码助手,因为可以免费使用deepseek:r1模型,而且是671b.我们个人没有这么好的电脑可以支撑安装这个模型.

了解这个配置,其他的配置也都大同小异,自行研究

:::

安装好腾讯云 AI 代码助手,vscode左侧有一栏,点击打开对话,再点击左侧右上角的在新窗口打开可以在主界面显示.如图所示:

默认选择的是hunyuan,可以改为tencent:deepseek:r1,就是腾讯云的deepseek:r1模型.

本地配置deepseek

接上面说的,选择ollama,打开配置界面,如图所示:

:::tip

配置里面所说的模型id其实就是 ollama list 命令的返回值,里面的name

:::

配置好模型id,点击保存,本地的配置就完成了.

接下来就可以享受编写代码和文档时候的智能提示了.

个人最明显的感觉就是从ctrl+c和ctrl+v变成了tab.

总之就是爽!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)