使用英伟达 NVIDIA jetson orin 系列部署deepseek-r1

使用jetson orin 系列部署deepseek-r1

**

使用jetson orin 系列部署deepseek-r1

**

DeepSeek 第一代推理模型,性能与 OpenAI-o1 相当,其中包括基于 Llama 和 Qwen 从 DeepSeek-R1 提炼出的六个密集模型。

DeepSeek 团队已经证明,较大模型的推理模式可以提炼为较小的模型,从而获得比在小模型上通过 RL 发现的推理模式更好的性能。

以下是使用 DeepSeek-R1 生成的推理数据,针对研究界广泛使用的几种密集模型进行微调而创建的模型。评估结果表明,提炼出的较小密集模型在基准测试中表现优异。

在 NVIDIA Jetson Orin 系列设备上部署 DeepSeek 模型时,硬件配置对可部署模型的参数量有直接影响。以下是针对不同 Jetson Orin 设备的建议:

硬件平台 可运行的参数版本

硬件平台 可运行的参数版本

AGX Orin 64G 1.5B、7B、8B、14B、32B、70B

AGX Orin 32G 1.5B、7B、8B、14B、32B

Orin NX 16G 1.5B、7B、8B、14B

Orin NX 8G 1.5B、7B、8B

Orin Nano 8G 1.5B、7B、8B

Orin Nano 4G 1.5B

部署前准备:

系统:jetpack6.2,为了更高的 AI 性能,Orin NX 与Orin Nano将使用super模式

执行以下命令安装所需工具

下面展示一些 内联代码片。

sudo apt update

sudo apt install nvidia-jetpack -y

sudo apt install curl -y

curl -fsSL https://ollama.com/install.sh | sh

部署deepseek-r1

使用Orin Nano 4G部署deepseek-r1:1.5b

拉取deepseek-r1:1.5b

ollama pull deepseek-r1:1.5b

运行deepseek-r1:1.5b

ollama run deepseek-r1:1.5b

运行时各硬件占有率

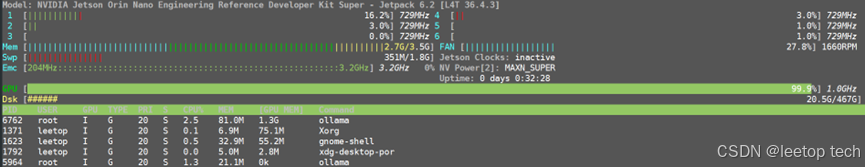

使用Orin Nano 8G部署deepseek-r1:7b

拉取deepseek-r1:7b

ollama pull deepseek-r1:7b

运行deepseek-r1:7b

ollama run deepseek-r1:7b

运行时各硬件占有率

使用Orin Nano 8G部署deepseek-r1:8b

拉取deepseek-r1:8b

ollama pull deepseek-r1:8b

运行deepseek-r1:8b

ollama run deepseek-r1:8b

运行时各硬件占有率

使用Orin NX 16G部署deepseek-r1:14b

拉取deepseek-r1:14b

ollama pull deepseek-r1:14b

运行deepseek-r1:14b

ollama run deepseek-r1:14b

运行时各硬件占有率

使用AGX Orin 32G部署deepseek-r1:32b

拉取deepseek-r1:32b

ollama pull deepseek-r1:32b

运行deepseek-r1:32b

ollama run deepseek-r1:32b

运行时各硬件占有率

使用AGX Orin 64G部署deepseek-r1:70b

拉取deepseek-r1:70b

ollama pull deepseek-r1:70b

运行deepseek-r1:70b

ollama run deepseek-r1:70b

运行时各硬件占有率

可视化

部署Open WebUI可以实现UI界面的本地大模型交互。

教程演示Docker安装Open WebUI。

Docker搭建

若没有安装Docker,可以使用脚本一键安装Docker。

sudo apt update

sudo apt install curl

curl -fsSL https://get.docker.com -o get-docker.sh

sudo sh get-docker.sh

docker安装完成后,执行以下命令安装open-webui

sudo docker pull ghcr.io/open-webui/open-webui:main

终端输入下面命令启动指定Docker:

sudo docker run --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main

成功启动后,在局域网内使用浏览器使用下面网址访问:

http://***.***.0.23:8080/

其中***.***.0.23为jetson的ip地址

第一次登录进去会弹出注册界面,使用前需要自己注册一个账号,该账号是管理员账号,信息可按照要求自行填写!

注册登录后即可开始使用

左上角可以选择使用ollama下载的模型

欢迎使用leetop公司的subkit系列和Gekit系列产品自己搭建Deepseek,体检私有大模型的魅力。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)