本地部署deepseek-r1模型+Dify的安装与使用

拉取模型指令ollama pull <模型名称>功能: 从模型库中下载指定的模型。示例。

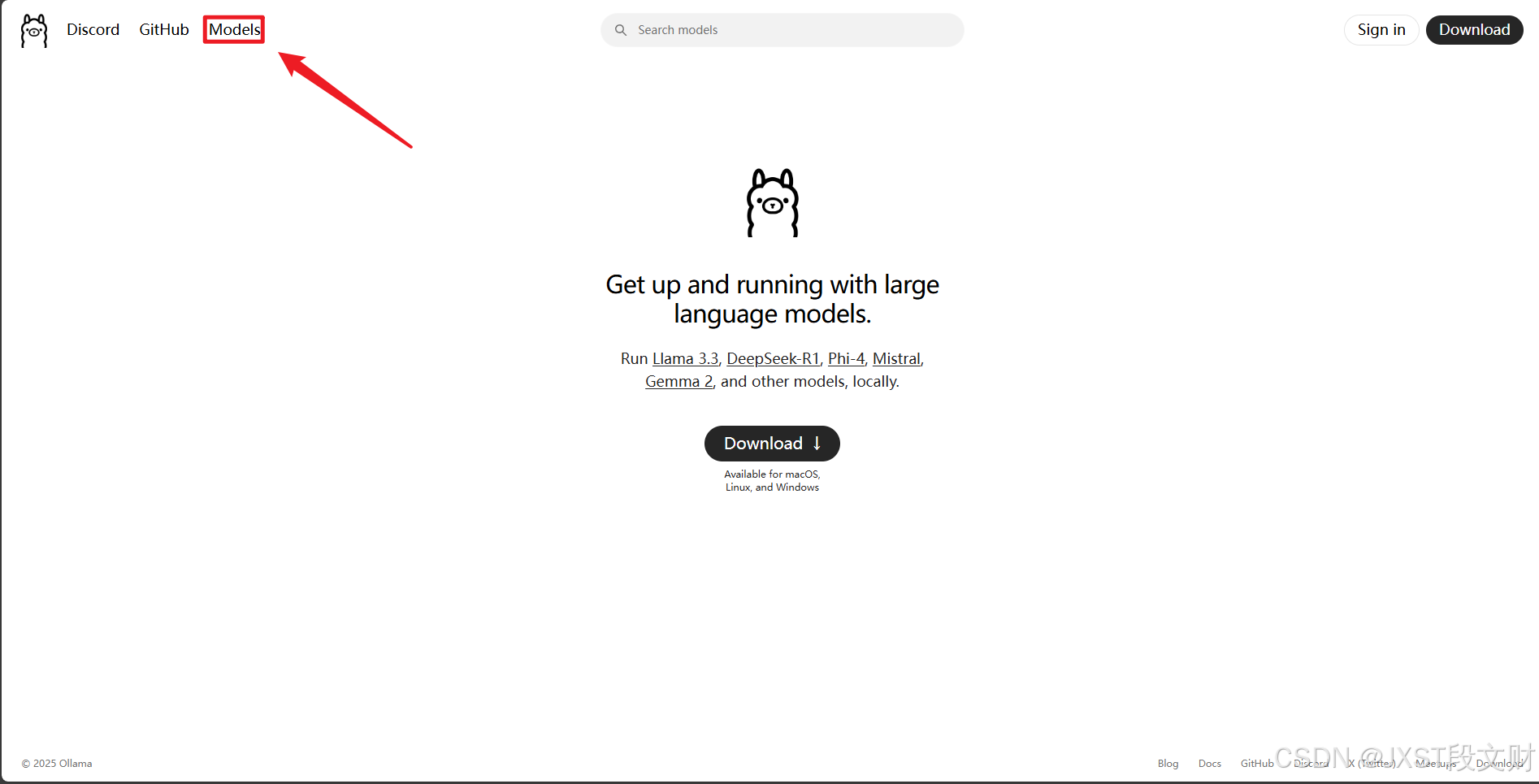

1、下载ollama,直接去官网就可以:Ollama

(1)下载好后调出系统终端(我习惯win+r输入cmd回车),输入下面指令:

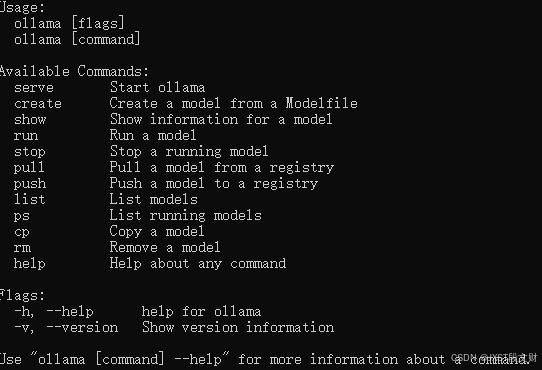

ollama会有如下结果:

(2)下面介绍一下ollama常用的一些指令(直接跳过,不用看):

1. 拉取模型

-

指令:

ollama pull <模型名称> -

功能: 从模型库中下载指定的模型。

-

示例:

ollama pull llama2

2. 运行模型

-

指令:

ollama run <模型名称> -

功能: 启动并运行指定的模型,进入交互模式。

-

示例:

ollama run llama2

3. 列出已安装的模型

-

指令:

ollama list -

功能: 显示本地已安装的所有模型。

4. 删除模型

-

指令:

ollama rm <模型名称> -

功能: 删除本地已安装的指定模型。

-

示例:

ollama rm llama2

5. 查看模型信息

-

指令:

ollama show <模型名称> -

功能: 显示指定模型的详细信息。

-

示例:

ollama show llama2

6. 复制模型

-

指令:

ollama cp <源模型名称> <目标模型名称> -

功能: 复制一个模型并重命名。

-

示例:

ollama cp llama2 llama2-copy

7. 创建自定义模型

-

指令:

ollama create <模型名称> -f <Modelfile路径> -

功能: 使用自定义的

Modelfile创建一个新模型。 -

示例:

ollama create my-model -f ./Modelfile

8. 推送模型

-

指令:

ollama push <模型名称> -

功能: 将本地模型推送到模型库。

-

示例:

ollama push my-model

9. 启动 Ollama 服务

-

指令:

ollama serve -

功能: 启动 Ollama 服务,通常在后台运行。

10. 停止 Ollama 服务

-

指令:

ollama stop -

功能: 停止正在运行的 Ollama 服务。

11. 查看帮助

-

指令:

ollama --help -

功能: 显示所有可用指令及其说明。

12. 更新模型

-

指令:

ollama pull <模型名称> -

功能: 如果模型有新版本,可以通过再次拉取来更新。

-

示例:

ollama pull llama2

13. 查看日志

-

指令:

ollama logs -

功能: 查看 Ollama 服务的日志信息。

14. 查看版本

-

指令:

ollama version -

功能: 显示当前 Ollama 的版本信息。

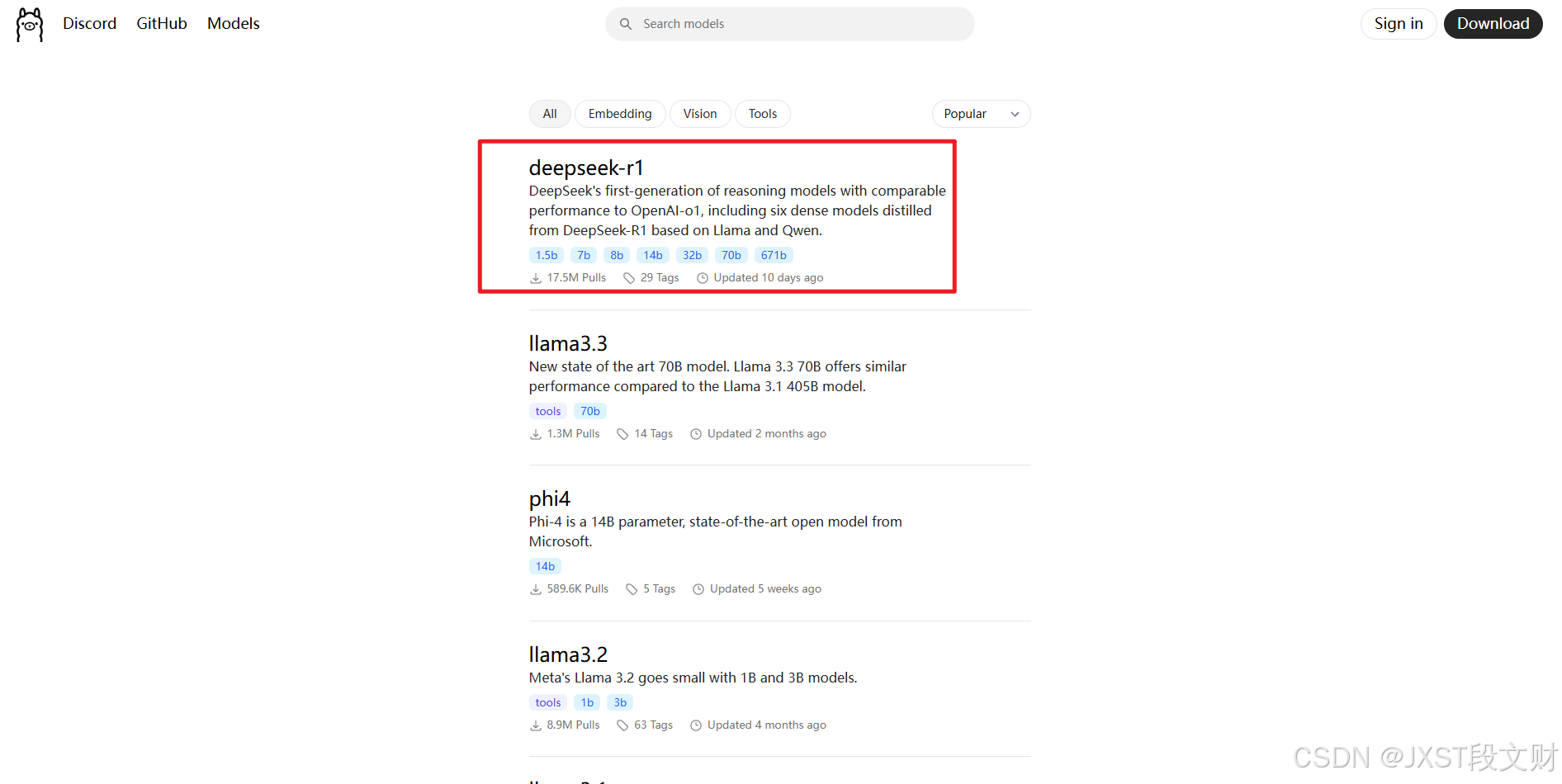

2、拉取模型

选择Models,找到deepseek-r1并点进去

然后打开刚刚的终端,把复制好的指令粘贴到终端上回车即可,剩下的就是等待了。如果太慢的话需要科学加速一下。

当拉取好后会直接运行该模型,会直接进入到输入框中,如下图所示:![]()

当想停止模型的运行的时候,直接摁ctr+d就可以终止模型的运行。

3、下载并运行Dify

我也是参考的一个博客来下载的,下载时候遇到的问题都可以解决,亲测有效,我直接给出连接地址:保姆教程篇:手把手教你从零开始本地部署Dify工作流-CSDN博客

如果遇到PowerShell的问题,可以直接参考这个:完美解决无法加载文件 WindowsPowerShell\profile.ps1系统编译问题-CSDN博客

4、使用Dify

上面的教程也给出了使用方法,直接不再赘述了。

5、通过Python代码实现本地模型AIP的调用

参考我写的文章(如果需要通过代码调用API来实现,需要先将ollama运行起来):基于本地的deepseek-r1:8b模型,使用Python实现一个简单的AI聊天界面-CSDN博客

此文章参考和汇总了他人的博客,并结合自己的实现流程完成的这篇文章,提供一个实现流程的参考。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)