在Windows中通过docker部署deepseek

最近deepseek超级火,简单记录下学习本地通过docker部署deepseek大模型的过程,可以参考这个过程在本地部署玩一玩。Windows配置:NVIDIA RTX 4060 32GBdocker版本:27.1.1。

最近deepseek超级火,简单记录下学习本地通过docker部署deepseek大模型的过程,可以参考这个过程在本地部署玩一玩。

Windows配置:NVIDIA RTX 4060 32GB

docker版本:27.1.1

安装ollama

docker的安装这里就不介绍了,咱们直接来安装ollama吧,ollama 是一款开源工具,旨在让用户在本地计算机上运行大型语言模型(LLM),例如Deepseek、Llama、Gemma等等,跨平台使用,Windows、Linux、Mac上都能下载。

github地址:https://github.com/ollama/ollama

docker部署

C:\Users\ccc> docker run -d -p 11434:11434 --name ollama ollama/ollama

C:\Users\ccc>docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS

PORTS NAMES

28aff6cfc879 ollama/ollama "/bin/ollama serve" 4 days ago Up 6 hours

0.0.0.0:11434->11434/tcp ollama

进入容器,查看ollama用法

C:\Users\ccc>docker exec -it 28aff6cfc879 bash

root@28aff6cfc879:/#

root@28aff6cfc879:/#

root@28aff6cfc879:/# ollama

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.

安装大模型

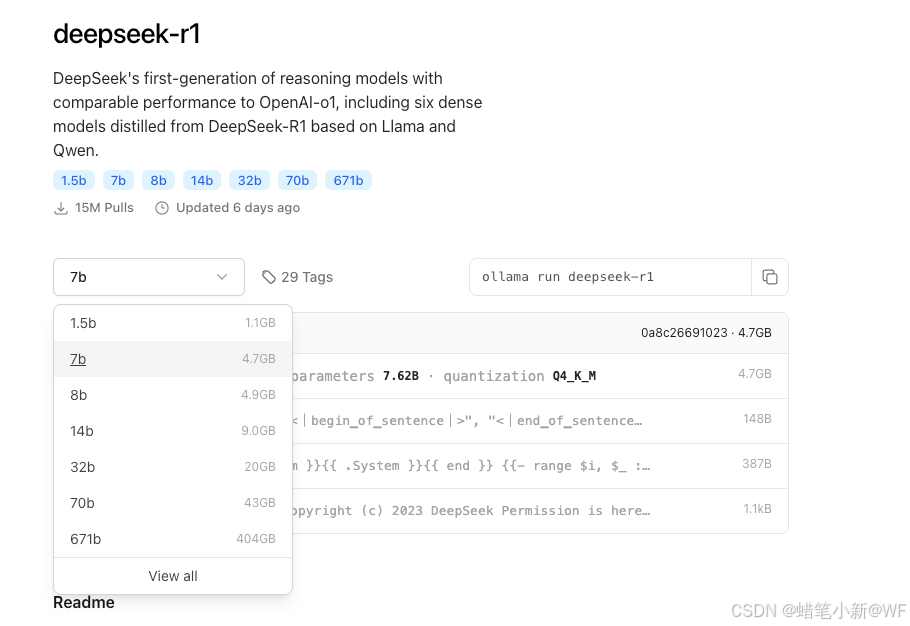

仓库地址:deepseek-r1

下载合适的大模型,我现在这个配置顶多跑个32b的

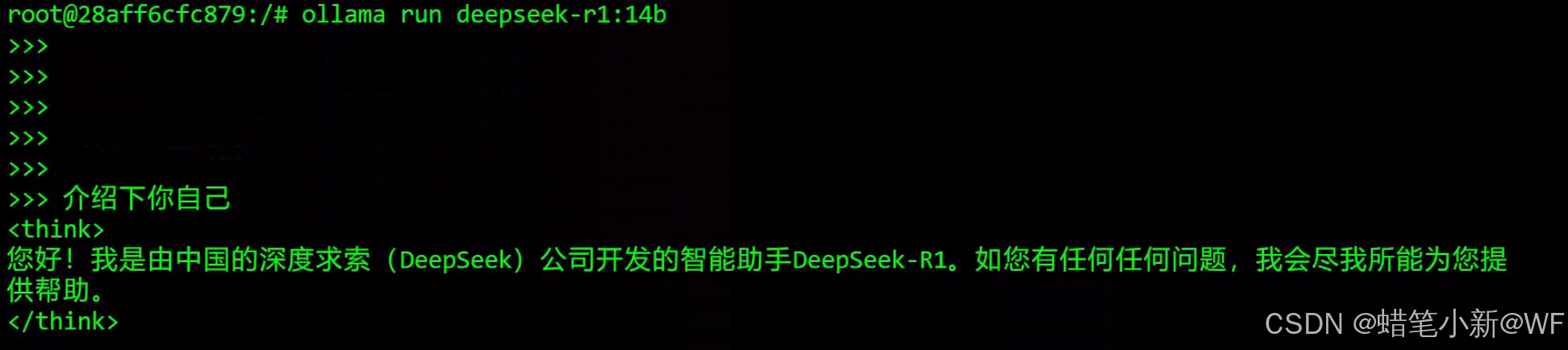

root@28aff6cfc879:/# ollama pull deepseek-r1:14b

下载完成之后可以运行大模型:ollama run deepseek-r1:14b

部署UI

github地址:https://github.com/open-webui/open-webui

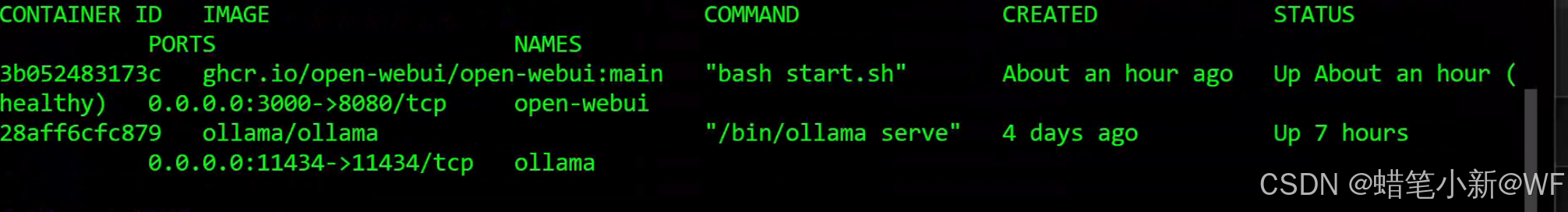

docker run -p 3000:8080 -d --name open-webui --add-host=host.docker.internal:192.168.1.30

-v open-webui:/app/backend/data --restart always ghcr.io/open-webui/open-webui:main--add-host=host.docker.internal:192.168.1.30: 这个192.168.1.30修改成本地的ip地址,一般在cmd控制台可以用ipconfig命令查看,目的是在容器内添加一条解析,把host.docker.internal这个域名解析到本地ip,官网用的是 --add-host=host.docker.internal:host-gateway,咱们可以直接用ip代替host-gateway,避免映射错误

-v open-webui:/app/backend/data: 数据持久化

端口映射自定义,我这用的是官网推荐的3000

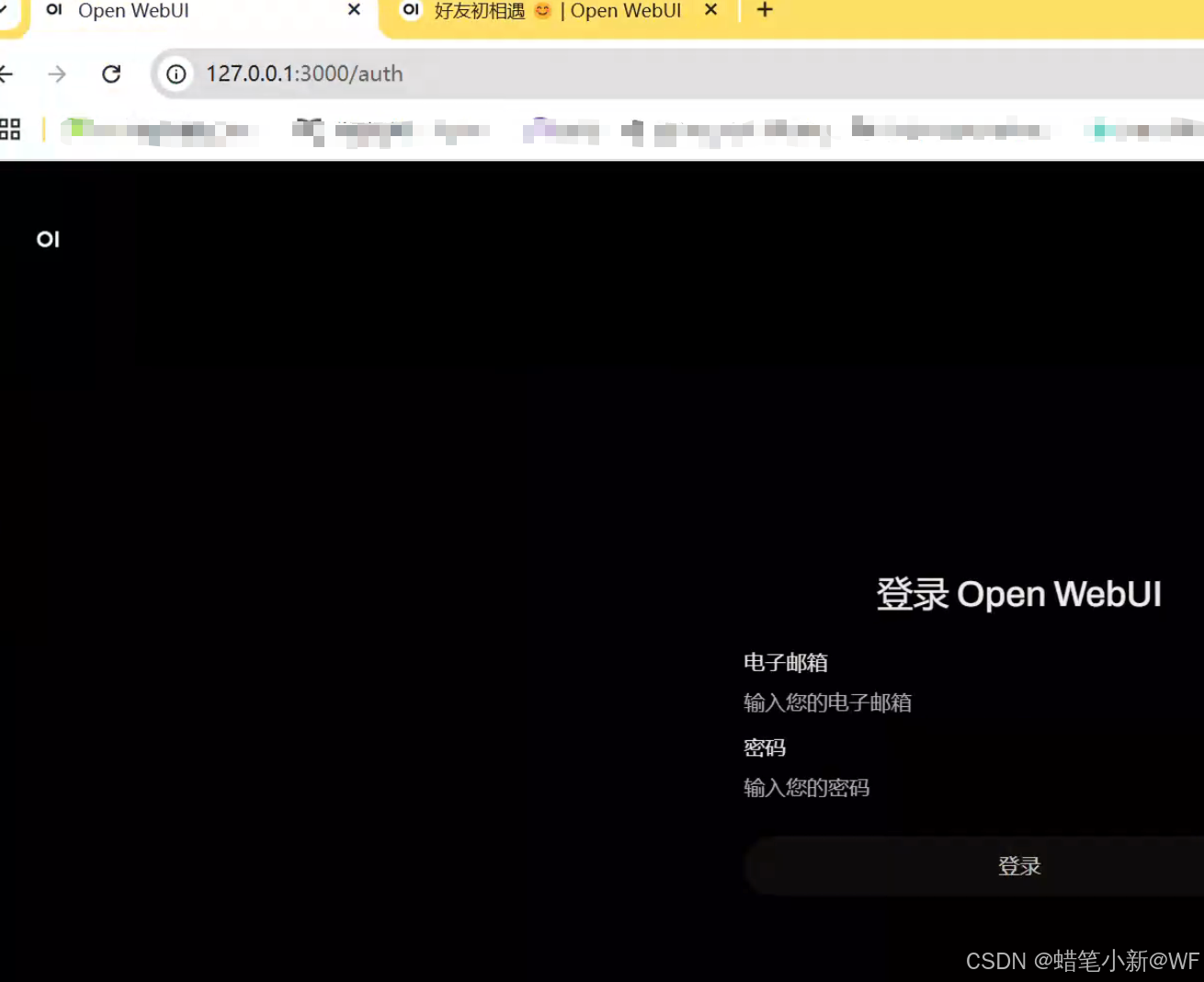

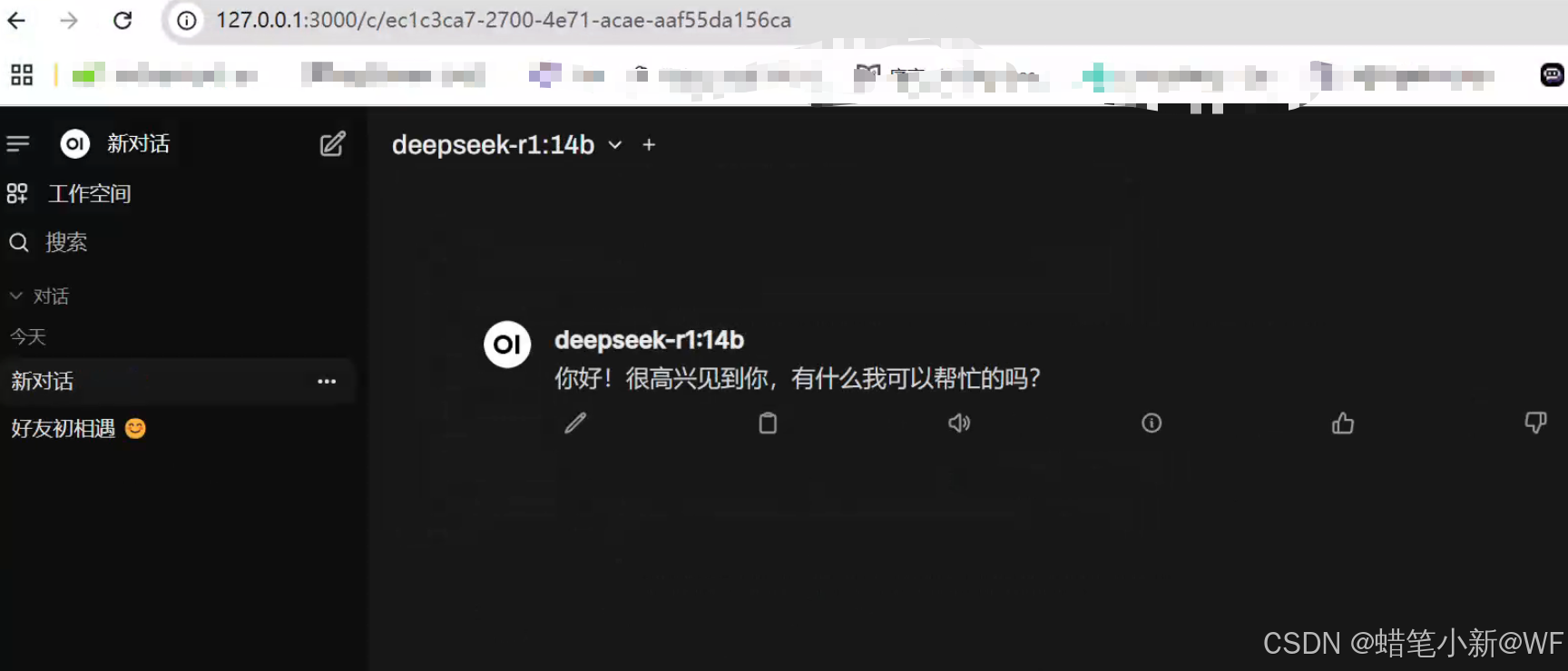

容器Running后,浏览器访问:http://127.0.0.1:3000,我这是注册过了,所以显示登录页面,默认第一次访问先注册账户

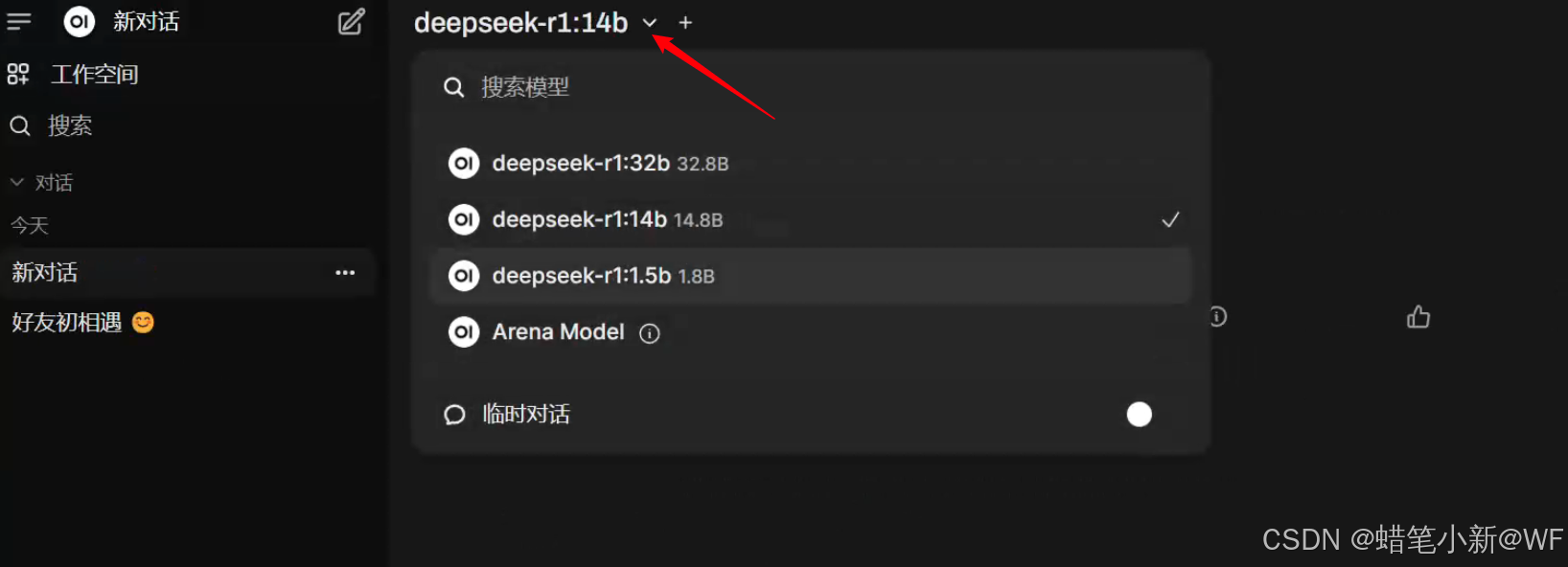

登录之后,选择已下载的大模型,可以建立对话

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)