DeepSeek-R1本地化部署

近期DeepSeek爆火,目前官网服务的不稳定性,成为尝鲜的阻碍。在这里我记录一下自己搭建本地化DeepSeek的经历。

DeepSeek-R1本地化部署

近期DeepSeek爆火,目前官网服务的不稳定性,成为尝鲜的阻碍。在这里我记录一下自己搭建本地化DeepSeek的经历。

安装Ollama(本地大模型引擎)

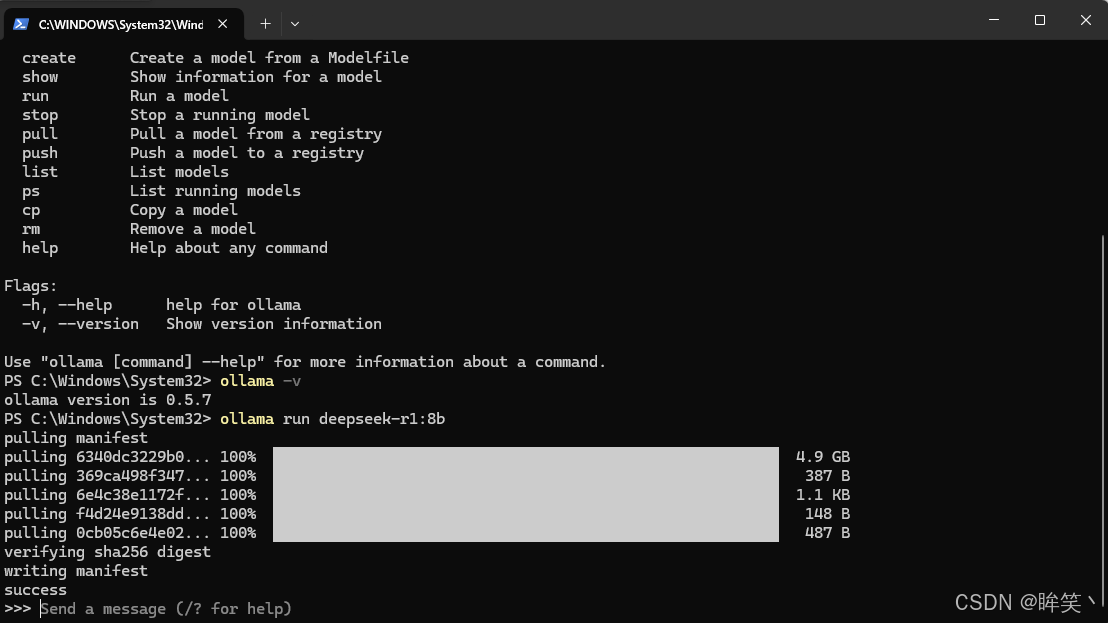

访问ollama官网下载对应版本,安装后执行,该指令会自动拉取模型到本地并部署。支持mac/windows/linux等。我这里是下载的windows版本:

国内用户如果直接下载是会非常慢的,就和我一样,如果不慢就当我没说,可以使用下面的链接来下载镜像网站的版本

https://www.gy328.com/app/ollama/

下载完后直接安装即可,安装完成可以使用命令:

ollama -v

部署本地模型

2025-02-22更新

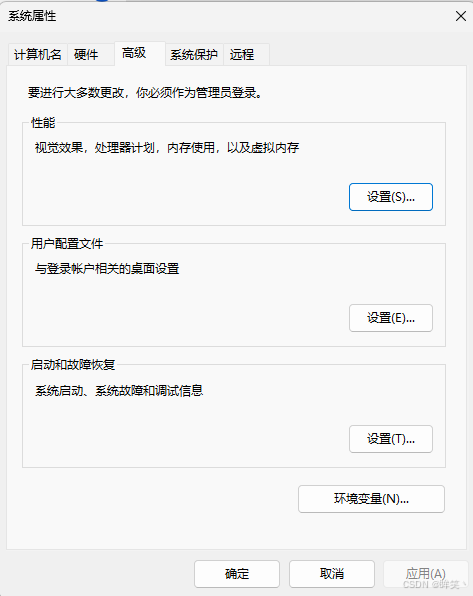

因为我的C盘空间够大,所以没有注意模型是默认安装到C盘的,这里再提供一个方法用于修改模型默认存放的地址,就是通过修改环境变量还改变.

修改ollama模型默认保存地址

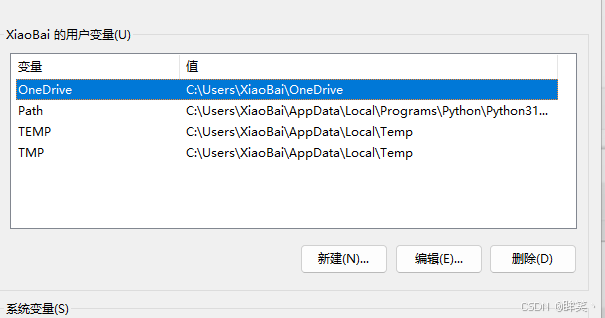

首先进入此电脑的属性,点击高级系统设置

然后点击高级中的环境变量

在环境变量上面的一栏,点击新建

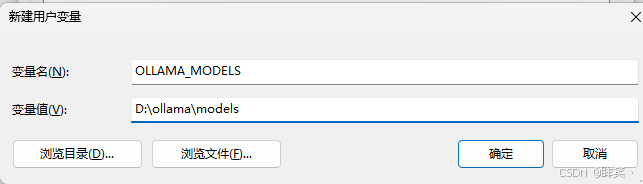

然后再变量名与变量中分别输入如下内容,变量值就是保存的文件夹,这里可以根据你自己的空间来修改文件夹地址,另外注意变量名必须是大写字母.

OLLAMA_MODELS

D:\ollama\models

这里就修改完成了

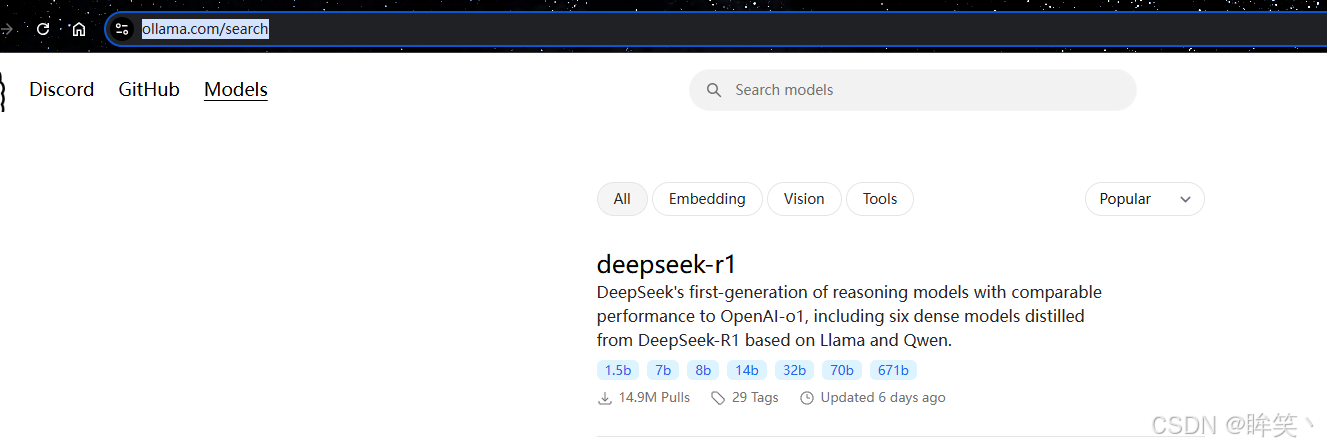

下载模型

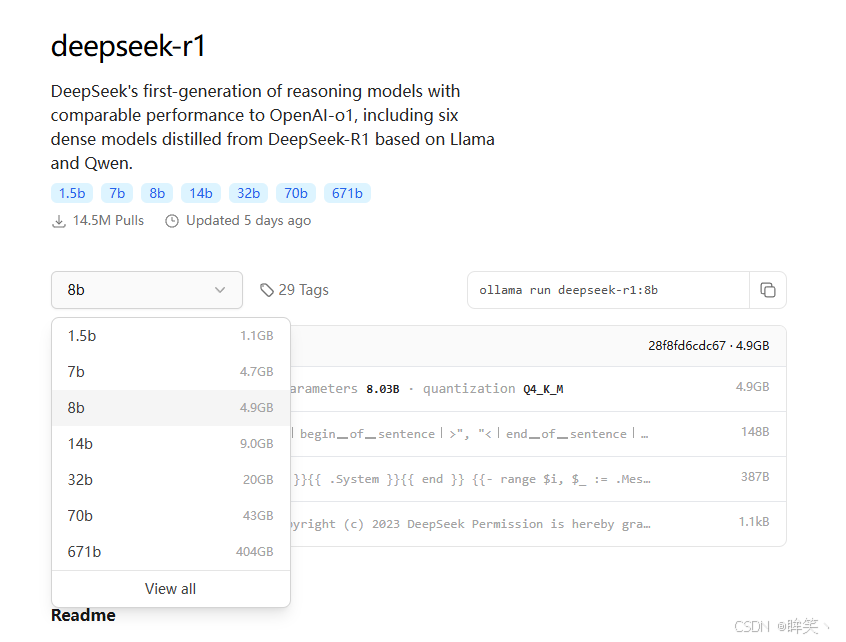

还是官网选择Model选项则会出来模型,搜索到DeepSeek-r1

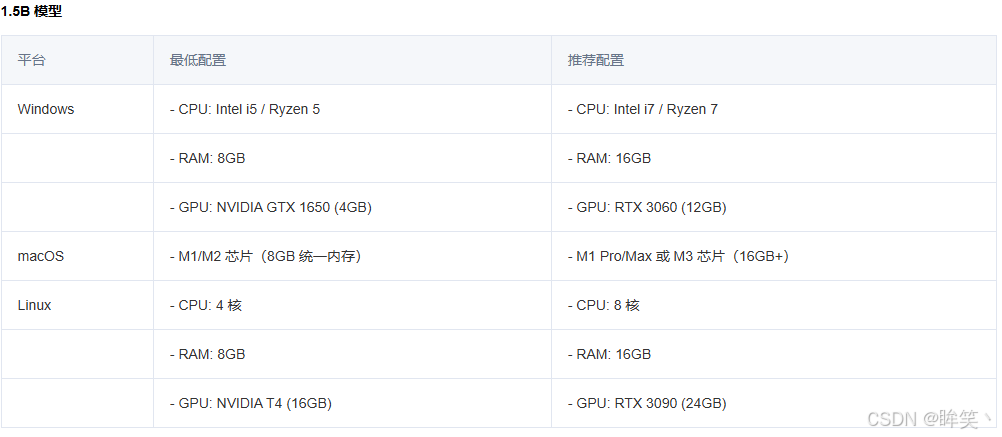

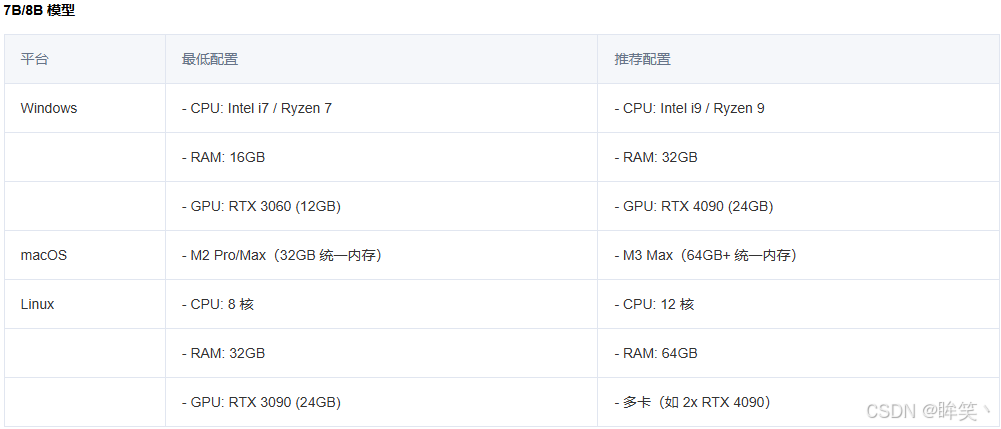

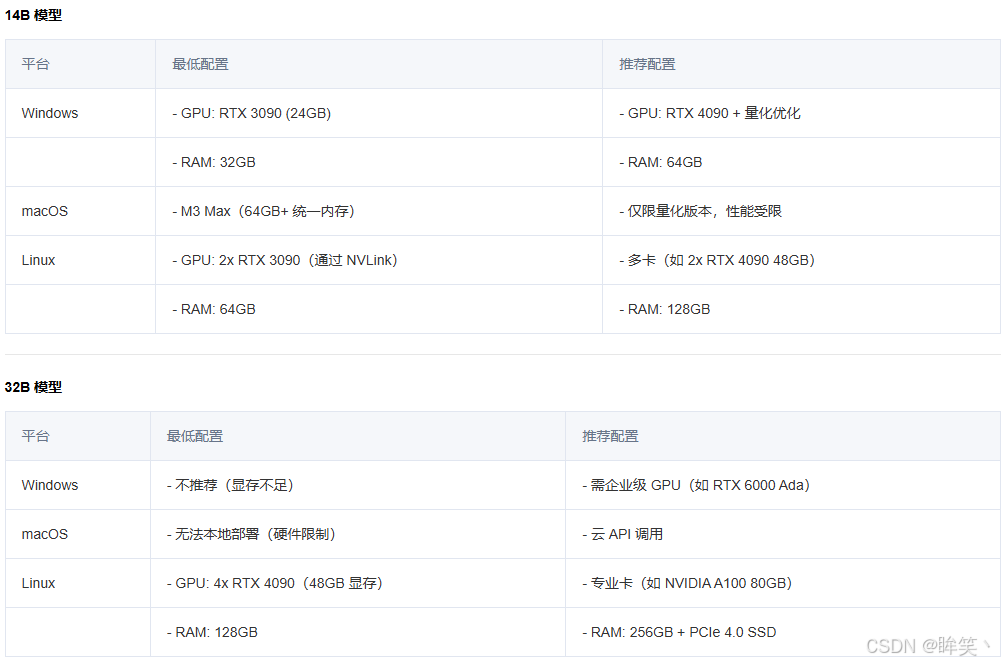

点进去后选择合适的模型,模型与电脑配置请参考下图:

分平台配置建议

以下按模型规模和平台分类,提供 最低配置 和 推荐配置。

我是4070Ti 12G显卡,选择了8b的模型,点击选择框旁边出现的命令:

ollama run deepseek-r1:8b

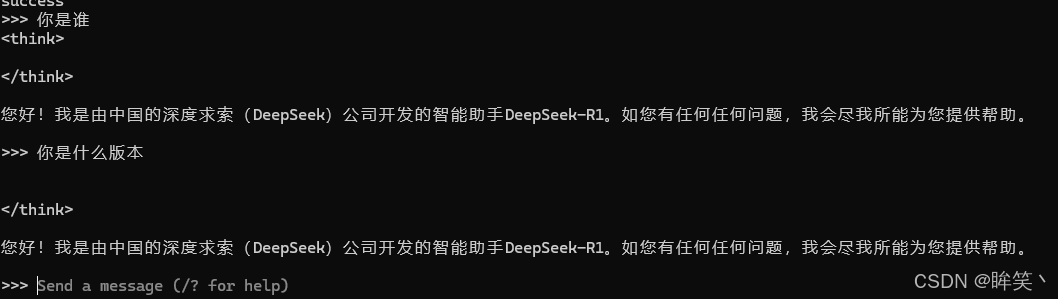

在cmd中输入上面的命令则开始下载,4GB的模型,我下了连个多小时,根据网速决定,如果嫌慢的可以网上搜索镜像的方法.在最后显示Success则为下载成功.

可以发送消息测试是否安装成功

需要注意默认是安装到C盘,请保证盘的空间有足够的大小

UI美化

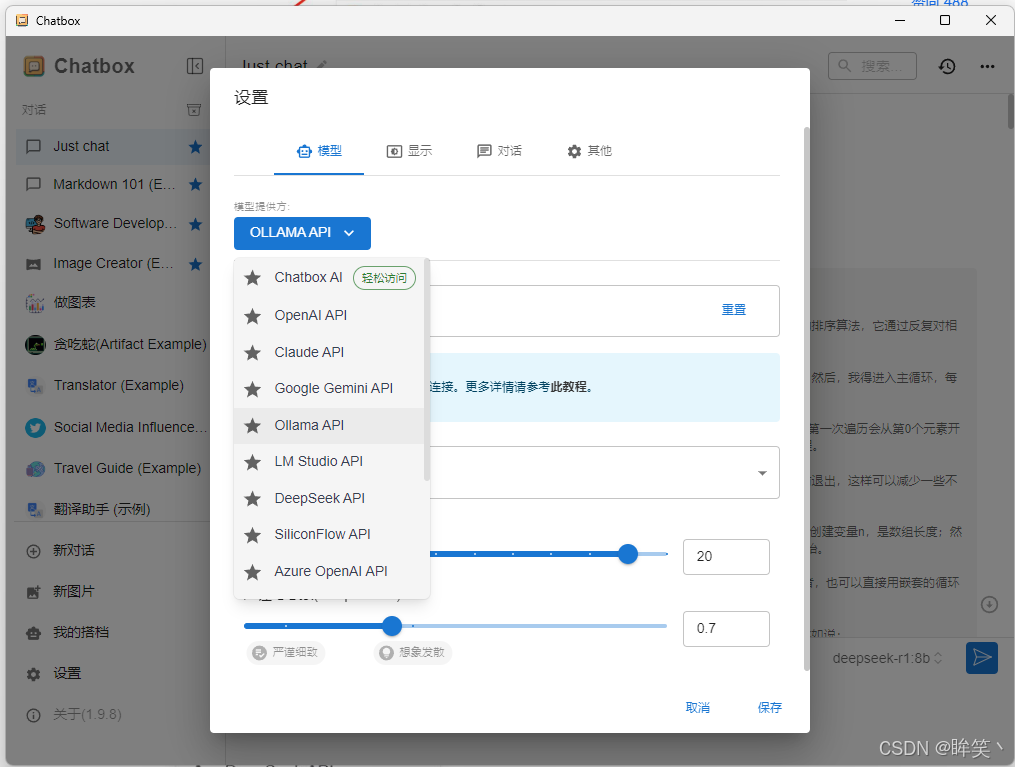

如果觉得使用CMD界面不够美化也不够方便,可以下载Chatbox,这样可以和App一样进行对话.在官网免费下载https://chatboxai.app/zh,下载完成后点击设置 -> 选择OLLAMA API -> 地址为默认-> 模型选择前面下载的模型,然后保存即可

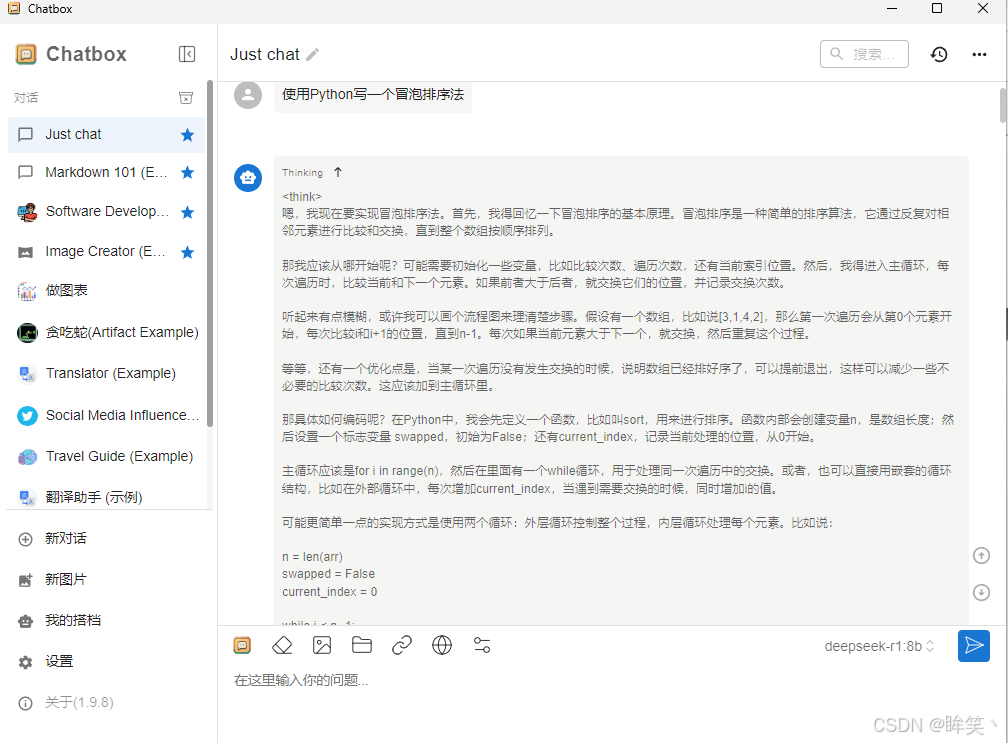

上面就是本地部署的方法,这是就和网页版本的深度思考一样,问一个问题后它会将整个思考流程都写出来.

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)