3分钟接入满血版DeepSeek-R1:字节火山引擎手把手教程!免费50万tokens!

3分钟接入满血版DeepSeek-R1:字节火山引擎手把手教程!免费50万tokens!

最近我的文章都是关于如何把DeepSeek-R1模型用起来的教程。

原因也很简单,DeepSeek官方因为受攻击、算力紧张等原因,动不动就“服务繁忙”。而国内暂时还没有一个其他模型能打得过DeepSeek-R1,所以也就有了这几天的文章。

有本地部署的。

有第三方服务的。

本地部署对于个人用户来说,受到算力资源(主要是GPU)的限制,只能部署小参数模型,适合一般任务。如果不是对数据隐私和安全有强制性的需求,还是非常推荐使用第三方的满血版DeepSeek-R1API服务——模型推理能力强,使用场景广,关键成本还很低。

但API调用本身带有一定的使用门槛,比如今天文章的主角:字节火山引擎版DeepSeek-R1。字节火山引擎不但提供满血版DeepSeek-R1API,还对每个模型赠送免费50万tokens的使用额度,也够使用一阵了。

字节 vs 豆包 vs 火山引擎

开始之前,有必要先理清楚字节、豆包、火山引擎这三者之间的关系。

有一家公司叫字节跳动(ByteDance)。字节自己研发了一款AI大模型叫豆包(Doubao)。基于豆包模型,字节又上线了一个C端用户能直接使用的AI产品——豆包平台。

但豆包平台是面向C端用户的,如何让开发者或者企业用户能直接使用豆包模型,这时,就来了火山引擎。火山引擎提供豆包模型的API服务和底层技术支持,让开发者和企业用户能把豆包模型接入自己的应用和系统里。

不得不说,字节起名“有一套”的。

字节火山引擎版 DeepSeek-R1

https://www.volcengine.com/

作为字节的云服务平台,火山引擎自然懂得跟上“潮流”,不止提供豆包系模型API,还有DeepSeek。

首先按照上面的链接注册登录字节火山引擎平台。然后在顶部导航栏里找到大模型->火山方舟,点击进入火山方舟。

火山方舟首页,点击立即体验。OK,这里就是你获取满血版DeepSeek-R1API key的地方。

这时,你应该会来到火山方舟的模型广场。在模型广场下拉或用关键字搜索的方式找到DeepSeek-R1。注意不要用蒸馏版的非满血模型,即带“Distill”字样的。

鼠标悬浮在DeepSeek-R1模型卡片上,点击立即体验,你就可以在字节的火山方舟在线使用DeepSeek-R1了!

比如我们问它“平头哥”问题。输出速度和回答都没毛病。

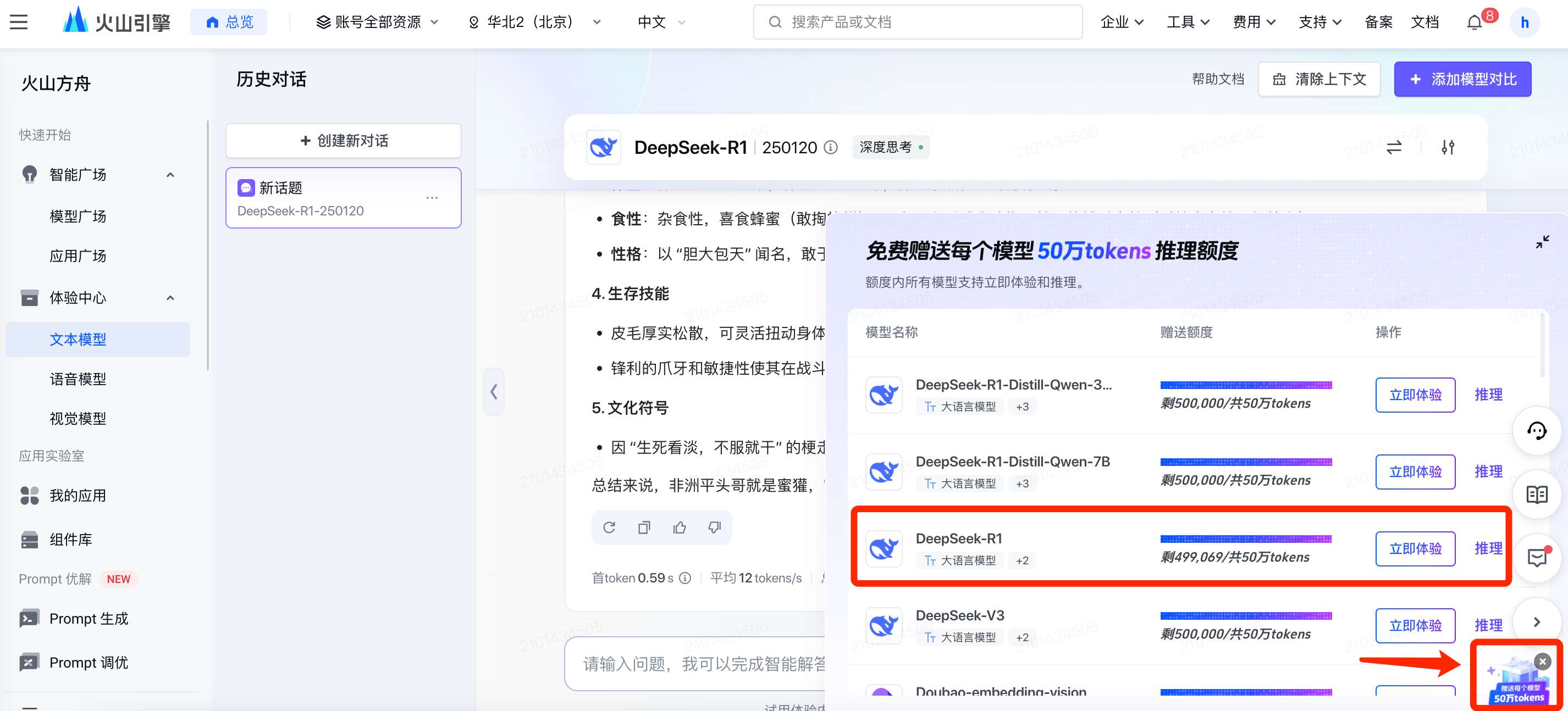

需要注意的是,这里在线体验暂时是免费的,会算在字节发放的50万免费tokens内。

页面右下角会有一个赠送每个模型50万tokens的绚丽小图标,点击后可以查看消耗详情。

故事到这里显然远远没有结束。

火山引擎的API使用方法和其他平台不太一样,所以展开来说一说。

首先在左侧导航栏找到在线推理->然后点击创建推理接入点。

按照页面要求,输入接入点名称,随便输一个就行;模型选择满血版DeepSeek-R1。

此时大概率提示你“该模型未开通,开通后可创建推理接入点”。点击立即开通,在新弹出的页面里勾选上DeepSeek的全部模型,点击同意,然后确认即可。

返回之前那个“推理接入点”创建页面,点击确认接入。

回到在线推理页面,可以看到推理接入点已创建完毕。这里记住:把红框标注的模型id复制下来,后面会用到。

点击右侧的API调用,去创建API key。

点击选择API Key并复制。

我这里已经有一个之前测试豆包API的key了,可以就用这个老的key。

新用户应该点击创建API Key,新生成一个API key,然后点击查看并选择,把这个API key复制下来。

OK,到这一步,即将大功告成。

以Cherry Studio为例,Chatbox同理。

和添加硅基流动API类似,在Cherry Studio的设置,找到豆包,打开开关,把上一步生成的API key复制进去。

最后是最关键的一步——添加模型。

把前面在接入点生成的模型id,添加到豆包的模型列表里。

按照下面这个操作添加就行。

OK,大功告成。

拿这道经典的24点来测试字节火山的DeepSeek-R1。

没问题,这个带除法的24点问题只有满血版能回答正确。

接下来我会继续写一系列关于DeepSeek的使用教程,敬请期待一下。如果你有什么希望我写的题材,也可以在评论区留言投稿,冲!

我是木易,一个专注AI领域的技术产品经理,国内Top2本科+美国Top10 CS硕士。

相信AI是普通人的“外挂”,致力于分享AI全维度知识。这里有最新的AI科普、工具测评、效率秘籍与行业洞察。

欢迎关注“AI信息Gap”,用AI为你的未来加速。

精选推荐

更多推荐

已为社区贡献66条内容

已为社区贡献66条内容

所有评论(0)