ollama+deepseek+ragflow本地化部署知识库大模型配置

(默认c盘安装,安装路径:C:\Users\admin\AppData\Local\Programs\Ollama)1.1配置环境变量:ragflow能访问到:OLLAMA_HOST=0.0.0.0:11434ollama型下载路径:OLLAMA_MODELS=C:\xmx\dseek\OllamaModels 【模型存放路径,可自定义,ollam会根据配置将模型下载到该路径】1.2重启机器。

1.官网下载安装ollama

(默认c盘安装,安装路径:C:\Users\admin\AppData\Local\Programs\Ollama)

1.1配置环境变量:

ragflow能访问到:OLLAMA_HOST=0.0.0.0:11434

ollama型下载路径:OLLAMA_MODELS=C:\xmx\dseek\OllamaModels 【模型存放路径,可自定义,ollam会根据配置将模型下载到该路径】

1.2重启机器

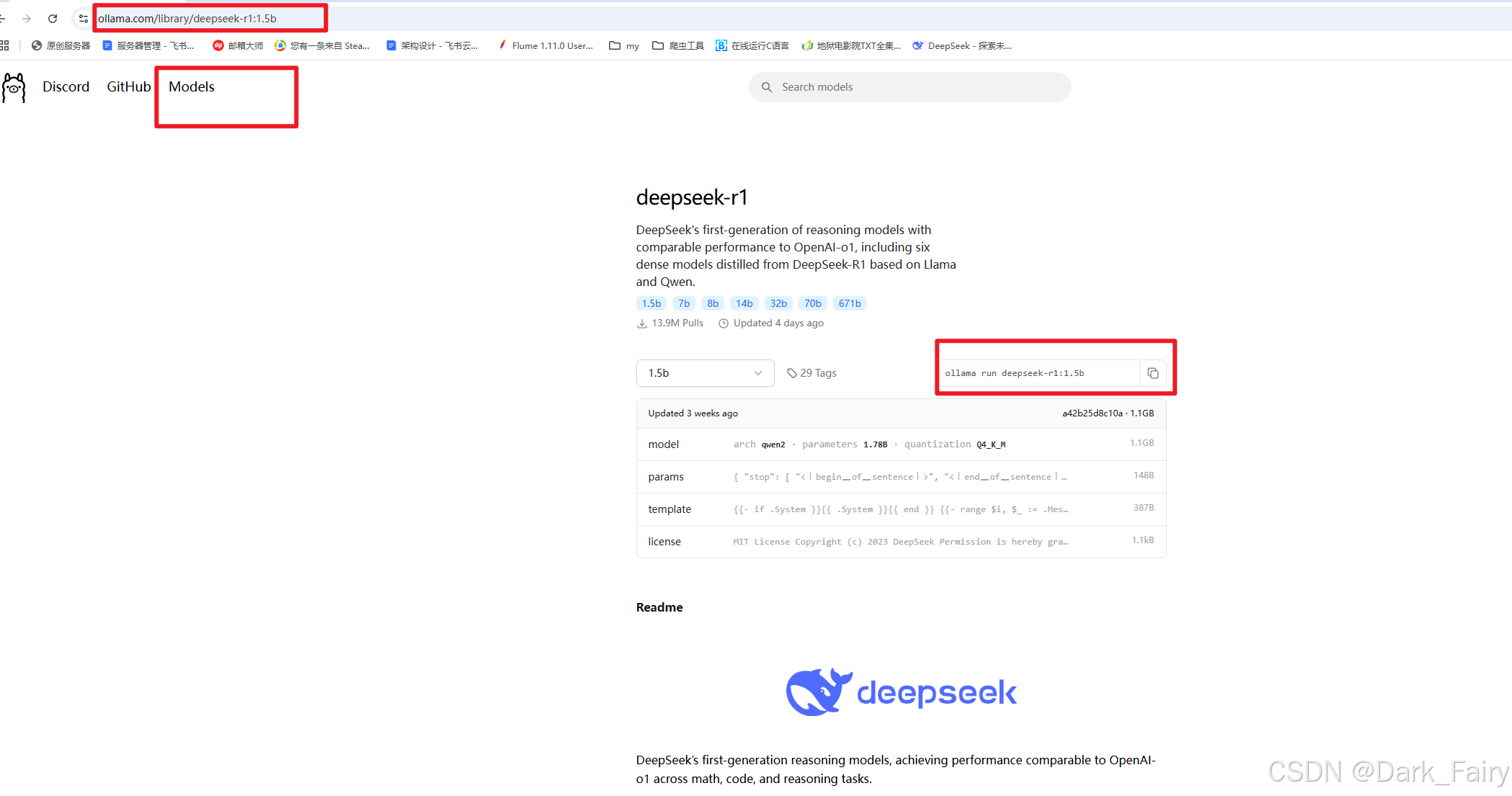

2.ollama官网=》models选择对应的deepseek模型

使用ollama命令下载【时间较长】:ollama run deepseek-r1

3.以上步骤模型下载已完成,输入你好可看见回复:

4.docker部署ragflow

4.1先下载桌面版docker:进docker官网直接下载安装,运行即可

网址:Docker Desktop: The #1 Containerization Tool for Developers | Docker

桌面有docker图标,启动docker:

4.2在github上下载ragflow源代码zip,解压至本地C:\xmx\dseek\目录下

网址:https://github.com/infiniflow/ragflow

修改C:\xmx\dseek\ragflow-main\docker\.env文件,注释掉原有不带 embedding models版本【即slim】,选择非slim镜像

如:

#RAGFLOW_IMAGE=infiniflow/ragflow:v0.16.0-slim

RAGFLOW_IMAGE=infiniflow/ragflow:v0.16.0

4.3docker部署ragflow所需环境:在C:\xmx\dseek\ragflow-main目录下cmd进入命令行执行:

docker compose -f docker/docker-compose.yml up -d

【此时要保证docker已启动,会执行一段时间】

5.执行好后,打开ragflow的web界面: localhost:80 注册登录后创建助理、上传知识库等

5.1注册登录

5.2添加模型

- 模型类型:chat

- 以上模型名称可在命令行输入:ollama list 查看模型名称复制进去即可

- 基础 Url填写:http://你的IP:11434

【注意:ip可在命令行输入ipconfig查看,11434是ollama默认端口,若你修改过,需要改成你修改后的端口,且要和之前配置的环境变量:OLLAMA_HOST=0.0.0.0:11434 保持一致。】

- 最大token书随意填写:如:8888

5.3配置模型

- 在聊天模型中选择已添加的模型名称,其他可以保持默认不变即可:

5.3 上传知识库

- 创建知识库

- 在知识库内上传文件

- 上传一定要点击解析:

- 解析成功才能读取到知识库

- 修改配置:注意语言改成中文

- 最后在检索测试这里输入关键字查看:

5.4 新建助理

- 根据需要修改此处说明:

- 设置你的模型后确定即可:

5.5 创建会话并聊天

6.注意:后续机器重启后需要:

- 打开docker

- 执行命令:docker compose -f docker/docker-compose.yml up -d

7.openapi调用

文档链接:https://github.com/ollama/ollama/blob/main/docs/openai.md

7.1 安装openapi

pip install openai

7.2 python调用

#pip install openai

from openai import OpenAI

client = OpenAI(

base_url='http://localhost:11434/v1/',

# required but ignored

api_key='ollama', # 随便写

)

chat_completion = client.chat.completions.create(

messages=[

{

'role': 'user',

'content': '你好',

}

],

model='deepseek-r1:latest',

)

print(chat_completion.choices[0].message.content)结果:

7.3 接口测试

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)