【MAC】DeepSeek 部署到本地

DeepSeek官网地址。

·

一,DeepSeek 介绍

二,本地运行 AI 模型优势

-

隐私安全:你的所有数据都保留在你自己的机器上,不存在共享敏感信息的风险

-

免费无广:DeepSeek R1 可免费使用,无需订阅费或使用费。

-

灵活控制:无需外部依赖即可进行微调和实验。

-

快速响应:官方及三方访问量过大,延迟非常高,造成卡顿,本地可以避免这种情况。

三,安装流程

1,安装Ollama

直接下载就行了

Ollama官网地址https://ollama.com/ https://ollama.com/

https://ollama.com/

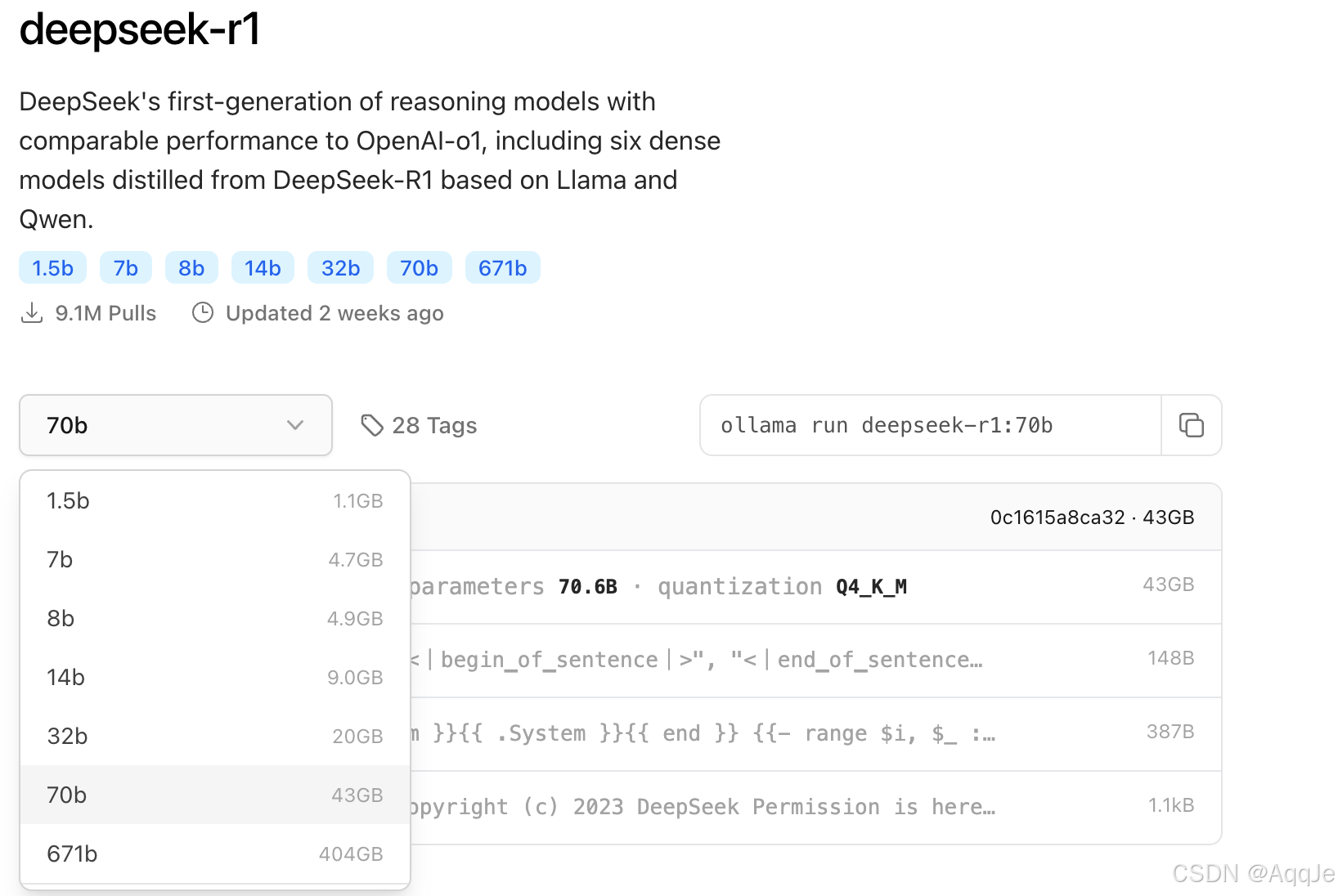

2,拉取 DeepSeek R1 模型

刚开始不必要下载所有模型,可以先下载最轻量的模型 deepseek-r1:1.5b。

后续流程跑通后,再尝试其他高质量模型的能力。

回到 Ollma 官网,点击 Model

ollama run deepseek-r1:1.5b 四、GUI 体验-ChatBox(待续)

四、GUI 体验-ChatBox(待续)

五、如何在MacOS上更换Ollama的模型位置

1,更改Ollama在Mac的环境变量

launchctl setenv OLLAMA_MODELS <你的模型文件夹路径>2,手动复制原来的模块文件

A)复制原来的模块文件

cp -R ~/.ollama/models <你的模型文件夹路径>B)重新启动Ollama APP测试是否正常(退出再重新的打开)

C)确认复制没有问题再删除原来的模块文件

ollama list六、Ollama常见问题文档

ollama/docs/faq.md at main · ollama/ollama · GitHub

七,运行DeepSeek不同模型

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b参考

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)