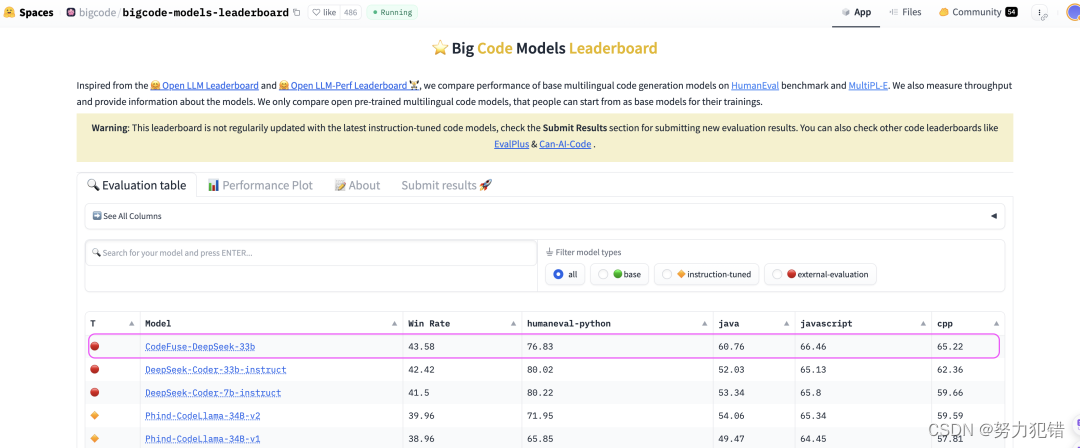

多任务微调框架MFTCoder助力CodeFuse-DeepSeek-33B荣登Big Code榜首

近期CodeFuse新开源模型在Big Code Models Leaderboard代码大模型榜单上荣登榜首,成为代码大模型领域的新焦点。这一成就得益于多任务高效微调框架MFTCoder的强大支持,以及以DeepSeek-Coder-33b模型为基础进行微调的精细策略。

前言

近期CodeFuse新开源模型在Big Code Models Leaderboard代码大模型榜单上荣登榜首,成为代码大模型领域的新焦点。这一成就得益于多任务高效微调框架MFTCoder的强大支持,以及以DeepSeek-Coder-33b模型为基础进行微调的精细策略。

-

Huggingface模型下载:https://huggingface.co/codefuse-ai/

-

AI快站模型免费加速下载:https://aifasthub.com/models/codefuse-ai/

训练数据与超参设置

CodeFuse模型的训练采用了5个不同的下游任务,涵盖代码补全、文本生成代码、单测生成、自然语言表述对齐以及代码练习题,总计约168万样本数据。这种多任务微调策略,借助于MFTCoder框架,实现了任务之间的相互促进,相比于传统的单一任务微调,展现了更优异的性能。微调过程中关键的超参数设置包括多模型适配、多任务并行、均衡Loss设计及PEFT(Lora和QLora)高效微调等,这些高级功能的整合为模型的性能提升提供了坚实的基础。

模型效果评估

CodeFuse-DeepSeek-33b模型在代码能力方面表现卓越,在HumanEval和MBPP测试集上的pass@1指标值分别为78.65%和71%,平均达到74.83%。在多语言代码能力评测集HumanEval-X上,该模型的平均pass@1指标值为67.07%,在多种语言上的表现均超过了先前的模型。此外,CodeFuse模型还在NLP通用能力方面展现了强大的性能,在包括语言能力、推理能力、理解能力、学科综合能力及代码能力在内的18个评测集上进行了全面评估。

模型量化与部署

为了便于模型的生产环境部署,CodeFuse还提供了4bit量化版本的模型,经过量化后的模型在代码补全任务上仅有微弱的性能降幅。通过实际部署测试,量化后的模型在NVIDIA开源的tensorRT部署框架下展现了出色的性能,为模型的应用提供了更多可能。

结论

CodeFuse模型的成功展现了多任务微调策略的强大潜力,以及MFTCoder框架在支持多模型适配和提升微调效率方面的先进性。这一成就不仅推动了代码大模型领域的发展,也为未来模型的训练和部署提供了新的思路和方案。随着模型的开源和量化版本的提供,CodeFuse预计将在代码生成、自然语言处理等多个领域发挥更大的影响力。

模型下载

Huggingface模型下载

https://huggingface.co/codefuse-ai/

AI快站模型免费加速下载

https://aifasthub.com/models/codefuse-ai/

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)