IEDA集成DeepSeek--CodeGPT插件指南 小白一次配好使用!

DeepSeek爆火后,越来越多用户开始对AI产生浓厚的学习兴趣,本文将提供一种方法实现在IDEA中使用DeepSeek模型提升日常的开发效率。

IEDA集成DeepSeek--CodeGPT插件指南 小白一次配好使用!

前言

DeepSeek爆火后,越来越多用户开始对AI产生浓厚的学习兴趣,本文将提供一种方法实现在IDEA中使用DeepSeek模型提升日常的开发效率。

准备DeepSeek API KEY

1.进入 DeepSeek官网链接,注册/登录账号,然后点击API开放平台

2.创建一个API KEY实例,复制API KEY

切记一定要将API KEY复制下来,否则将需要重新创建!

在IDEA安装CodeGPT插件

软件版本:

IntelliJ IDEA 2024.3.1.1

在线市场安装

在IDEA插件市场直接搜索CodeGPT (现搜索 Proxy AI),点击Install安装即可

离线本地安装

从 CodeGPT IDEA插件官网(现名 Proxy AI) 上下载最新的IDEA插件到本地,然后在IDEA插件市场单击齿轮图案,选择Install Plugin from Disk,随后选择刚刚下载好的插件文件即可

配置CodeGPT插件(DeepSeek API)

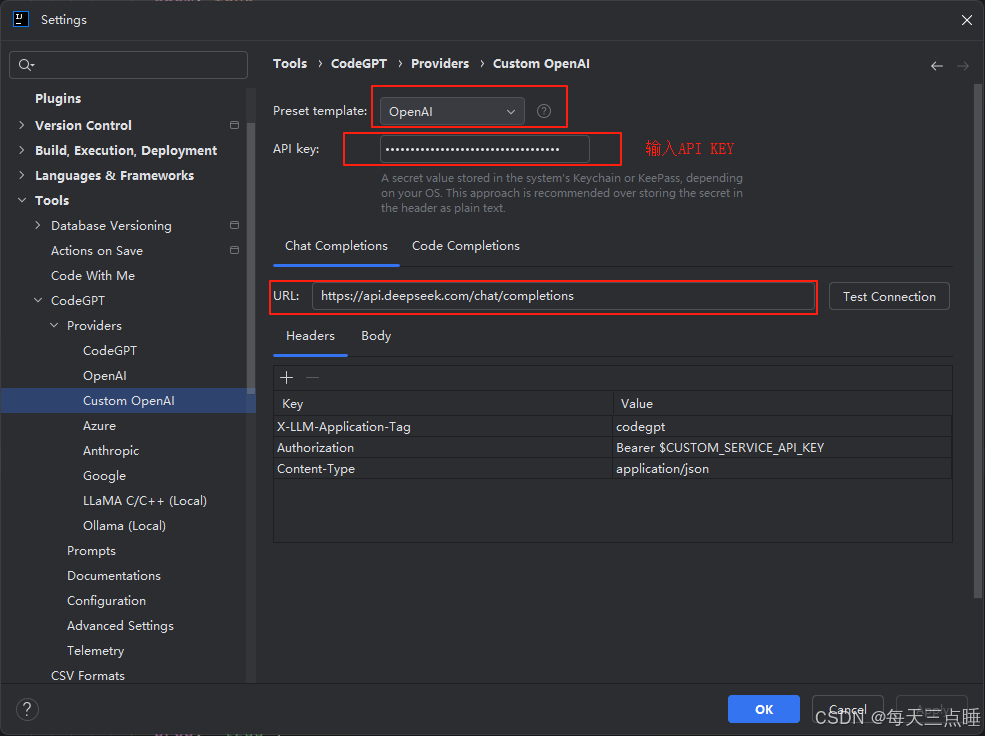

1.打开IDEA设置,选择 Tools>CodeGPT>Providers,将提供源设置为 Custom OpenAI

2.展开Providers,配置Custome OpenAI,将模板设置为OpenAI,将从DeepSeek上创建并复制的API Key输入进去,在URL栏填入 https://api.deepseek.com/chat/completions

3.配置Body参数,将model设置为deepseek-chat或者deepseek-reasoner,max_tokens设置为2048,至此对话模型已经配置完成

4.配置FIM 补全(代码补全)功能,切换到 Code Comlpletions选项卡,将URL设置为 https://api.deepseek.com/beta/completions,设置 Body参数,将 model设置为deepseek-chat,将 max_tokens设置为1024,至此,代码补全功能配置完成

配置中Body其余参数含义可以访问DeepSeek API文档查看进行调整

使用本地DeepSeek模型

如果本地DeepSeek模型使用Ollama部署,仅需在使用CodeGPT时切换提供源就可以使用Ollama的本地模型,需保证Ollama服务正常运行

如果本地的 Ollama 修改过一些配置,可以在 CodeGPT 设置中配置端口等信息

实现效果

DeepSeek API 效果

本地R1模型效果

参考文档

DeepSeek API: DeepSeek API 文档

补充

CodeGPT 新版本支持免费使用DeepSeek,提供源选择 DeepSeek Coder V2–FREE 即可直接使用

2025.02.14 更新 插件名称为Proxy AI

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)