DeepSeek 本地部署实操(Ollama+ChatBox)

年前,国产AI大语言模型 DeepSeek 横空出世,最近很多自媒体啊,也都在宣传本地部署 DeepSeek 有多好有多方便,最近也稍微研究了一下如何使用,仅供参考使用,如有不对请各位大佬指正。

前言

年前,国产AI大语言模型 DeepSeek 横空出世,最近很多自媒体啊,也都在宣传本地部署 DeepSeek 有多好有多方便,最近也稍微研究了一下如何使用,仅供参考使用,如有不对请各位大佬指正。

补充说明

这个本地化部署仅仅作为自己平时玩玩使用的话没有问题,毕竟我们普通用户的硬件配置也没有太高,比如我部署的电脑配置也就是个12600kf+4060ti+32g的低配游戏主机,估计跑个14b就差不多了,再往上连跑就很勉强了。

同时和大家说明一点,官网版(或者APP版)的 DeepSeek 使用的是满血版的大模型,我们用的这个 7b,8b,14b 版本的也就是阉割版,说白了就是蒸馏版(基于R1模型学习的版本)。本次演示安装的是8b的版本,至于为什么不推荐使用 7b,8b呢?是因为再往下的就纯属傻子版本(个人感受勿喷)

如果想体验完整版本的真的建议去官网或者下载APP,本地部署真就是图一乐,如果想使用满血的还没办法使用官网版本的,可以去华为,英伟达的官网,或者像curser内置,硅基流动,秘塔AI,国家超算中心等那里都有准备好的R1环境可以供我们使用。也就是说,如果基于我们的本地配置,能够使用的一定都是其他架构的蒸馏版R1。 网上(主要是dy)要是教你用,还只用7b往下的纯纯割韭菜行为各位注意避坑,花钱就更是大冤种。

本实操使用的是 ollama+chatbox 方案进行本地部署。

部署

安装Ollama

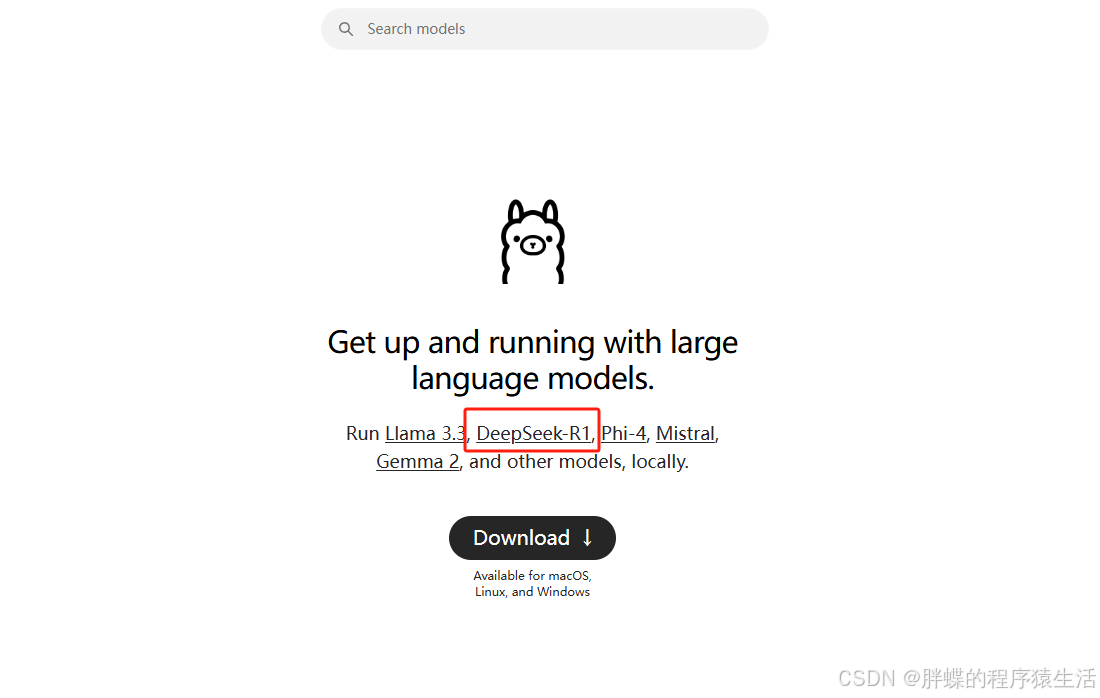

进入官网下载界面:https://ollama.com/download

选择自己的操作系统并下载安装即可。

回到主页,点击 DeepSeek-R1 的标签

这里我们能看到各种版本的模型,和所需要的硬盘空间。硬盘够用且显存足够足够足够大的可以考虑671b

下载好了直接安装即可

修改环境变量

由于 Ollama 默认安装模型是在C盘,考虑到很多用户C盘空间不乐观,可以将模型文件的默认路径改为自己想要的位置。

首先Win搜索环境变量打开 系统属性 界面:

点击 高级 标签下面的 环境变量

点击 新建

变量名:OLLAMA_MODELS

变量值:你想要放置模型的目录,我这里是 D:\OLLAMA_MODELS

注意:设置完环境变量以后需要重新启动电脑才能生效。

验证安装

打开cmd,输入ollama查看指令

如图所示,有ollama相关的命令即为安装成功。

下载模型

打开cmd,输入ollama run deepseek-r1:8b

他这里就会自动下载你所需要的模型,我们这里使用8b作为演示,静静等待他下完就好。

下载 ChatBox

ChatBox AI官网地址:

https://chatboxai.app/zh

点击下载并安装

安装完成打开软件

使用ChatBox

点击下面的

使用自己的 API Key 或本地模型按钮

直接选择

Ollama API

API域名这里不用做任何更改,默认就是11434端口

模型这里直接选择刚刚下载好的模型,并点击保存即可使用

到这里就 ok 了,截至目前为止,DeepSeek开放了API接口,也可以去官网申请一个API Key,像别的大模型一样可以在CherryStudio等AI平台上使用。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)