企业级AI客服搭建指南:融合本地DeepSeek与MaxKb实现基于私有知识库的精准问答

本文为企业提供了一份详细的AI客服搭建指南,介绍了如何融合本地部署的DeepSeek大语言模型与MaxKB知识库问答系统,实现基于私有知识库的精准问答服务。通过本地部署,企业能够确保数据的安全性和隐私性,同时利用DeepSeek的强大语言处理能力和MaxKB的高效知识管理功能,提升客服效率和用户体验。文章详细阐述了系统架构设计、模型训练与优化、知识库构建与维护、以及系统集成与部署等关键步骤,帮助企

一、本地部署DeepSeek模型

1、安装ollama

步骤一:点击打开ollama官网。

步骤二:点击Download下载ollama,选择Windows版本进行下载。

步骤三:双击ollama安装版进行安装。

步骤四:Windows+R输入cmd调出命令行窗口,输入ollama -v,如果显示ollama的版本,则安装成功。

2、部署DeepSeek R1模型

步骤一:打开ollama官网,点击坐上叫的Models。

步骤二:点击DeepSeek R1模型。

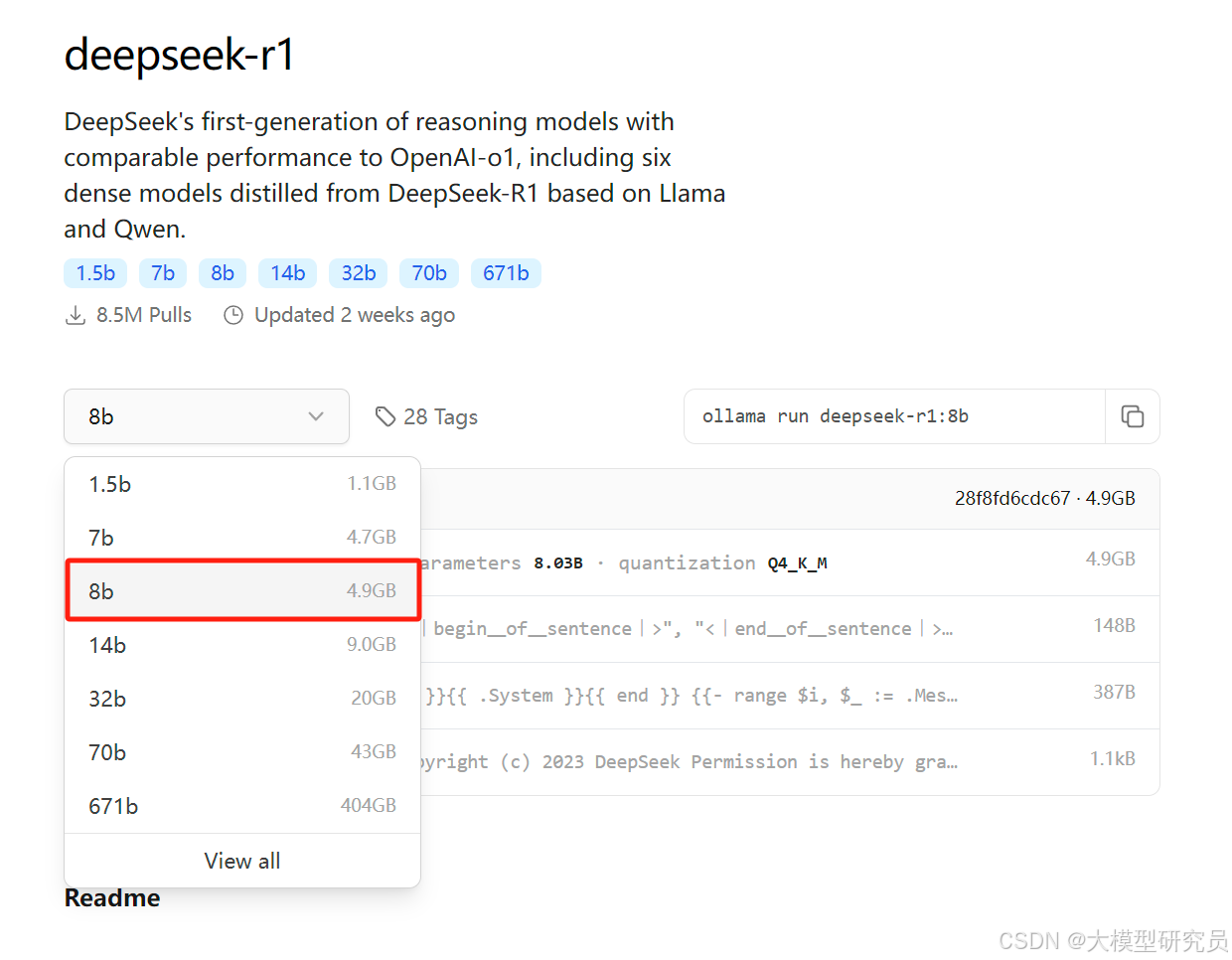

步骤三:根据自己电脑的显存大小选择合适的版本,我的电脑是8G显存,这里选择8b的模型。

步骤四:点击复制右侧安装命令,进入命令行运行。

显示success并能回复表示安装成功。

3、退出与运行DeepSeek指令

在命令行窗口输入/bye即可退出。下次启动DeepSeek需输入ollama list查看已经下载的模型,ollama run +模型名字就可以再次进入对话。

4、安装Chatbox实现DeepSeek模型可视化对话

步骤一:点击进入Chatbox官网,下载软件,选择安装目录进行安装。

步骤二:打开软件点击设置,在设置中选择ollama API。

步骤三:在模型选择中选择下载好的deepseek-r1模型,点击保存,就可以进行对话了。

二、MaxKB的部署与安装

1、MaxKB简介

MaxKB 是一款基于大语言模型(LLM)和检索增强生成(RAG)技术的开源知识库问答系统,旨在为企业和组织提供高效、智能的知识管理与问答服务。

核心功能:

1、开箱即用:支持直接上传文档或自动爬取在线文档,自动完成文本拆分、向量化处理以及 RAG 处理,有效减少大模型幻觉,提升问答准确性。提供一键部署功能,通过简单的命令即可完成安装。

2、模型中立:支持对接多种大语言模型,包括本地私有模型(如 Llama 3、Qwen 2 等)和国内外公共模型(如 OpenAI、百度千帆、智谱 AI 等)。

3、无缝嵌入:支持零编码快速嵌入到第三方业务系统,如企业微信、钉钉、飞书、微信公众号等,快速提升现有系统的智能问答能力。

2、MaxKB的安装

步骤一:点击进入docker官网,选择下载docker桌面版,下载完成后双击图标即可安装。

步骤二:安装完成后,Windows+R输入cmd打开命令行窗口,点击打开MaxKB的github页面。在快速开始页面复制docker安装指令,粘贴到命令行窗口运行。

步骤三:安装完成后打开docker镜像,将镜像跑起来点击8080端口打开登陆界面,输入文档给出的账号和密码。

步骤四:点击知识库选项,将本地的知识库上传,根据知识库的内容书写知识库描述。

步骤五:创建成功后上传文档,开始导入。

步骤六:点击应用,创建应用,在选择模型中添加本地部署的DeepSeek-r1模型。

步骤七:选择ollama供应商,填写模型名称,输入您本地部署 Ollama 服务的 API 地址,通常在 Docker 环境下应为 http://host.docker.internal:11434,确保可以正常访问该地址。API key可随意填写。

步骤八:模型添加完成后即可选择模型,并添加关联知识库,最后保存并发布即可使用。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)