DeepSeek很卡?还在用Ollama傻傻本地部署DeepSeek?教你一招流畅访问DeepSeek!

DeepSeek的这波操作不仅引发了硅谷的震动,更让老美感受到了前所未有的威胁,就连美国芯片巨头英伟达一夜市值蒸发5900亿美元,合4.3万亿人民币,台积电、博通公司、超微半导体等科技股也遭遇集体暴跌。你攻任你攻,咱就是头铁,国产AI雄起,相比Open AI在资金和人力不充足的情况下,做出这个效果已经是啪啪打脸老美了,希望后续继续做大做强。

序言

DeepSeek最近可谓是春节爆火,除了承接泼天的用户流量外,也引发不少外部攻击,不少同学使用深度搜索都会碰到服务繁忙,明明这么好用,却玩不了,好气!

既然官网访问不了,不少网友便开启了新思路,本地整一个,于是出现了Ollama + ChatBox这一波骚操作。

Ollama 是一个开源的本地大型语言模型服务工具,旨在简化在本地运行、管理和交互大型语言模型的过程,该工具已经支持最新deepseek-r1模型。

但是这种方式有个缺点!本地硬件配置不够啊,下面是推荐的显卡和CPU配置。

就我这GPU,下个7b的模型也能勉强跑跑,这种方案可以过度一下。

既然要用,就用最好的模型,今天教大家用另外一种方式流畅使用DeepSeek R1(671B)大模型,使用超级简单。

一、使用指南

最近硅基流动与华为云联手推出革命性DeepSeek R1&V3推理服务,有了软硬件支持,DeepSeek整起来妥妥的。

1、注册账号

前往硅基流动主页,直接通过手机号即可注册账号(PS:为这个验证码图片还整了好几次)。

点进去,看到DeepSeek首居第一,DeepSeek-R1和DeepSeek-V3模型都能用,而且参数都为671B的。

点击文本对话,即可开始使用R1模型,是不是很简单。

注册完后,官方会送14元的额度,目前使用DeepSeek的价格如下:

- 输入:

¥4/ M Tokens. - 输出:

¥16/ M Tokens.

14块钱也能用很久了,如果额度用完可以点击余额充值,需要实名认证。

2、本地客户端便捷访问

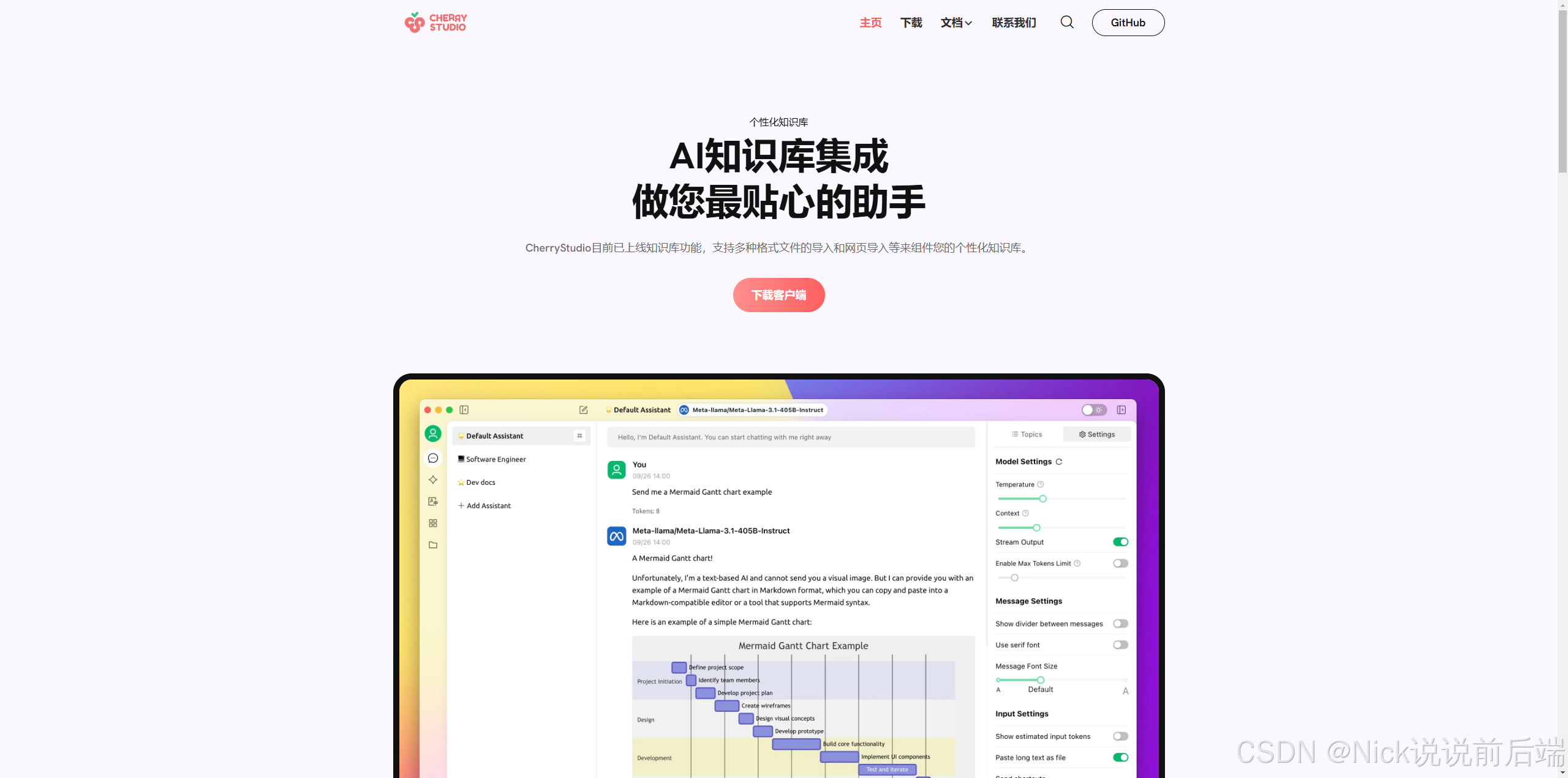

上面这种方式每次都要登录硅基流动官网,而且聊天框不支持传文件,我们可以通过Cherry Studio客户端访问硅基流动上的AI模型。

2.1 下载Cherry Studio

点立即下载如果没生效,可以点击 百度网盘下载,或者点击右上角Github下载客户端。

网盘下载:

Github下载:

备注:Github没有开启魔法可能访问比较幔。

2.2 配置API Key

点击硅基流动API 密钥,右上角新建密钥,复制这个密钥。

打开安装好的Cherry Studio,按下图的步骤配置即可。

接下来,就可以愉快地使用DeepSeek了,而且该客户端还能传附件,总体使用流畅,美滋滋。

如果发现访问失败,需要核对API密钥是否配置正确,不行多刷新几次,或者重启客户端。

备注:重要的事情说三遍,不要开魔法,不要开魔法,不要开魔法,不然铁定不能使用。

二、使用体验

虽然没有官网响应那么快,但是比起不能访问,这个速度也是能接受的,毕竟相比GPT和其它第三方渠道,价格也算良心了。

三、结语

DeepSeek的这波操作不仅引发了硅谷的震动,更让老美感受到了前所未有的威胁,就连美国芯片巨头英伟达一夜市值蒸发5900亿美元,合4.3万亿人民币,台积电、博通公司、超微半导体等科技股也遭遇集体暴跌。

你攻任你攻,咱就是头铁,国产AI雄起,相比Open AI在资金和人力不充足的情况下,做出这个效果已经是啪啪打脸老美了,希望后续继续做大做强。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)