斩获 66K 星!这 2 个开源项目绝了。

01用旧手机搭建 AI 集群你是否曾想过,将家中闲置的 iPhone、安卓手机、iPad 甚至笔记本电脑“变废为宝”,组成一个强大的 AI 集群,运行类似 DeepSeek 的大型语言模型?开源项目 Exo 就是做这个事情的,无需昂贵的 NVIDIA 显卡,只需几台日常设备,即可构建分布式 AI 计算网络,轻松玩转 Deepseek、LLaMA、Mistral 等前沿模型。Exo是什么?Exo..

01

用旧手机搭建 AI 集群

你是否曾想过,将家中闲置的 iPhone、安卓手机、iPad 甚至笔记本电脑“变废为宝”,组成一个强大的 AI 集群,运行类似 DeepSeek 的大型语言模型?

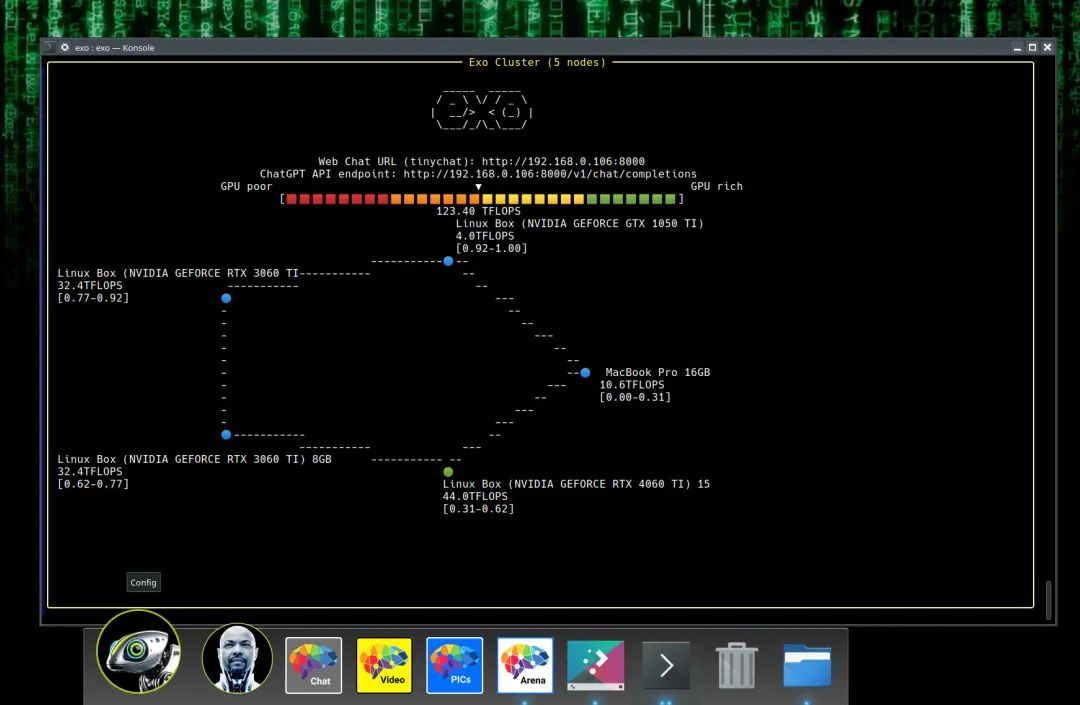

开源项目 Exo 就是做这个事情的,无需昂贵的 NVIDIA 显卡,只需几台日常设备,即可构建分布式 AI 计算网络,轻松玩转 Deepseek、LLaMA、Mistral 等前沿模型。

Exo是什么?

Exo 是由 exo labs 团队开发的开源项目,目标是通过动态模型分区和自动设备发现技术,将异构设备(如手机、平板、电脑)整合成分布式 AI 集群,支持运行超出单设备能力的大型语言模型。其核心特点包括:

1. 低成本:无需专业 GPU,利用现有设备的算力即可运行模型。

2. 动态分区:根据设备内存和网络拓扑,自动划分模型层数到不同设备,优化资源利用率。

3. 去中心化:采用 P2P 架构,避免传统主从模式下的单点故障问题,所有设备平等参与计算。

4. 易用性:提供 ChatGPT 兼容的 API 和 WebUI,用户可通过简单命令或接口与模型交互。

五大亮点功能

1. 广泛的模型支持

Exo 支持 LLaMA、Mistral、LlaVA、Qwen、Deepseek 等多种主流模型,用户可根据需求灵活选择。例如,使用`exo run llama-3.2-3b`即可在单设备上启动 LLaMA 模型,或通过多设备集群运行更大规模的70B参数模型。

2. 自动设备发现与动态分区

只需在每台设备上运行`exo`命令,系统会自动发现并连接其他设备,无需手动配置网络。Exo 默认采用环形内存加权分区策略,根据设备内存比例分配模型层数,实现高效推理。

3. 开发者友好

-

API集成:通过 `http://localhost:52415` 提供的 ChatGPT 兼容 API,用户可直接用 curl 发送请求,轻松集成到现有应用中。

-

调试工具:支持环境变量调试(如`DEBUG=9 exo`)和日志分析,方便开发者排查问题。

4. 跨平台兼容性

Exo支持 iOS、Android、Mac、Linux 等多种系统,甚至可通过蓝牙或无线网络连接设备。不过需注意,iOS 版本因 Python 兼容性问题暂未公开发布,需联系团队申请测试权限。

开源地址:https://github.com/exo-explore/exo02

Open WebUI:打造你的专属AI助手

Open WebUI 提供一个用户友好的界面,用于与本地部署的大型语言模型进行交互。它支持多种 LLM 运行器,包括 Ollama 和兼容 OpenAI 的 API 。

通过 Open WebUI,你可以轻松地搭建一个私有的 AI 助手,并根据自己的需求进行定制。目前已经获得了 66.6k 的 Star!

项目优势:

本地化部署:Open WebUI 可以部署在你的本地服务器上,这意味着你的数据将始终保持在你的控制之下,无需担心数据隐私问题 。

灵活性和可定制性:Open WebUI 支持多种 LLM 运行器,你可以根据自己的需求选择最合适的模型。此外,你还可以自定义界面和功能,以满足你的特定需求 。

易于使用 Open WebUI 提供了一个简单易用的界面,即使没有技术背景的用户也可以轻松上手 。

应用场景:

私有 AI 助手:你可以将 Open WebUI 部署在你的本地服务器上,并使用它来创建你自己的 AI 助手,用于完成各种任务,例如文本生成、问答、翻译等等 。

知识库和 artifacts:Open WebUI 可以用于构建知识库和 artifacts,并使用 LLM 来进行搜索和查询 。

AI 搜索:Open WebUI 可以与搜索引擎集成,以提供更智能的搜索结果 。

实时自定义语音聊天:Open WebUI 可以用于构建实时自定义语音聊天应用程序,例如虚拟助手 。

开源地址:https://github.com/open-webui/open-webui03

点击下方卡片关注我

这个公众号历史发布过很多有趣的开源项目,如果你懒得翻文章一个个找,你直接和逛逛 GitHub 对话聊天就行了:

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)