5步搞定!人人都会的Ollama+DeepSeek+chatBoxAI本地安装秘籍

5步搞定!Ollama+DeepSeek本地安装秘籍,本文教会大家用ollama+chatBoxAI部署本地化的deepseek私有大模型。

5步搞定!人人都会的Ollama+DeepSeek+chatBoxAI本地安装秘籍

1 步骤总览

下载部分

- 安装ollama

- 使用ollama安装deepseek蒸馏大模型

- 安装chatBoxAI

部署部分

- 开始在本地命令行运行

- 可视化运行deepseek

2 安装ollama

Ollama是一个开源的 LLM(大型语言模型)服务工具,用于简化在本地运行大语言模型,降低使用大语言模型的门槛,使得大模型的开发者、研究人员和爱好者能够在本地环境快速实验、管理和部署最新大语言模型。

访问ollama官网https://ollama.com/download,根据你的电脑环境下载对应操作系统的ollama软件,下载完成后直接安装。

3 使用ollama安装deepseek的蒸馏大模型

3.1 进入模型下载界面

点击ollama网站上的Models,跳转到ollama的模型列表界面,ollama目前支持包括deepseek、Llama 3、Phi 3、Mistral、Gemma等在内的多种开源的大型语言模型。

点击deepseek-r1进入deepseek-r1的下载界面。可以看到目前支持的deepseek的蒸馏模型有以下这些,这个页面也可以找到所有的deepseek模型安装指令。

3.2 模型安装

在ollama中安装deepseek是采用命令行的形式进行下载和运行的。

- 打开 Windows PowerShell(管理员)或终端管理员。

- 输入以下命令下载模型(以 8B 版本为例)

- 如果ollama已经安装了这个版本的deepseek,那么就会直接执行。

- 国内部分网络环境无法一次性完成下载可以采取两种办法,

- ①一种办法是按

ctrl+C取消后重新执行该命令。 - ②另一种办法修改网络DNS为

1.1.1.1再进行下载。 - 如果还不行的话,可以看看

https://github.com/ollama/ollama/issues/6211这里的其他解决办法。

- ①一种办法是按

ollama run deepseek-r1:8b

- 运行命令

- 运行结束后:

按ctrl+D或者输入/bye就可以退出模型

3.3 查看本地离线模型

- 安装完成后可以随时查看当前本地安装了多少的离线模型。

ollama list

4 本地命令行运行

在本地运行刚才的安装命令

ollama run deepseek-r1:8b就可以进入到大模型对话界面,现在也是新年,我在这里写一首新年的七言绝句,出来的效果如下。可以看到同样是deepseek-r1模型,由于处理节点能力多少的不同,出来的效果是不一样的,因此自身操作环境如果能支持更高的模型配置,建议大家安装更高的模型配置。

-

输入问题

我想写一首祝贺新年的7言绝句,请直接给我结果。 -

8b蒸馏模型输出结果

- 1.5b蒸馏模型输出结果

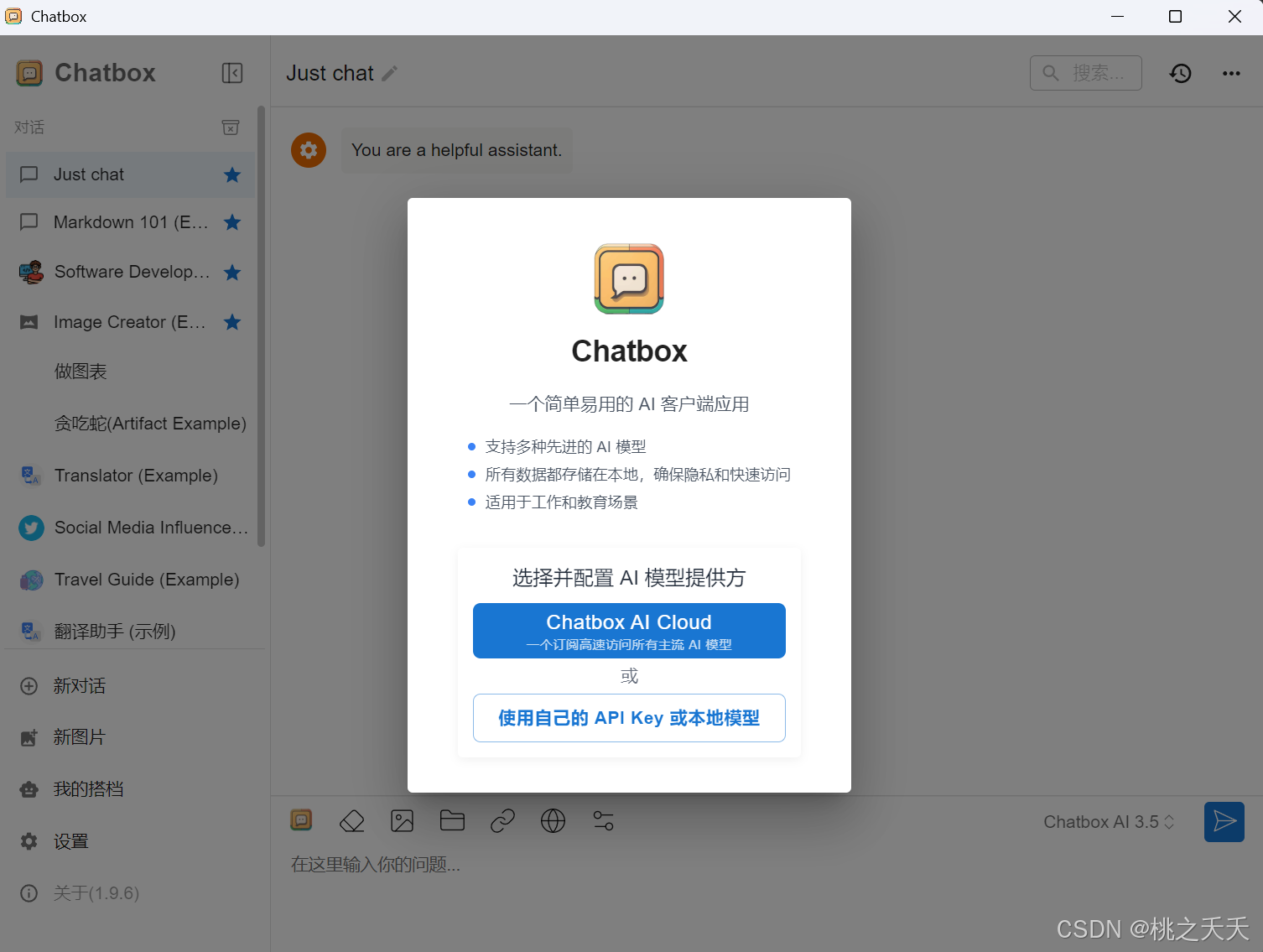

5 安装chatBox AI

Chatbox AI是用于各类大模型交互的聊天界面工具,支持云端、或者本地各类大模型的可视化运行。

5.1 下载chatBox AI

- 访问chatboxAI官网下载软件(网页版不支持ollama调用)。官网地址

https://chatboxai.app/zh

下载后一路正常安装即可。

5.2 配置chatbox环境

- 打开chatbox,选择使用自己的API Key或本地模型,并选择ollama API,系统会读取你本地所有的ollama模型并选择使用。后续如果想用其他的模型,可以在左下角的设置中进行修改。

6 可视化运行deepseek

完成配置后,点击左下角新对话就可以开始运行了。这里我还是让deepseek写了一首诗,效果如下。

至此!可以不依赖网络环境,随时随地调用本地的大模型了。

欢迎与我交流!

CSDN: 桃之夭夭ღhttps://blog.csdn.net/immerseinstudy

公众号: 桃子的AiLab

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)