简话 DeepSeek 本地部署及接口调用

Windows 11 + Ollama + DeepSeek R1 本地部署,简话,感性认识

·

笔记本电脑环境:

1、下载并安装 Ollama

Ollama 是一个用于在本地运行大语言模型(LLMs)的开源工具

- 官网地址:Ollama,下载后双击运行即可完成安装。

- 该程序安装过程中,没有提供选择安装位置选项,因此只能安装到C盘,大概5G左右

- 主程序位置:C:\Users\ml\AppData\Local\Programs\Ollama(4.56G)

- 其它位置:

- C:\Users\ml\.ollama:存放下载后的模型

- C:\Users\ml\AppData\Local\Ollama:存放日志等文件

2、选择模型

选择模型: deepseek-r1: 8 b

操作步骤:官网首页 → 左上角 → Models → deepseek-r1

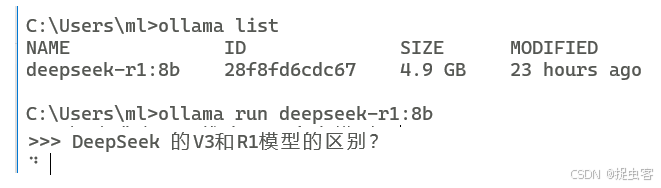

3、运行模型

右键开始图标 → 选择“终端管理员”:

- 在管理员终端中运行命令(即前面一步从官网中复制好的命令):

- 命令:ollama run deepseek-r1:8b

- 等待拉取模型

- 成功后出现 “>>>” 的提示符,在此处输入你的问题回车就可以了

其它有用命令:

- 启动 Ollama 服务:ollama serve

- 查看当前模型列表:ollama list

如运行模型成功后可以提问:

回答如下:

<think>

好的,现在我需要帮助用户理解DeepSeek的V3和R1模型之间的区别。用户之前问过公司推出的大模型,但现在更具体地询问了V3和

R1的不同。

首先,我应该明确这两个模型各自的定位。V3可能是一个通用的大模型,而R1可能专注于特定的领域,比如知识检索或对话应用。这

有助于用户理解它们在不同的应用场景中的用途。

接下来,功能特点方面,我需要列出关键区别,如模型架构、训练目标、性能优化等。V3可能在通用性上更强,而R1则针对高效率和

准确率进行了优化。

用户可能的需求是评估这两个模型是否适合他们的项目,或者了解它们之间的优劣比较。我应该以简明扼要的方式呈现信息,帮助用

户快速做出决策。

最后,总结部分需要简洁明了地指出V3和R1各自适用的场景,这样用户可以根据自己的需求选择最合适的模型。

</think>

DeepSeek 的 V3 和 R1 是两种不同的模型,它们在定位、功能特点和应用场景上有一些区别。以下是它们的主要区别:

### 1. **模型定位**

- **V3**: DeepSeek V3 是一个通用的大模型,旨在提供全面的知识表示和广泛的多任务能力。它可以处理多种类型的问题,并

具备较强的生成、推理和理解能力。

- **R1**: DeepSeek R1 是一个专注于特定领域的模型,可能针对知识检索、对话生成或其他特定任务进行优化,提供更高效率

的解决方案。

---

### 2. **功能特点**

- **V3**:

- 通用性强:支持多种任务,如问答、对话、文本摘要、图像描述等。

- 模型架构:可能基于大规模预训练数据,具备较强的语言理解能力。

- 性能优化:针对计算效率和推理速度进行了优化,使其能够在实际场景中快速响应。

- **R1**:

- 任务专注:可能针对特定任务(如知识检索、对话生成)进行了深度优化,提升在这些任务中的性能。

- 高效率:可能在推理速度或资源消耗上有更大的优化,适合需要快速响应的场景。

- 定制化训练:可能针对特定领域或行业数据进行了定制化训练。

---

### 3. **应用场景**

- **V3**: 适用于多样化的任务,如问答系统、对话机器人、文本摘要等。

- **R1**: 可能专门为特定领域(如教育、医疗、金融)设计,适合需要高效率和准确性的场景。

---

### 4. **总结**

- 如果你需要一个通用的模型来处理多种任务,**V3** 可能是更好的选择。

- 如果你需要一个针对特定领域或任务优化的模型,**R1** 可能更适合你的需求。

希望这些信息对你有帮助!如果你还有其他问题,请随时问我。4、使用 allama_gui

如果需要,可以安装一个简易界面来使用模型

- 安装:python -m pip install ollama_gui

- 运行:python -m ollama_gui

5、API 接口调用

通过代码调用 Ollama 提供的 API 接口,实现模型的能力

常用接口如下:

如:使用 api/chat 接口

import requests

# Ollama中提供的chat功能的API地址

url = 'http://127.0.0.1:11434/api/chat'

# 要发送的数据

data = {

"model": "deepseek-r1:8b",

"messages": [{

"role": "user",

"content": "北京的面积是多少?"}],

"stream": False

}

# 发送POST请求

response = requests.post(url, json=data)

# 打印模型的输出文本

print(response.json()["message"]["content"])

在 PyCharm 中运行输出:

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)